Zespół badaczy użył wykorzystywanego w uczeniu maszynowym narzędzia typu reinforcement learning po to, aby opracowywana sztuczna inteligencja obmyśliła metodę pokonania parkourowej trasy – toru pieszego z przeszkodami, dodajmy, wirtualnego toru. Reinforcement learning jest systemem edukacyjnym, opierającym się o nagrody. Pożądane zachowanie ucznia jest premiowane, niepożądane – nie. W jaki sposób sztuczna inteligencja jest w stanie ocenić “nagrodę”, pozostaje zagadką.

Prace związane z nauczeniem sztucznej inteligencji motoryki, którą każdy przedstawiciel homo sapiens opanowuje w trakcie pierwszego roku życia, trwają od dawna. Tym razem jednak naukowcy postanowili sprawdzić, jak ich wirtualny konstrukt poradzi sobie w bardziej złożonym środowisku niż równa droga. Zmontowano zatem wirtualny tor parkourowy z licznymi przeszkodami i wyznaczono nagrody za postępy w działaniu. Na najbardziej podstawowym poziomie zadanie postawione konstruktowi sztucznej inteligencji było pozornie proste: “przejdź trasę najszybciej, jak to możliwe”.

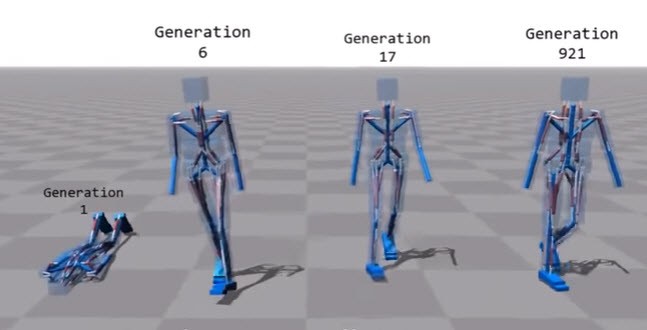

Szczegóły wirtualnego spaceru z udziałem SI zobaczycie w filmie powyżej. Zwróćcie uwagę na fragment, w którym przez długi czas awatar porusza się dość sprawnie, ale absolutnie nietypowo. A nawet zabawnie. To dowód, że niekoniecznie coś, co dla nas wygląda naturalnie, musi być najlepszym rozwiązaniem.

A po co cały ten wirtualny spacer? Ma pomóc w przyszłości opracowywać roboty, które będą umiały poruszać się w każdym terenie. | CHIP