Nigdy się nie poddamy – zapowiada amerykańska National Security Agency (NSA) w planach ujawnionych przez Edwarda Snowdena, obejmujących swoim zakresem rok 2016. Dziennikarz Glenn Greenwald, do którego zwrócił się Snowden, nie ma wątpliwości, że jeśli nic się nie zmieni, to amerykańska agencja wywiadowcza pozostanie na drodze do totalnej inwigilacji Sieci. Bez takich środków obrony jak otwarte oprogramowanie i metody szyfrowania w formule Open Source za kilka lat prywatność w Internecie będzie już nie tyle zagrożona, co po prostu przestanie istnieć. Pytania o to, czy i w jaki sposób da się ją uratować, a także kto stanie w jej obronie, są dziś bardziej palące niż kiedykolwiek wcześniej.

Na razie, wbrew powszechnej krytyce, Amerykanie stale rozbudowują swoje zasoby informatyczne. W połowie ubiegłego roku do Internetu podłączono gigantyczną serwerownię w stanie Utah, w której wciąż przybywa wyposażenia. Pojemność jej dysków jest przedmiotem sporów wśród branżowych ekspertów: szacunki sięgają od mocno przesadzonych jotabajtów (bilionów terabajtów) do bardziej realistycznych 12 eksabajtów (12 milionów terabajtów).Ta druga liczba wydaje się mała w porównaniu z wielkością globalnego ruchu internetowego, przekraczającą jeden eksabajt dziennie, jednak NSA dysponuje kilkoma podobnymi placówkami i nie zamierza na tym poprzestać. Na 2016 rok zaplanowano otwarcie kolejnego kompleksu w Fort Meade – będzie on o połowę mniejszy od tego w Utah. Agencja dysponuje więc zasobami pozwalającymi na ciągłe gromadzenie metadanych dotyczących wszystkich połączeń w Internecie i przynajmniej czasowe przechowywanie obrazu wszystkich przesyłanych treści. Amerykanom nie brakuje też instrumentów umożliwiających przechwytywanie danych. Ogólnie dałoby się je podzielić na trzy grupy: łamanie zabezpieczeń centralnych punktów Sieci, współpraca z obcymi służbami wywiadowczymi oraz tajne nakazy sądowe zmuszające do kooperacji zewnętrzne firmy i instytucje.

Ślepa mania gromadzenia danych

Już od dłuższego czasu wiadomo, że brytyjska agencja Government Communications Headquater (GCHQ) śledzi komunikację przez kable transatlantyckie. Niedawno ujawniono, że złamano również zabezpieczenia interfejsów kabla SEA_ME_WE 3 łączącego Europę i Azję. Zarządza nim belgijska spółka BICS (Belgacom International Carrier Services), należąca do tamtejszego operatora telefonii komórkowej Belgacom. Tym samym Brytyjczycy, włamując się do firmowej sieci, zapewnili współpracującej z nimi NSA dostęp do danych międzynarodowych połączeń telefonicznych przechodzących przez rutery roamingowe Belgacomu.

Jednocześnie NSA sięga po osobiste dane internautów oficjalnymi kanałami. Foreign Intelligence Surveillance Court (FISC) – sąd zbierający się na niejawnych rozprawach – zmusza amerykańskich providerów internetowych i firmy z branży IT do współpracy ze służbami wywiadowczymi. Są wśród nich również działający globalnie operatorzy sieci szkieletowych tacy jak Level 3, obsługujący infrastrukturę stanowiącą kręgosłup Internetu i łączącą mniejsze sieci. Nakazom FISC nie opierają się nawet najwięksi gracze: Google, Microsoft czy Yahoo, którzy przez to nie mogą oferować usług chmurowych faktycznie chroniących prywatność użytkowników. Dotyczy to również oprogramowania tworzonego przez te firmy, jak choćby komunikator Skype należący do Microsoftu. Prawdziwy arsenał NSA jest jednak zaprzęgany do pracy dopiero wówczas, kiedy agencja bierze na cel konkretnego internautę (patrz: ramka po prawej) – wtedy praktycznie nie da się przed nią obronić.

Już dziś widać, że środki i metody NSA są niewyczerpane – pewni swego agenci mówią nawet o “złotym wieku” swojej działalności. Myli się jednak ten, kto sądzi, że obecny stan zaspokaja ich ciekawość i żądzę informacji – by się o tym przekonać, trzeba sięgnąć do dokumentu “SIGINT Strategy”. Tytułowy akronim oznacza “Signal Intelligence” (“rozpoznanie radioelektroniczne”), a w treści dokumentu sformułowano cel agencji NSA na 2016 rok: zbierać wszelkie dane o wszystkich, przez cały czas. Wymienia się tam dosłownie wszystkie ślady, jakie pozostawiamy w Internecie. Jeśli w międzyczasie pojawią się nowe usługi umożliwiające wymianę danych i komunikację, agencja chce natychmiast przygotowywać odpowiednie narzędzia inwigilacji ich użytkowników. Na przeszkodzie mogą stanąć jej tylko dwie kwestie: polityka oraz szyfrowanie danych. NSA obawia się mianowicie, że urzędnicy i politycy nie będą w stanie nadążyć za dynamiką ery informacji, więc uchwalane przez nich przepisy będą – z punktu widzenia agencji – za mało restrykcyjne. Żadnych obaw nie budzą za to ewentualne próby ograniczania działań NSA – i wydaje się to uzasadnione: plany reformy agencji wychodzące od administracji prezydenta Obamy są raczej zachowawcze. Co prawda, przewidują one więcej transparentności w postępowaniach FISC, jednak podsłuchiwanie i zbieranie prywatnych danych nie zostanie w żaden sposób ograniczone. Skutecznym sposobem na uniknięcie masowej inwigilacji byłoby silne szyfrowanie danych. Aby tego uniknąć, NSA chce utrzymywać zakulisowe wpływy wśród producentów komercyjnego oprogramowania zabezpieczającego i rozwijać własne narzędzia do walki z technologiami kryptologicznymi. Agenci chcieliby zachować możliwość odczytywania dowolnych treści nawet wówczas, gdyby szyfrowaniem został objęty cały ruch w Internecie.

Ucieczka od wszechobecnej inwigilacji

Świat w 2016 roku może jednak wyglądać zupełnie inaczej, niż wyobraża sobie NSA. Jednym ze scenariuszy jest podział globalnej Sieci i skupienie jej elementów wokół centrów regionalnych. Na forum Unii Europejskiej z takim pomysłem wystąpił szef Deutsche Telekomu René Obermann. Idea sieci obejmującej strefę Schengen bądź budowy wewnętrznych sieci w poszczególnych krajach spotkała się jednak z powszechną krytyką. Oprócz tego sterowanie przepływem danych w taki sposób, by przebiegał on wyłącznie przez węzły na obszarze jednego państwa czy też grupy państw, byłoby zaprzeczeniem obecnie stosowanych zasad rutowania w Internecie. Składa się on z wielu niezależnych systemów autonomicznych, sterujących jedną bądź wieloma sieciami IP i zarządzanych przez providerów, między którymi występują znaczące różnice wielkości i zasięgu działania.

Na najwyższym poziomie Sieci (Tier 1) działają przedsiębiorstwa takie jak Level 3 czy Verizon, obsługujące sieć szkieletową. Najniżej (Tier 3) znajdują się lokalni dostawcy łączy szerokopasmowych, dających dostęp do Internetu większości użytkowników. Co ważne, niektóre firmy, jak właśnie Deutsche Telekom czy francuski Orange, działają jednocześnie na obu poziomach. Strumienie danych przebiegają zwykle przez wiele autonomicznych podsieci, których operatorzy zawierają ze sobą tzw. umowy o peering określające warunki i stawki wzajemnych rozliczeń. Połączenia między tymi podsieciami często znajdują się w węzłach internetowych takich jak największy na świecie DE-CIX we Frankfurcie nad Menem. Połączenia z tym węzłem mają podsieci należące nie tylko do europejskich firm, ale też do globalnych przedsiębiorstw z siedzibami w USA, np. Verizonu. Przez cały czas przepływają przez nie ogromne strumienie wszelkiego rodzaju danych. Tylko sieć Verizonu składa się z 700 000 km światłowodów (to prawie 20 długości równika!), w tym 80 kabli podmorskich. Może więc się zdarzyć, że ruch od jednego europejskiego providera do innego będzie na pewnym odcinku przebiegał przez łącza Amerykanów. Dokładną drogę przepływu danych – bezpośrednio przez obszar jednego kraju bądź naokoło – Verizon ustala na podstawie czynników natury technicznej, obejmujących obciążenie własnych łączy i ruterów oraz koszty transferu.

Sieć strefy Schengen to ślepa uliczka

Hipotetyczna wewnętrzna sieć strefy Schengen musiałaby opierać się na ignorowaniu tego rodzaju uwarunkowań i wymuszać przesyłanie danych wyłącznie przez łącza wybranych operatorów na ograniczonym obszarze geograficznym. Wiązałoby się to ze zwiększonym ryzykiem powstania wąskich gardeł na stykach odrębnych podsieci. W tej sytuacji duzi operatorzy, jak wspomniany Deutsche Telekom, mogliby żądać od lokalnych providerów dodatkowych opłat za bezpośrednie przesyłanie danych za pośrednictwem swojej infrastruktury. W kłopocie znalazłyby się za to duże, otwarte węzły internetowe. Nic więc dziwnego, że dyrektor węzła DE-CIX określił propozycję szefa Deutsche Telekomu mianem “akcji marketingowej i politycznej manipulacji”. Tak czy owak, korzyści płynące z budowy sieci strefy Schengen wydają się iluzoryczne: łamanie zabezpieczeń operatorów i przechwytywanie danych płynących przez ich łącza nadal byłoby możliwe, a poza tym większa część ruchu internetowego i tak nie ogranicza się do obszaru UE. Wystarczy przyjrzeć się prostym zapytaniom do wyszukiwarki Google. Chociaż dwa z trzynastu centrów danych Google’a znajdują się w Irlandii i Finlandii, to wewnętrzna sieć firmy umożliwia wykonywanie kopii zapasowych na płaszczyźnie globalnej oraz przekazywanie zapytań do innych, mniej obciążonych serwerowni – na przykład w USA.

Wszystkie duże firmy internetowe z tej kategorii wagowej co Google, Microsoft czy Yahoo dysponują autonomicznymi sieciami obsługującymi komunikację wewnętrzną. Nie są one połączone z Internetem, a płynące przez nie dane od dawna nie są szyfrowane (patrz: ramka po prawej stronie). Właściciele wspomnianych sieci z pewnością nie byli zachwyceni, dowiadując się, że NSA zinfiltrowała również tę infrastrukturę. Niektórzy, w tym Microsoft oraz Yahoo, zareagowali na to, wprowadzając szyfrowanie. Oprócz tego coraz więcej usług internetowych oferuje bezpieczną transmisję danych aż do klienta końcowego, używając protokołu HTTPS. Nic dziwnego, gdyż zdaniem analityków rynku z firmy Forrester Research rewelacje Snowdena mogą przynieść amerykańskim usługodawcom nawet 180 miliardów dolarów strat w ciągu dwóch najbliższych lat.

Ostatnie wyjście – szyfrowanie

Silne szyfrowanie uchodzi wśród ekspertów za najlepszą i w zasadzie jedyną skuteczną metodę obrony przed inwigilacją (patrz: wywiad po prawej stronie). W tym przypadku diabeł – czyli NSA – tkwi w szczegółach. Dotychczas nowe standardy kryptograficzne były wprowadzane pod kierunkiem USA. Praktycznie cała branża informatyczna podporządkowuje się wytycznym National Institute of Standards and Technology (NIST), m.in. dlatego, że są one wiążące dla amerykańskich organów administracyjnych. Wytyczne te określają również funkcjonalność narzędzi szyfrujących i wykorzystywane przez nie algorytmy. NIST jest jednak zobowiązany do współpracy z NSA, ponieważ jednym z zadań agencji wywiadowczej jest ochrona amerykańskiej cyberprzestrzeni. Informacje ujawnione przez Snowdena potwierdziły wcześniejsze podejrzenia, że generator liczb pseudolosowych Dual_EC_DRBG zawiera backdoora umożliwiającego NSA szybkie łamanie szyfrowania. Oprócz tego agencja miała zapłacić RSA Security 10 milionów dolarów za to, że Dual_EC_DRBG będzie domyślnym generatorem w bibliotece kryptograficznej BSAFE oferowanej przez tę firmę. RSA nie jest przy tym byle jaką firemką – założyli ją naukowcy, którzy opracowali algorytm szyfrujący RSA zabezpieczający niemal wszystkie połączenia HTTPS.

Sposobem na ostudzenie zapędów NSA byłoby wprowadzenie szyfrowania całego ruchu internetowego, jednak wymagałoby to rewizji standardów kryptograficznych przynajmniej w obrębie Unii Europejskiej. Instytucja, która mogłaby tego dokonać, już istnieje – to Europejska Agencja Bezpieczeństwa Sieci i Informacji (ENISA), która, podobnie jak NIST, wydaje rekomendacje dotyczące metod szyfrowania. Wytyczne ENISA opublikowane w listopadzie zeszłego roku zalecają unikanie uchodzącej za skompromitowaną metody RC4. Zadowolenie z tego faktu wyrazili krytyczni wobec NSA eksperci zwracający uwagę, że NSA może łamać niektóre warianty szyfrowania RC4 w czasie rzeczywistym. Mimo to większość serwerów wciąż posługuje się wspomnianą metodą podczas nawiązywania szyfrowanych połączeń HTTPS (patrz: ramka po prawej).

Dostępność niezawodnych algorytmów szyfrujących stanowi więc tylko pierwszy krok do bezpiecznej Sieci. Drugim – o wiele ważniejszym – jest ich powszechne stosowanie. Wezwać do tego mogłaby Internet Engineering Task Force (IETF), organizacja zajmująca się rozwojem kolejnych wersji protokołu HTTP. Według Marka Nottinghama – przewodniczącego grupy projektowej HTTPbis – twórcy Firefoxa i Chrome’a zgłosili pomysł, by protokół HTTP 2.0 zapewniał stałe szyfrowanie komunikacji. Największą przeszkodą dla takiego rozwiązania jest konieczność posiadania przez serwer certyfikatu umożliwiającego jego identyfikację przez użytkowników. Jego uzyskanie wiąże się jednak z kosztami, które co prawda nie stanowią problemu dla dużych operatorów takich jak Google, ale dla mniejszych firm mogą okazać się nie do udźwignięcia.

Z tego względu Nottingham preferuje rozwiązanie spoza standardu: szyfrowanie miałoby pozostać nieobowiązkowe dla serwerów obsługujących HTTP 2.0, jednak – inaczej niż w przypadku protokołu HTTP 1.1 – przyszłe wersje przeglądarek miałyby same żądać od serwera szyfrowania połączenia. Wówczas serwery, które nie byłyby w stanie zapewnić szyfrowania, nawiązywałyby wyłącznie połączenia HTTP 1.1, o czym w idealnym przypadku użytkownik byłby natychmiast informowany. Ponadto IETF dyskutuje o możliwości szyfrowania danych bez użycia certyfikatów. Metoda Relaxed TLS nie chroniłaby przed ukierunkowanymi atakami hakerskimi, ale przynajmniej uczyniłaby bezużytecznym przechwytywanie całego strumienia danych płynącego np. przez kable podmorskie. Gdyby dodatkowo zastosować algorytm Perfect Forward Secrecy (PFS), służby wywiadowcze nie miałyby szans odszyfrować treści zarejestrowanych w ten sposób komunikatów. Inaczej niż typowe metody szyfrowania asymetrycznego, PFS wykorzystuje do kodowania komunikacji między serwerem a przeglądarką parę jednorazowych kluczy, kasowanych po zakończeniu połączenia. Przy szyfrowaniu asymetrycznym na serwerze pozostaje klucz publiczny, który mogą przechwycić agenci wywiadu czy hakerzy.

Zaszyfrowane usługi internetowe

Skutecznym algorytmom kryptograficznym i upowszechnieniu szyfrowania w Internecie musi towarzyszyć odpowiednie oprogramowanie i usługi. Dziś liczne usługi chmurowe szyfrują połączenie od i do użytkownika, jednak same dane są przechowywane na serwerze w formie jawnej. Lepszym rozwiązaniem byłoby szyfrowanie danych po stronie klienta, czyli jeszcze przed przesłaniem ich na serwer usługi. Klucz niezbędny do odszyfrowania plików jest wówczas przechowywany na komputerze użytkownika. Takie rozwiązanie oferuje już wiele serwisów, jak choćby Spideroak (patrz: ramka po prawej stronie) czy Wuala, jednak te najbardziej znane – np. Dropbox – zarządzające dużymi ilościami danych, niekoniecznie są nim zainteresowane. Szyfrowanie po stronie klienta uniemożliwia bowiem deduplikację, czyli zapisywanie tylko jednej kopii tego samego pliku załadowanego na serwer niezależnie przez wielu użytkowników. Deduplikacja zmniejsza ilość potrzebnej przestrzeni dyskowej, a więc obniża koszty świadczenia usług. Użytkownicy Dropboxa mogą jedynie posiłkować się rozszerzeniami szyfrującymi wysyłane dane.

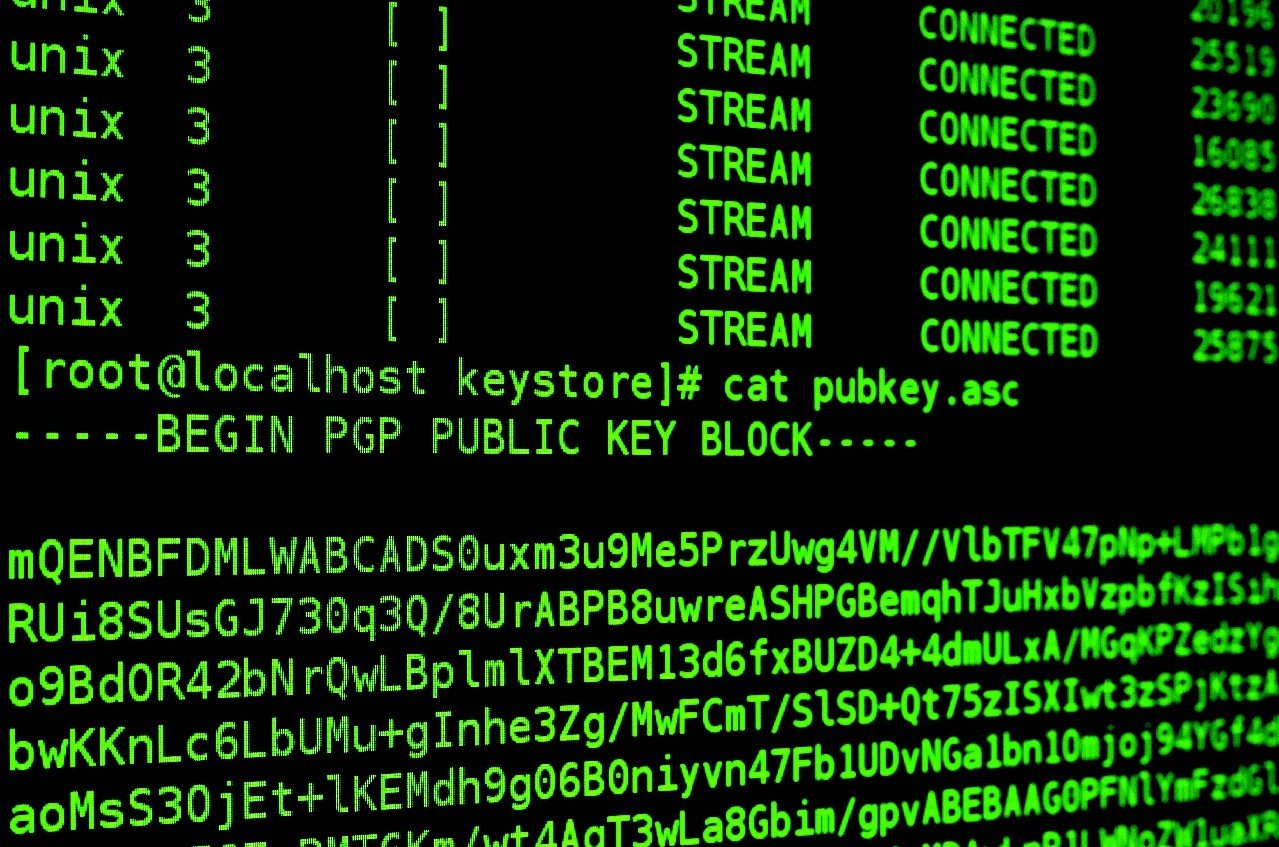

W jeszcze ciemniejszych barwach przedstawia się kwestia ewentualnego szyfrowania poczty elektronicznej. Aby dało się to zrealizować, nadawca i odbiorca wiadomości musieliby najpierw wymienić się swoimi kluczami publicznymi służącymi do dekodowania treści. Co prawda, istnieją narzędzia takie jak GnuPG, które to umożliwiają, jednak stosowanie wspomnianej metody na szerszą skalę byłoby niepraktyczne. Poza tym bezpłatne usługi emailowe, jak na przykład Gmail, utrzymują się z analizowania treści wiadomości i wyświetlania dopasowanych do niej reklam. Wprowadzenie szyfrowania emaili by to uniemożliwiło, a także uczyniłoby bezużytecznymi wszelkie filtry antyspamowe. Łatwiejsze w implementacji byłoby szyfrowanie komunikacji w czasie rzeczywistym, na przykład za pośrednictwem czatów. Co więcej, usługa BitTorrent Chat, będąca obecnie na etapie wersji alpha, całkowicie rezygnuje z centralnych serwerów i opiera się na szyfrowaniu bezpośredniej komunikacji między użytkownikami metodą PFS.

Niezależnie od tego, jak zakończy się skandal związany z NSA, Internet musi się zmienić, bo przecież nikt nie chce, by nad główną platformą komunikacyjną całej ludzkości zawisło widmo Wielkiego Brata. Na szczęście skutki najcięższego grzechu NSA – sabotowania uznanych standardów kryptograficznych – da się jeszcze odwrócić. Dzięki temu, być może, uda się zbudować stabilny i bezpieczny Internet, dodatkowo chroniony przed atakami hakerów.

Tak szpieguje nas NSA

Szpiegowski arsenał Amerykanów umożliwia im inwigilację całego Internetu na globalną skalę. Jeszcze potężniejsze są instrumenty do precyzyjnej kontroli pojedynczych osób. Praktycznie nie ma przed nimi obrony – chyba że wyłączy się komputer.

Internet

|

Komunikacja sieciowa |

Przechwytywanie danych w punktach węzłowych i interfejsach kabli podmorskich |

|

Rutery |

Przekierowywanie danych na serwery NSA za pośrednictwem backdoorów |

|

Sieci korporacyjne |

Śledzenie komunikacji między centrami danych |

|

Szyfrowanie |

Umieszczanie i wykorzystywanie luk w algorytmach kryptograficznych |

|

Wideoczaty |

Podsłuchiwanie rozmów przez Skype’a |

|

Dyski internetowe |

Odczytywanie treści zapisanych w chmurze na podstawie tajnych wyroków sądowych |

Oprogramowanie

|

System operacyjny |

Odkrywanie nieznanych luk, włamania przez sieci WLAN |

|

Przeglądarka |

Instalacja koni trojańskich poprzez spreparowane strony WWW |

|

Pliki cookie |

Żądanie od Google’a plików cookie typu PREF i analizowanie ich |

|

Programy |

Wykorzystywanie exploitów, manipulowanie pobieraniem plików |

Sprzęt komputerowy

|

BIOS |

Śledzenie całej aktywności systemu przez rootkity |

|

Dysk twardy |

Przechwytywanie transferu danych do pamięci wewnętrznej |

|

Monitor |

Zapisywanie zrzutów ekranu |

|

Kamera internetowa |

Włączanie kamery i fotografowanie użytkownika |

|

Klawiatura |

Zapisywanie sekwencji wciskanych klawiszy |

|

Złącze USB |

Śledzenie transmisji danych |

Surfowanie bez NSA

CHIP rozmawia z prof. Norbertem Pohlmannem, dyrektorem Instytutu Bezpieczeństwa Internetu w Westfalskiej Szkole Wyższej w Gelsenkirchen

Sieć strefy Schengen ma powstrzymać NSA. Czy to możliwe?

Spośród 50 000 sieci IP tworzących Internet kilkanaście tysięcy działa na obszarze Unii Europejskiej. Nawet jeśli wziąć pod uwagę tylko połączenia między serwerami na terenie jednego kraju UE, statystycznie ponad 20 proc. z nich przebiega przez łącza zagranicznych providerów, będące pośrednimi lub bezpośrednimi łącznikami między sieciami IP. Ograniczanie tego udziału ma, z technicznego punktu widzenia, niewiele sensu. Infrastruktura przenosząca połączenia między sieciami IP przebiega przez pola i lasy, a także po dnie mórz – i da się ją podsłuchiwać.

Za najlepszą obronę uchodzi implementacja skutecznych algorytmów szyfrowania. Czy jesteśmy na to przygotowani?

Jedynie pewne i niezawodne szyfrowanie ochroni internetową komunikację przed inwigilacją. W tym względzie już dawno zdaliśmy się na Amerykanów, ponieważ dysponują oni efektywnym systemem wprowadzania nowych mechanizmów kryptograficznych. Kryptologia jest jednak rozwijana również w Europie – za przykład może służyć algorytm AES czy nowy standard haszowania SHA-3. Brakuje jedynie inicjatyw ze strony europejskich ekspertów i firm, mających na celu globalną implementację nowych rozwiązań.

Jakie widzi pan wyjście z kryzysu wywołanego działaniami NSA?

Obecnie używamy niebezpiecznych rozwiązań informatycznych – choćby skuteczność programów antywirusowych jest niewystarczająca. Musimy zacząć od optymalizacji dostępnych narzędzi, a później konsekwentnie je wprowadzać. Firmy powinny szyfrować swoje dane, używając godnego zaufania oprogramowania wolnego od backdoorów czy skompromitowanych algorytmów. Ponadto potrzebujemy współpracy między politykami, przedsiębiorstwami i ekspertami. Europejskie technologie zabezpieczeń i jakość badań kryptograficznych stoją na równi z amerykańskimi, ale zbyt rzadko owocują produktami dostępnymi również dla przeciętnych użytkowników. Dobrym punktem wyjścia są moim zdaniem projekty mające na celu wprowadzenie ciągłego szyfrowania poczty elektronicznej. Cieszy też fakt, że certyfikaty SSL są coraz częściej wydawane przez europejskie instytucje.