SI na wypasie. Superkomputer CS-3 z procesorem WSE-3

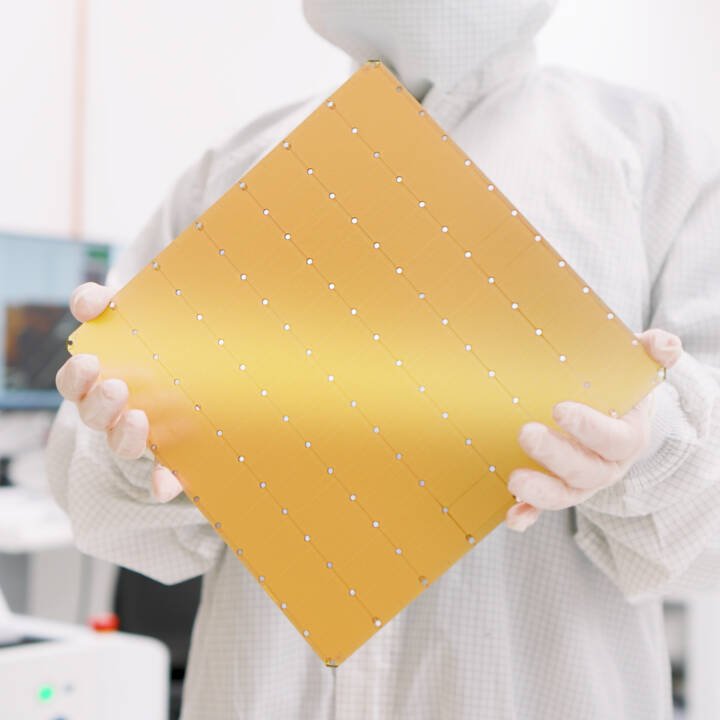

Dwa i pół roku temu pisałem o tym, jak to Cerebras WSE-2 (Wafer Scale Engine) jest “najnowszym procesorem, który przewyższa możliwościami ludzki mózg“. Mierzący tyle, ile typowy krzemowy wafel do produkcji procesorów (46225 mm2) i wykonany w technice 7-nm układ Cerebras WSE-2 ma w sobie aż 2,6 biliona tranzystorów. Ten procesor może obsługiwać modele SI ze 120 trylionami parametrów, czyli osobnych części modelu, składających się na algorytmy uczenia maszynowego. To właśnie dlatego jest “lepszy od człowieka”, bo przewyższa liczbę 100 trylionów synaps obecnych w naszych mózgach.

Czytaj też: Sztuczna inteligencja pomoże w namierzeniu nowych materiałów do wychwytywania dwutlenku węgla

Wspominam o tym wszystkim nie bez przyczyny, bo tak się składa, że najnowszy procesor firmy Cerebras Systems z Kalifornii przewyższa poprzednika aż dwukrotnie. To Cerebras WSE-3 wykonany w technice 5-nm, który może szkolić modele z aż 70 miliardami parametrów w tylko jeden dzień, wykorzystując do tego wspomniane cztery biliony tranzystorów, co rzuca głęboki cień np. na akcelerator H200 firmy NVIDIA z 80 miliardami tranzystorów. 57-krotnie wyższa liczba tych półprzewodnikowych elementów przekłada się na 900000 rdzeni zoptymalizowanych specjalnie dla przetwarzania danych sztucznej inteligencji w superkomputerze.

Firma pochwaliła się, że superkomputer CS-3, w którym to Cerebras WSE-3 jest głównym bohaterem, wyróżnia się aż 44 GB pamięci SRAM (ta może przechowywać nawet 24 biliony parametrów), którą można wspomóc pamięcią zewnętrzną o pojemności od 1,5 terabajta do aż 1,2 petabajta, aby umożliwić szkolenie modeli dziesięć razy większych niż GPT-4 czy Gemini. To robi wrażenie, co podkreśla deklaracja firmy, wedle której szkolenie modelu z jednym bilionem parametrów na CS-3 jest tak proste, jak szkolenie modelu z jednym miliardem parametrów na chipach GPU.

Czytaj też: Gwiezdne źródło energii uratuje ludzkość. Sztuczna inteligencja pomogła w zwalczeniu istotnego problemu

Zaprojektowany, aby sprostać wszystkim dzisiejszym wymaganiom, superkomputer CS-3 może być konfigurowany w sposób, który sięga od dopracowywania modeli SI z 70 miliardami parametrów dziennie w czterosystemowej konfiguracji do szkolenia modelu Llama z 70 miliardami parametrów od zera w ciągu dnia przy użyciu konfiguracji 2048 systemów. Wszystko to w ramach tego samego pakietu o tym samym poborze mocy mimo dwukrotnie wyższej wydajności względem poprzedników.

Czytaj też: Sztuczna inteligencja i rower. Duet dziwaczny, ale przynajmniej pierwszy taki na świecie

Jednym z innych przełomowych aspektów WSE-3 jest znaczące zmniejszenie złożoności kodowania wymaganego do szkolenia dużych modeli językowych (LLM). Z WSE-3, implementacja modelu wielkości GPT-3 wymaga 97% mniej kodu niż na GPU. Dziś możemy się tylko cieszyć, że Cerebras już ogłosił swoje plany wdrożenia WSE-3 we współpracy z renomowanymi instytucjami takimi jak Argonne National Laboratory i Mayo Clinic, obiecując znaczące wzmocnienie możliwości badawczych. Ponadto, we współpracy z G42, Cerebras konstruuje Condor Galaxy-3 (CG-3), który ma być jednym z największych superkomputerów SI na świecie, zawierającym 64 jednostki CS-3 o łącznej mocy ośmiu eksaFLOPS mocy obliczeniowej.