Efekt: 100 milionów ludzi w północnej Afryce i wielu w krajach azjatyckich musiało radzić sobie przy ograniczonym dostępie do Internetu. Fakt, że strony internetowe ładowały się o połowę wolniej niż zwykle, był najmniejszym problemem. Gorsze było to, że nikt w Kairze nie mógł kupić biletów lotniczych przez Sieć, bowiem nie można było uzyskać dostępu do międzynarodowego systemu bookingowego. Maklerzy pracujący na giełdach papierów napotykali trudności w składaniu zamówień w centrach finansowych na całym świecie. Dubaj był w kropce: uniwersytety, niektóre centra handlowe, a nawet sztuczna wyspa Jumeirah (w kształcie palmy) zostały odcięte od globalnej Pajęczyny. W Indiach, zgodnie z doniesieniami agencji informacyjnych, dostępne było jedynie około 60 proc. zwykłej przepustowości łączy. Musiały minąć aż dwa tygodnie, by wszystko wróciło do normy. Tyle czasu zajęło statkom naprawczym wyłowienie z morza końcówek uszkodzonych kabli i połączenie ich na nowo.

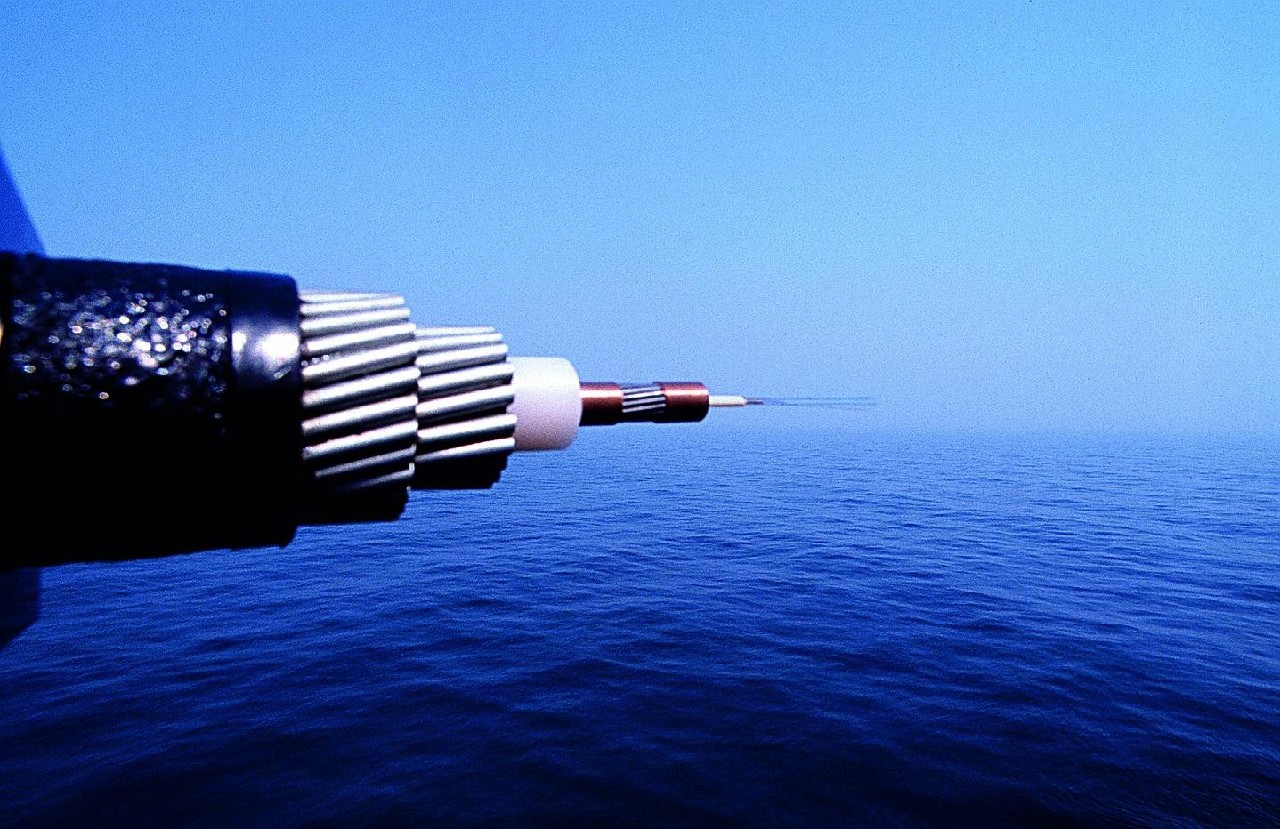

Takie kable rozciągają się od Atlantyku przez Pacyfik, Morze Śródziemne po Morze Północne i Bałtyckie. Ponad milion kilometrów kabli światłowodowych biegnie przez morskie piaski, które łączą obie Ameryki, Europę, Afrykę, Australię i Azję. Tworzą one globalną sieć i obsługują około 95 proc. internetowego ruchu. Stanowią kręgosłup Internetu. Najnowocześniejsze przesyłają ponad 2500 GB na sekundę, nawet jeśli są niewiele grubsze niż strażacki wąż. Kilka splecionych warstw wykonanych z wytrzymałych materiałów chroni cenne wnętrze przed słoną wodą, ciekawskimi mieszkańcami morza i wysokim ciśnieniem panującym w najgłębszych głębinach. Niestety, ta ochrona nie zawsze jest wystarczająca.

Internet nie może działać bez podmorskich kabli

Awarie podwodnej infrastruktury nie są nowością. W grudniu 2006 roku kilka kabli położonych na dnie morza zostało poważnie uszkodzonych podczas trzęsienia ziemi u brzegów Tajwanu. W efekcie połowa południowo-wschodniej Azji została odcięta od Sieci. W 2003 roku przerwana została transatlantycka arteria ogólnoświatowej Pajęczyny o nazwie TAT-14 (łącząca USA z krajami europejskimi). Z tego powodu Brytyjczycy musieli łączyć się z Siecią za pomocą łącza o przepustowości 2 Gb/s, podczas gdy

w tym czasie standardem były dla nich 32 Gb/s. W gorszej sytuacji znaleźli się mieszkańcy Islandii, którzy w 2002 roku musieli obejść się bez Internetu, bowiem przerwana została jedyna nitka łącząca ze światem ten położony na dalekiej północy kraj.

Podwodne kable kładziono już w połowie XIX wieku. Od początku lat 80. ubiegłego wieku stosuje się światłowody. Mimo powtarzających się awarii światłowody pozostają rozwiązaniem, na którym można najbardziej polegać. Nie ma zresztą dla nich sensownej alternatywy. Teoretycznie międzykontynentalną transmisję danych mogłyby obsługiwać satelity, ale są one niezwykle kosztowne w utrzymaniu i mogą przesyłać mniejsze ilości danych.

Globalna sieć światłowodowa jest tak gęsto połączona, że nawet kilka jednoczesnych awarii nie spowoduje jej wyłączenia. Wiele międzynarodowych przedsiębiorstw, które przeniosły do Indii całe swoje działy, nigdy nie doświadczyło problemów związanych z utratą łącza. Wykorzystują one bowiem systemy, na które składa się kilka zapasowych połączeń. W razie awarii jednego z nich ruch kierowany jest przez pozostałe.

Także w Europie wyłączenie Internetu jest praktycznie niemożliwe. Z Ameryką Północną łączy nas 15 podmorskich kabli, z których większość ma odpowiedniki biegnące alternatywną trasą. Można być więc pewnym, że kotwica żadnego pojedynczego statku nie sparaliżuje całej Sieci w Europie. Najbardziej wydajne spośród tych kabli przesyłają dane z szybkością 640 GB na sekundę, zatem ich łączne możliwości przesyłowe to 2,5 TB/s – wystarczająco dużo, by obsłużyć cały obecny ruch w polskim Internecie. To na razie zapewnia spokój, ale do czasu.

Szybkość przesyłania danych może drastycznie spaść

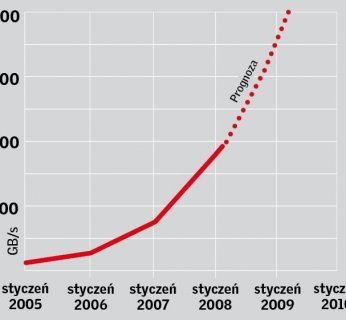

Podnoszą się głosy ostrzegające przed możliwym zakorkowaniem się Internetu. Zgodnie z wynikami badań przeprowadzonych przez amerykańską firmę Nemertes Research, najpóźniej w 2010 roku szybkość, z jaką będziemy surfować, może znowu spaść do tej z czasów modemów 56k. Kwota 50 miliardów dolarów, którą w nadchodzących latach zainwestują firmy telekomunikacyjne w rozwój sieci transmisyjnych, może okazać się niewystarczająca. “Potrzeba trzykrotnie większych inwestycji, by sieci przesyłowe miały bezpieczną przepustowość” – twierdzą eksperci z firmy Nemertes. Zapotrzebowanie na łącza zdolne przesyłać duże ilości danych niezmiernie wzrośnie ze względu na aplikacje multimedialne takie jak streaming wideo.

Jak to zwykle bywa, wspomniana analiza została przeprowadzona na czyjeś zlecenie. W tym przypadku sfinansowało ją amerykańskie stowarzyszenie zrzeszające dostawców łączy internetowych, którzy dążą do wprowadzenia zmian w rozliczeniach pomiędzy dostawcami Internetu a dostawcami treści. Ich plan zakłada, że właściciele największych portali, takich jak Google, MySpace czy Yahoo!, powinni płacić “sieciowe myto” za to, by ich strony były szybko dostępne. Dostawcy argumentują, że w ten sposób można zebrać środki na gigantyczne inwestycje, które pozwoliłyby utrzymać obecny stan – szybką i stabilną Sieć.

Choć wiele europejskich firm telekomunikacyjnych przychylnie patrzy na działania amerykańskich kolegów, to idea ma także wielu przeciwników. Między serwerem a użytkownikiem dane są częściowo przekazywane przez dziesiątki sieci. Jeśli każdy operator sieci wchodzącej w skład tego łańcucha wyciągnie rękę po swoją dolę, wówczas natychmiast zablokujemy Internet – uważają oponenci.

Myto za wysoką szybkość

Tworzenie nowych połączeń to jednak nie wszystko. Konieczna jest także modernizacja istniejących już sieci: szybki transfer danych odbywa się często przy wykorzystaniu elementów przestarzałych technologii. Ciągle w wielu wypadkach następuje rozdział między sieciami telefonicznymi

a sieciami danych. Przyszłościowym rozwiązaniem jest sieć pozwalająca na zaimplementowanie każdego rodzaju aplikacji – otwierająca wirtualną drogę ku “Internetowi 3.0”. Za pośrednictwem tej sieci można przesyłać sygnał telewizyjny i radiowy, obsługiwać odtwarzacze MP3, a nawet inteligentne lodówki.

Sieć inteligentna automatycznie rozpoznaje podłączone urządzenia i przydziela przeznaczone dla nich usługi – sygnał wideo do telewizora, strumień audio do systemu stereo itp. Na dodatek jest prosta w obsłudze: oferuje automatyczną konfigurację sprzętu. W większości przypadków konfiguracja ograniczać się będzie do podania nazw i haseł użytkowników.

Jednak nie wszyscy są tak podekscytowani technologią inteligentnych sieci. Krytycy zwracają uwagę na to, że pozwala ona kontrolować szybkość przesyłu danych. Dostawcy łączy szerokopasmowych mogliby tym samym decydować, z jaką szybkością będą ładować się nam dane strony WWW. Idea neutralności Sieci, dzięki której mamy pewność, że wszystkie treści w Internecie są sobie równe – i dostępne z tą samą szybkością – odeszłaby w przeszłość. Przygnębiający scenariusz przyszłości mógłby wyglądać w ten sposób: internetowi giganci z wypchanymi kontami mogliby wykupić potrzebne łącza szerokopasmowe. Małe start-upy i zwykli blogerzy musieliby zadowolić się powolnym Internetem.

Pojawią się kolejki do Internetu

Dynamiczny rozwój Internetu niesie ze sobą kolejny problem. Rosnąca w lawinowym tempie ilość podłączonych do niego urządzeń sprawia, że wkrótce może wyczerpać się liczba dostępnych adresów IP. Każdy komputer potrzebuje własnego adresu, by móc połączyć się z Siecią. To samo dotyczy komórki, telewizora czy samochodu, które wkrótce również będą online. Tymczasem stosowany obecnie standard IPv4 zapewnia jedynie 4 mld adresów. Z badań przeprowadzonych przez organizację Internet Assigned Numbers Authority, która reguluje alokację adresów IP w Internecie, wynika, że ostatni adres IPv4 zostanie alokowany 24 lipca 2011 roku. Wówczas surfowanie stanie się męką. Powstanie taki korek, jak przed wielkim parkingiem: można wjechać tylko wtedy, kiedy ktoś inny wyjedzie.

By sprawdzić pocztę, będziemy musieli poczekać, aż ktoś inny przestanie korzystać z Internetu. Na razie sytuacja nie jest jeszcze alarmująca, ale wkrótce zrobi się gorąco. Jest już dostępne rozwiązanie: protokół iPv6, jednak jego implementacja następuje bardzo powoli. Nowy protokół może reprezentować aż 340 tryliardów adresów – gwoli jasności, tryliard to jedynka i 36 zer. Ponadto IPv6 umożliwia szyfrowanie ruchu i nadawanie priorytetu konkretnym usługom (np. strumieniom muzyki i wideo). Pozostaje mieć nadzieję, że zdążymy z tą aktualizacją.