Choć do wykonania najnowszego eksperymentu potrzeba tyle prądu, ile wynosi zapotrzebowanie sporej metropolii, to u zarania Internetu w CERN stawiano na oszczędność. Fama głosi, że pierwszy serwer był notorycznie wyłączany przez sprzątaczki. Dlatego umieszczono na nim ostrzeżenie: “Nie wyłączać! To jest serwer!”.

W tamtych czasach naukowcy szukali sposobu na to, by wymieniać się informacjami z kolegami po fachu rozsianymi po różnych częściach globu. W efekcie powstała sieć WWW. Teraz naukowcy znowu potrzebują narzędzia do wymieniania się danymi z kolegami. Jednak tym razem sprawa nie dotyczy dokumentów ważących kilka kilobajtów, lecz ogromnych ilości danych powstających przy okazji eksperymentów. Ten nowy system musi być zdolny do udostępnienia fizykom z całego świata nawet 90 milionów GB, czyli 90 petabajtów, danych.

Te niewyobrażalne ilości danych są produkowane przez największą maszynę, jaką kiedykolwiek zbudował człowiek: LHC. W jego skład wchodzi długi na 26,7 kilometra pierścień, w którym przyspieszane są cząsteczki. Mieści się on w tunelu zakopanym 100 metrów pod powierzchnią ziemi. Na początku września naukowcy z CERN po raz pierwszy wprawili maszynę w ruch. Zanim jednak doszło do zderzenia ze sobą protonów pędzących z prędkością światła, LHC się zepsuł. Z powodu wycieku helu rozpoczęcie badań przesunięto o około 2 miesiące. To jednak nie przeszkodzi w przeprowadzeniu tego imponującego eksperymentu, warto więc poznać parę faktów.

Prowadzi go 5 tys. naukowców pracujących w 300 instytutach w 50 krajach: w czterech różnych eksperymentach fizycy chcą udowodnić istnienie cząsteczek na razie znanych tylko w teorii, takich jak np. cząsteczka Higgsa. Co więcej, badacze chcą odtworzyć warunki panujące tuż po Wielkim Wybuchu i tym samym zyskać szansę zbadania formy, w jakiej znajdowała się materia tuż po nim, tzw. plazmy kwarkowo-gluonowej. Uczeni pragną także znaleźć przyczyny powstawania mały czarnych dziur albo natrafić na czarną cząsteczkę, której wciąż jeszcze nie udało się wykryć na Ziemi.

Tsunami danych: 600 terabajtów na sekundę

Naukowcy od lat budowali urządzenia badawcze, by móc przeprowadzić te przełomowe eksperymenty. Choć samo zderzenie cząstek zajmie tysięczne części sekundy, odpowiedzi na frapujące pytania znane będą dopiero po przeanalizowaniu niewyobrażalnej ilości danych. Do ich przetwarzania zbudowano potężny system komputerowy.

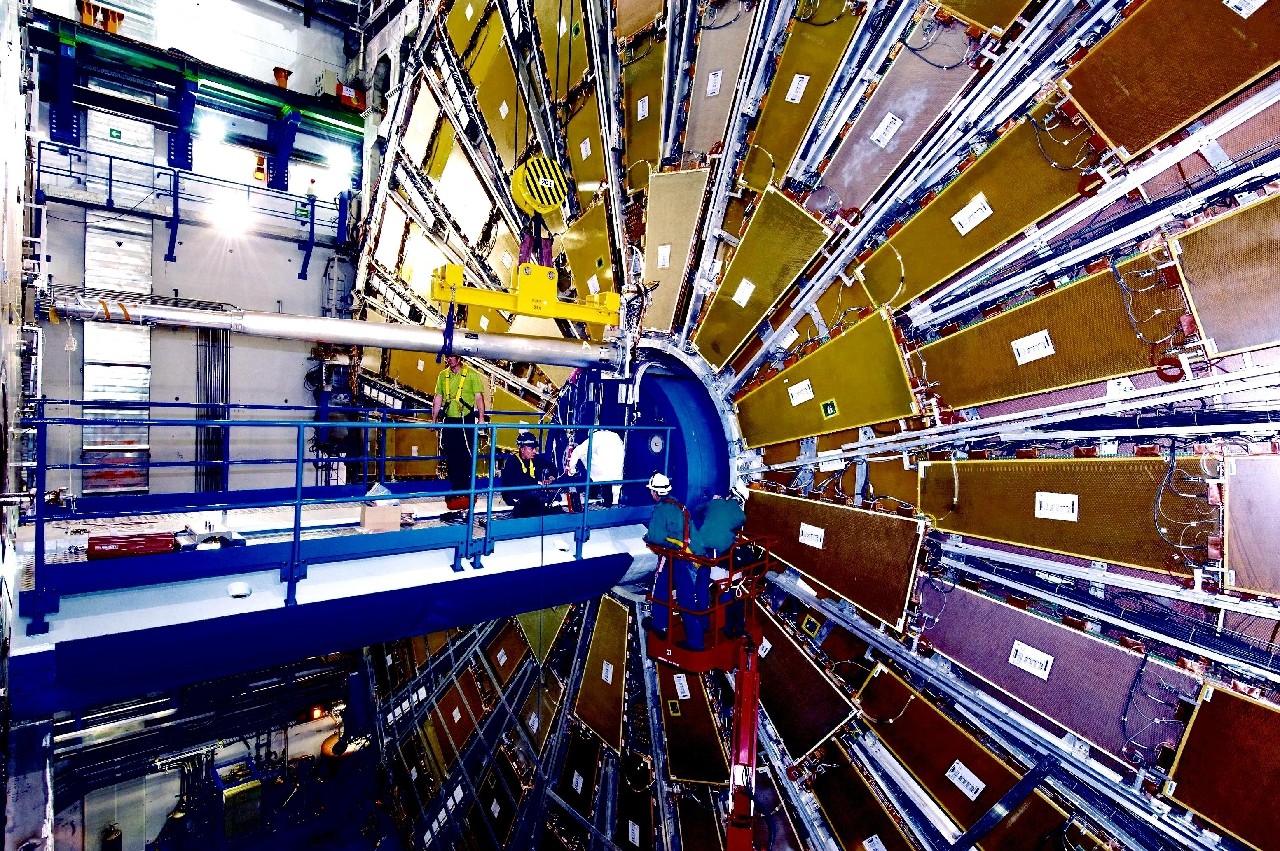

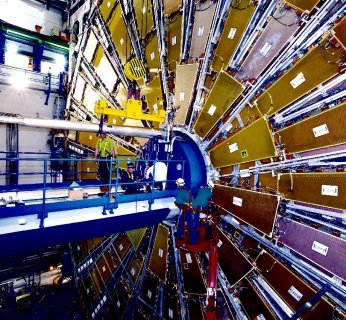

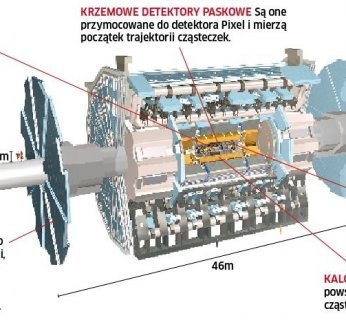

Kolizje są obserwowane przez gigantyczne detektory (największy z nich ma 25 metrów wysokości i 46 metrów długości). Ich odczyty przechowywane są w postaci surowych danych. Czujniki odnotowują zaburzenia cząsteczek po kolizji protonów. W zależności od gęstości strumienia cząsteczek, w ciągu sekundy dochodzi do milionów takich zderzeń. W detektorze cząsteczek noszącym nazwę CMS (Compact Muon Solenoid) – w którym prowadzone są poszukiwania cząsteczki Higgsa – jest 15 milionów czujników, które zapisują dane z częstotliwością 40 MHz. W efekcie powstaje 600 terabajtów danych na sekundę.

Żadne centrum komputerowe nie byłoby w stanie przetworzyć takiej ilości danych. Na szczęście nie jest to konieczne – większość to informacje nadające się wyłącznie do kosza. Dotyczą one zniekształconych albo już znanych cząsteczek. Dlatego spośród dziesięciu milionów kolizji wybierane są dwie albo trzy interesujące. W efekcie każdej z nich powstają setki nowych cząsteczek. Wśród miliardów naukowcy wypatrują tej jednej najważniejszej – cząsteczki Higgsa.

Cyfrowe sito: 60 tysięcy procesorów do usług

Ponad 99 proc. danych już na samym początku nadaje się do wyrzucenia. Decydują o tym procesory i chipy logiczne. Segregują one cząsteczki w zależności od prędkości poruszania się, właściwości elektromagnetycznych czy poziomu energetyczności. Te układy odrzucają 9999 z każdych 10 000 wyników w zaledwie trzy sekundy.

W drugim etapie procesory porównują wyniki testów z różnych czujników i po raz kolejny odsiewają 9 na 10 wyników w ciągu zaledwie jednej milisekundy. Dane, które przejdą przez to sito, są gruntowanie sprawdzane w trzecim i ostatnim etapie. Przetworzenie skomplikowanych algorytmów i uporządkowanie indywidualnych pakietów danych w finalnym procesie przetwarzania zajmuje procesorom sekundy. Na potrzeby każdego eksperymentu udostępniono 2,5 tys. komputerów, które raz jeszcze odrzucają 99 procent okrojonych już danych. Z kilku milionów wyników 60 tysięcy procesorów zachowuje zaledwie kilka. Takie sito jest niezbędne: naukowcy dysponują “tylko” 15 petabajtami pojemności dyskowej.

Nie tylko ilość danych przyprawia o zawrót głowy. Cały system zdumiewa nawet tych, którzy nie interesują się nauką. Odkąd rozpoczęto jego planowanie, minęły 24 lata. Budowa kosztowała ok. 3 mld euro i zużyto 80 tys. ton materiałów. W długich na 26 659 metrów tunelach temperatura rzadko przekracza poziom zera absolutnego. Z kolei cząsteczki będące obiektem badań są tak małe, że nie można ich dostrzec nawet przez mikroskop elektronowy, mkną za to z prędkością światła.

Ruch wszystkich protonów w LHC przyspieszany jest przy pomocy pola elektrycznego. Następnie cząstki wciągane są przez dwa tunele strumieniowe, w których krążą po okręgu w przeciwnych kierunkach. Rury te mają grubość około 5,5 cm i wykonane są ze stali. Wewnątrz utrzymywana jest kontrolowana próżnia. Protony poruszają się cały czas po właściwym torze dzięki polu magnetycznemu 180 tys. razy silniejszemu niż ziemskie. By można było utrzymać nadprzewodność, magnesy muszą być chłodzone do temperatury -271,25 stopni Celsjusza. Samo schłodzenie 8 tys. magnesów do tej temperatury zajęło prawie półtora roku.

Tony bitów: 90 PB danych rocznie

Cząsteczki mają niewyobrażalnie małe masy. W skutek prędkości, z jakimi się poruszają, mają jednak taką samą energię kinetyczną jak 40-tonowy przedmiot mknący 150 km/h. Podczas symulowanej awarii protony, które wypadły z właściwego toru, wydrążyły otwór w stalowej rurze.

Czy eksperyment się powiódł, naukowcy dowiadują się dopiero po kilku miesiącach, kiedy system przetworzy otrzymane dane. Polega to na zasymulowaniu zderzenia na komputerze. Dlatego CERN wytwarza największą ilość danych na świecie. Surowe dane, kopie zapasowe, złożone symulacje – to wszystko składa się na petabajty danych.CERN nie jest w stanie ich przetworzyć. Zdano sobie z tego sprawę już w latach 90. Dlatego rozpoczęto pracę nad nową, zdecentralizowaną infrastrukturą komputerową – grid. WWW pozwala użytkownikowi na uzyskanie dostępu do informacji, a dzięki gridowi ma on dostęp do mocy obliczeniowej komputerów rozsianych po całym świecie.

Grid: Zabawka naukowców czy nowy Internet?

Grid stworzony na potrzeby projektu LHC składa się z systemu hierarchicznego o wielu poziomach. Pierwszy poziom to centrum przetwarzania danych w samym CERN-ie. Tam przetrzymywane są surowe dane z przeprowadzanych eksperymentów naukowych. Na kolejny poziom składa się jedenaście centrów przetwarzania – w nich przetrzymywane są kopie zapasowe danych z eksperymentów i prowadzone są udoskonalone rekonstrukcje zderzeń protonów. Każde z centrów połączone jest z Genewą przez sieć światłowodów o przepustowości 10 GB/s. Kolejny poziom to 120 centrów przetwarzania danych w 35 krajach – moc obliczeniowa tych centrów wykorzystywana jest do obliczeń związanych z symulacjami.

Grid został zaprojektowany tak, by każdy badacz uczestniczący w projekcie miał dostęp do wyników przeprowadzanych eksperymentów na swoim komputerze – niezależnie od tego, gdzie dane są przechowywane. Na razie grid służy naukowcom. Tak było na początku także z wynalazkiem Tima Bernersa-Lee – WWW.

Czuwający gigant

Dzięki najnowocześniejszym czujnikom cztery detektory w akceleratorze cząsteczek są w stanie zidentyfikować wszystkie cząsteczki elementarne. Cząsteczki rozpoznawane są na podstawie trajektorii, prędkości i właściwości elektromagnetycznych. Z naszej infografiki dowiecie się, jak zbudowane są detektory wykorzystywane w tak zwanym eksperymencie ATLAS.