IBM 350 był jednym z komponentów również debiutującego wtedy na rynku komputera – IBM 305 RAMAC. RAMAC (skrót od “Random Access Method of Accounting and Control”) był ponad jednotonowym kolosem o rozmiarze odpowiadającym mniej więcej trzem standardowym lodówkom, a interesujący nas tu komponent –pierwszy na świecie dysk twardy – był zbudowany z aż 50 (tak, pięćdziesięciu!) 24-calowych (średnica 61 cm) talerzy (patrz: zdjęcie) pokrytych magnetyczną warstwą nośną, obracających się podczas pracy urządzenia z prędkością 1200 obr./min. Dane były zapisywane na stu powierzchniach nośnych – po obu stronach talerzy. Wiele źródeł podaje, że jego pojemność wynosiła 5 MB, co nie jest do końca ścisłe. IBM 350 umożliwiał zapis maksymalnie pięciu milionów 6-bitowych znaków, co – po dokonaniu binarnego przeliczenia – dawało pojemność ok. 3,75 MB. Obudowa tego kolosa (mówimy o samym dysku) miała wymiary 172×152×74 cm. Czas dostępu do danych wynosił (w zależności od źródła) od 600 ms do sekundy. Cały system IBM RAMAC 305 z dyskiem IBM 350 był oferowany w cenie 3200 dolarów miesięcznie.

Dylemat odkrywcy

Ciekawostką jest, że IBM 350, niezwykle innowacyjny sprzęt w swoich czasach, nie miał łatwej drogi do sukcesu – cały projekt pierwszego na świecie dysku twardego został w 1953 r. odrzucony przez radę nadzorczą IBM. Obawiano się, że ta technologia negatywnie wpłynie na stabilny rynek kart perforowanych, na którym IBM był liderem. W tamtych czasach IBM produkował około 16 miliardów (sic!) kart perforowanych rocznie i był to bardzo zyskowny biznes. Reynold Johnson, szef placówki badawczej IBM w San Jose oraz kierowany przez niego zespół inżynierów i naukowców wykazali się uporem i naukową intuicją. Wbrew poleceniom “z góry” i cofniętym oficjalnie funduszom na projekt kontynuowali prace… zmieniając nazwę projektu. Nie było to co prawda rozwiązanie na dłuższą metę, ale traf chciał, że na feralnym zebraniu rady nadzorczej zabrakło Thomasa Watsona juniora, prezesa koncernu. Pojawił się on za to później w tym samym roku w placówce badawczej w San Jose i osobiście zaakceptował kontynuowanie prac nad tym, czym RAMAC miał się stać.

Era mainframe’ów

Kolejny model, który znacząco wyprzedzał pionierski produkt IBM-u, to dysk IBM 1301. Sprzęt ten zadebiutował na rynku w roku. Przeznaczony był dla dużych jednostek typu mainframe, również zresztą produkowanych przez IBM (np. seria IBM 7000). Tym, co odróżniało dysk IBM 1301 od wcześniejszego, pionierskiego produktu, było wprowadzenie odczytu i zapisu bezkontaktowego. Głowice tego dysku, podobnie jak we wszystkich późniejszych modelach dysków twardych, nie stykały się w ogóle z powierzchnią nośnika, lecz unosiły się na poduszce powietrznej. Oprócz zmodernizowania mechaniki zapisu i odczytu wyraźnie poprawiono również pozostałe parametry dysku. IBM 1301 charakteryzował się 13-krotnie większą gęstością zapisu (520 bitów na cal ścieżki zapisu). Dysk wytwarzany był w dwóch wersjach: z jednym i z dwoma modułami. Każdy z modułów pozwalał przechowanie do 28 milionów znaków. Talerze obracały z prędkością 1800 obr./min., a czas dostępu do danych skrócono do 180 ms. Za możliwość korzystania z urządzenia trzeba było zapłacić od 2100 dolarów miesięcznie, ewentualnie kupić sprzęt 115 500 ówczesnych dolarów (za model jednomodułowy).

PC wchodzi do gry

Pierwszy komputer PC, debiutujący na rynku 12 sierpnia 1981 roku, był jeszcze pozbawiony dysku twardego. Inżynierowie jednak nie próżnowali: jeszcze przed rynkową premierą pierwszego peceta firma Shugart Technology (przemianowana potem na doskonale dziś znaną markę: Seagate Technology) prezentuje urządzenie o nazwie ST-506, to pierwszy 5,25-calowy dysk twardy. Miał pojemność 5 MB, kosztował ok. 1500 dolarów. Wiele dysków z lat 80. XX wieku bazowało właśnie na modelu ST-506. Komputer IBM PC XT z 1983 roku standardowo wyposażano już w dysk twardy (model Seagate ST-412 o pojemności 10 MB – następca ST-506). Interfejs wykorzystywany w ST-506 (i jego następcach) okazał się dość problematyczny: komputer musiał mieć specjalny kontroler. Taka sytuacja miała miejsce do 1986 roku, kiedy nieistniejąca już dziś firma Compaq Computer wprowadziła na rynek PC wyposażone w dyski z nowym interfejsem ATA. Interfejs ten, opracowany przez firmę Western Digital (w kooperacji z CDC), znacząco redukował koszty produkcji i upraszczał wykorzystanie dysków w komputerach (kontroler był zintegrowany z elektroniką dysku).

Równolegle i prostopadle

Do roku 2005 największa osiągnięta gęstość zapisu na dyskach twardych dostępnych komercyjnie ma wartość 100 Gb/cal. To szczyt możliwości funkcjonującej już wówczas od dziesięcioleci techniki zapisu równoległego. Najpojemniejsze dostępne powszechnie dyski wykonane w tej technologii osiągają pojemność rzędu 500 GB (w przypadku modeli 3,5-calowych. Dalsze zwiększanie gęstości zapisu napotkało barierę fizyczną w postaci tzw. efektu superparamagnetycznego. Jest to zjawisko fizyczne polegające na tym, że magnetyczny nośnik nie zdoła trwale przechowywać zapisanej na nim informacji, jeżeli energia termiczna (ciepło otoczenia) jest większa od energii wystarczającej głowicy zapisującej dysku do zmiany stanu informacji w pojedynczej domenie magnetycznej. Rozwiązaniem okazało się wprowadzenie technologii zapisu prostopadłego, pozwalającego na dalsze zwiększanie gęstości zapisu przy jednoczesnym odsunięciu bariery efektu superparamagnetycznego. Pierwszym dyskiem twardym, w którym wykorzystano zapis prostopadły, był 1,8-calowy dysk wyprodukowany w 2005 roku przez koncern Toshiba. Model ten dostarczany był w dwóch wersjach: o pojemności 40 i 80 GB. W kolejnym roku Seagate wprowadza dysk 3,5″ o pojemności 750 GB. Wszystkie dyski dziś dostępne wykorzystują zapis prostopadły.

SSD – “stara” nowa technologia

Patrząc na czas pojawienia się napędów SSD na rynku, można odnieść mylne wrażenie, że SSD to technologia znacznie nowocześniejsza od tradycyjnych dysków twardych. Faktem jest, że pierwsze SSD dostępne dla indywidualnych odbiorców jako zamienniki (bardzo drogie) tradycyjnych dysków twardych ukazały się na rynku mniej więcej na przełomie XX i XXI wieku, choć trudno tak naprawdę wskazać jednoznacznie konkretny termin, właśnie ze względu na to, że pamięci półprzewodnikowe – a tym w istocie są napędy SSD – to technologia wywodząca się w prostej linii od pamięci ferrytowych towarzyszących komputerom od czasów poprzedzających nawet pojawienie się dysków twardych. O ile ukazanie się pierwszego dysku twardego było swego rodzaju rewolucją – po prostu wcześniej nie było podobnych urządzeń – o tyle w przypadku SSD mamy do czynienia raczej z ewolucją znanych wcześniej rozwiązań. Według niektórych źródeł za pierwsze urządzenie, które można nazwać nośnikiem SSD, uznaje się BULK CORE. Sprzęt ten wyprodukowany został w 1976 roku przez firmę Dataram i przeznaczony był głównie do komputerów firmy DEC. Urządzenie miało pojemność 2 MB.

Rozwój SSD – potencjał czy ślepa uliczka?

Od strony praktycznej, aby SSD miało sens dla indywidualnego konsumenta jako alternatywa dla dysku twardego, musiało spełniać dwa warunki: mieć przystępną cenę oraz oferować pojemność wystarczającą do komfortowego korzystania z komputera (by zmieścił się system operacyjny i zestaw najczęściej używanych aplikacji). W popularyzacji półprzewodnikowych nośników danych opartych na układach pamięci flash bardzo pomogła też rewolucja mobilna – trudno wyobrazić sobie smartfon z dyskiem twardym. Wszystkie urządzenia mobilne do przechowywania danych wykorzystują właśnie pamięci flash, niezależnie od tego, czy mówimy o wbudowanej w dany tablet czy smartfon pamięci, czy też o pamięciach w postaci kart microSD (i kart innych typów). Dodatkowym bodźcem wpływającym na upowszechnienie się nośników SSD było wprowadzenie przez firmę Intel nowej klasy urządzeń zwanych ultrabookami (jest to zastrzeżony przez Intela znak towarowy). Teoretycznie Intel, publikując założenia, które mają spełniać komputery przenośne zaliczane do ultrabooków, nie wymagał nośnika SSD. Niemniej według najnowszej specyfikacji w ramach platformy Shark Bay (opublikowanej w lipcu 2013 roku) komputer powinien uruchomić się ze stanu hibernacji w ciągu 3 sekund, co jest w praktyce nieosiągalne dla konfiguracji z dyskiem twardym. Dzisiejsze SSD to urządzenia charakteryzujące się przyzwoitą (choć mniejszą niż w przypadku HDD) pojemnością, akceptowalną ceną i znakomitą wydajnością. Przyjrzyjmy się przykładowym parametrom jednego z nowszych modeli: Kingston HyperX Fury 120 GB (kosztuje od ok. 220 zł). Właściwym nośnikiem danych w tym urządzeniu są pamięci fl ash typu MLC (Multi Level Cell, tzw. pamięć wielostanowa – w jednej komórce można zapisać więcej niż 1 bit informacji), a dokładniej wykonane w 20-nanometrowym procesie technologicznym układy Kingston FT16B08UCM1-34. Deklarowana przez producenta wydajność to do 500 MB/s (odczyt i zapis sekwencyjny). Co prawda, w praktyce zmierzone wartości będą niższe, jednak i tak SSD okaże się kilkukrotnie szybszy od najszybszych dysków twardych. Jeszcze większa przewaga ujawnia się, gdy porównamy czas dostępu do danych, który w przypadku SSD jest o kilka rzędów wielkości krótszy niż w przypadku HDD.

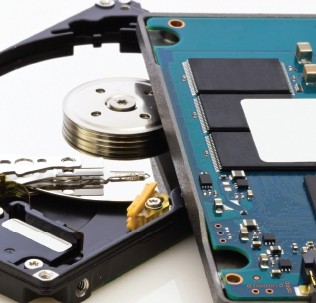

Nie zamiast, lecz obok

SSD i HDD to technologie wzajemnie się uzupełniające. Do zalet SSD zalicza się szybkość i czas dostępu, dzięki czemu nośnik sprawdza się jako nośnik dla systemu operacyjnego i najczęściej wykorzystywanych aplikacji, natomiast niepodważalną zaletą HDD jest pojemność. Co prawda, można w Polsce kupić SSD o pojemności nawet 1920 GB (tak, prawie 2 TB), np. model OCZ Intrepid 3700, ale na taki sprzęt będzie stać nielicznych – SSD o takiej pojemności kosztuje 5 tys. zł. Dla porównania dodajmy, że tradycyjny dysk twardy o pojemności 2 TB można dziś nabyć za ok. 300 zł. Zatem dla zbiorów, których odczyt nie wymaga dużej prędkości (np. odtwarzanie muzyki, fi lmów, zdjęć), ale które mogą zajmować sporo miejsca (wszystkie multimedia, zwłaszcza fi lmy) – to właśnie HDD, a nie SSD wciąż pozostaje optymalnym rozwiązaniem i zapewne jeszcze długo się to nie zmieni.

A może chmura

Z uwagi na przechowywanie danych nie sposób zignorować jeszcze jednego rozwiązania, także coraz bardziej powszechnego – chodzi o chmury danych. Z jednej strony rozwiązanie przegrywające z SSD HDD niemal pod każdym względem (wydajność, pojemność, elastyczność, zakres kontroli użytkownika), ale z drugiej mające jedną niepodważalną zaletę. Dzięki chmurom użytkownik może uzyskać dostęp do swoich danych z każdego miejsca na świecie. Usługi przechowywania danych online są również często wykorzystywane do archiwizowania kopii zapasowych ważnych dla użytkowników danych, ale z oczywistych względów nie stanowią alternatywy dla lokalnych metod przechowywania danych.

Kryształowa kula

Wielu ekspertów uważa, że proces miniaturyzacji pamięci NAND-flash dociera już do granic fizycznych. Z drugiej jednak strony w tym roku pojawiły się pierwsze układy pamięci flash wykonane w zupełnie nowym, przestrzennym procesie 3D NAND. W sierpniu 2015 roku pierwszy taki układ – 256-gigabitową pamięć flash 3D V NAND – zaprezentował Samsung, w grudniu br. układy wykonane w tej technologii ma przedstawić Micron. Co to oznacza dla konsumenta? Na przykład możliwość upakowania w standardowej obudowie 2,5-calowej tylu układów pamięci, że dawałoby to teoretyczną pojemność SSD nawet powyżej 10 TB. Jest tylko problem ceny. Na dodatek niektórzy naukowcy sugerują, iż górną granicą pojemności stabilnego SSD jest ok. 16 TB. Ponadto większa pojemność przy mniejszej wielkości pojedynczych komórek będzie równocześnie oznaczać spadek wydajności (nawet kilkukrotnie dłuższy czas dostępu do danych – a właśnie krótki czas dostępu to największa zaleta dzisiejszych SSD). Tymczasem HDD 10 TB już jest. Udało się to uzyskać firmie Western Digital w modelu HGST Ultrastar Archive Ha10. Sam dysk imponuje nie tylko pojemnością. Stanowi też innowację technologiczną – to jeden z pierwszych na świecie dysków wykorzystujący jeszcze nowszą (od zapisu prostopadłego) technikę zapisu – SMR, czyli Shingled Magnetic Recording (poszczególne ścieżki zachodzą na siebie niczym gonty na dachu, stąd zresztą nazwa, bowiem “shingle” to po angielsku gont). Producenci eksperymentują również z takim rozwiązaniami jak np. HAMR (Heat-Assisted Magnetic Recording; wspomagany termicznie zapis magnetyczny) – prototypowe dyski HAMR już w 2013 roku zaprezentował koncern Western Digital, do ich produkcji przygotowuje się też firma Seagate. Potencjał tej technologii ma umożliwić zbudowanie dysku o pojemności nawet 20 TB. Bardzo możliwe, że modele o pojemności kilkunastu terabajtów zobaczymy na rynku już w przyszłym roku. Kolejną technologią dającą nadzieje na dalszy rozwój dysków twardych jest rozwiązanie o nazwie Bit-Patterned Media. To technologia zakładająca wstępne przygotowanie nośnika magnetycznego poprzez poddanie go procesom podobnym do nanolitografii stosowanej w produkcji najnowszych układów scalonych. Połączenie zalet techniki HAMR z BPM ma zaowocować dyskami o pojemności sięgającej nawet 60 TB. Przyszłość zapowiada się naprawdę ciekawie.