Bryant uważał, że spełnia swój patriotyczny obowiązek, w końcu USA były w stanie wojny z Al-Kaidą, której członkowie ukrywali się w Afganistanie. Robił, co mógł, żeby pomóc swojemu krajowi.

Ale praca operatora drona to nie tylko bombardowanie oddalonych o dziesiątki tysięcy kilometrów “celów”. Najpierw całymi dniami podgląda się życie kobiet, mężczyzn i ich dzieci. A w końcu ich eliminuje.

Aż przyszedł ten dzień. Bryant jak zwykle wcisnął przycisk w USA i czekał 16 sekund, aż wystrzelona w Afganistanie rakieta doleci do celu i kolejny terrorysta zostanie zabity. W ostatnich sekundach przed uderzeniem pocisku, w pole rażenia weszły dzieci.

Tego dnia Bryant wyszedł ze swojego małego biura i w mundurze wrócił do własnej rodziny. Wkrótce lekarze zdiagnozowali u niego zespół stresu pourazowego.

Od 2012 roku technologia rozwinęła się jednak na tyle, że podobne przypadkowe śmierci cywilów należą (lub zaraz będą należeć) do przeszłości.

Chmury mają oczy

Wydatki na rozwój sztucznej inteligencji w 2016 roku wyniosły ponad miliard dolarów. Ale czymże jest 1 000 000 000 dolarów przy 12, 15 miliardach dol., o które w 2017 roku wnioskował amerykański Pentagon. Kwota ta miała być wydana właśnie na rozwój projektów związanych ze sztuczną inteligencją.

Właśnie dzięki takim pieniądzom amerykańska armia mogła niedawno ogłosić, że opracowuje system automatycznego rozpoznawania i namierzania osób oraz pojazdów. W ten sposób już żaden Brandon Bryant nie będzie musiał cierpieć z powodu szkód kolateralnych (prawda, jak ładnie można nazwać śmierć dzieci, które weszły na pole rażenia?).

Może przypominają się wam teraz odcinki “Black Mirror”. Na przykład “Hated in the Nation” – ostatni odcinek trzeciego sezonu serialu, w którym kontrowersyjne osoby w państwie są eliminowane za pośrednictwem bardzo podobnego systemu. Drony, które mogą nawet z dużej odległości rozpoznawać cele są rozwijane już od 2011 roku. Algorytmy rozpoznawania obrazu w różnych warunkach oświetleniowych, w ruchu i w niespodziewanych sytuacjach nie są jednak domeną wojska. Są domeną firm technologicznych; prawdopodobnie korzystacie z nich dość często – czy jest to Face ID Apple’a, czy Zdjęcia albo wyszukiwanie obrazów Google.

(Don’t) be evil

W marcu 2018 roku okazało się, że wojsko USA współpracuje z Google przy rozwijaniu projektu sztucznej inteligencji analizującej dane z dronów. Chodzi oczywiście o Projekt Maven. Koncern twierdzi, że wyniki jego pracy maja być stosowane wyłącznie “do celów nie ofensywnych”.

Nie dziwi, że wojsko zwróciło się z prośbą o możliwość wykorzystania AI Google’a. W końcu jest to firma, która od lat uczy autonomiczne samochody rozpoznawania nawet najdziwniejszych obiektów na drodze – krów, rowerzystów, dzieci bawiących się piłką i wyskakujących znienacka na ulicę. W Google pracuje cały zespół osób, których celem jest “zaskakiwanie” samochodów, choć nie wszystkie sytuacje można przewidzieć. Kilka lat temu Astro Teller, szef eksperymentalnej jednostki Google X opowiadał:

– Pewnego razu testowaliśmy nasz samochód na ulicach San Francisco. To było jakieś wzgórze, gdy zza niego wyjechaliśmy, zobaczyliśmy kobietę na wózku inwalidzkim, która na środku drogi miotłą przeganiała kaczkę. Samochód był w takim szoku, że aż przystanął.

Współpraca Google z Departamentem Obrony nie przypadła do gustu samym pracownikom Google. 3 tysiące z nich podpisały petycję, domagającą się do Sundara Pitchaia, szefa Google, wycofania się z projektu. “Uważamy, że Google nie powinien zajmować się walką” – czytamy w petycji. Koncern uspokaja tłumacząc, że Pentagon i tak ma przecież dostęp do “otwartego oprogramowania rozpoznawania obrazów, z którego może korzystać każdy użytkownik Google Cloud”.

Najbardziej przerażający renifer świata

To zresztą byłby niepierwszy romans Google’a z wojskiem. W 2013 roku firma kupiła Boston Dynamics, producenta robotów. Kojarzycie z pewnością ich twory. Big Dog, Atlas czy Cheetah kiedyś należały do “floty” Google.

Firma miała nadzieję wykorzystać niesamowite możliwości robotów i stworzyć wielofunkcyjne roboty domowe. Ale mimo tego, że pies Boston Dynamics potrafi umyć szklankę, delikatnie ją przenieść i nie stłuc, to jednak Google odsprzedał firmę w 2017 przyznając, że nie udało im się zbudować rozwiązania, które mogłoby być wprowadzone na rynek. Niespecjalnie powinno nas to dziwić, roboty Boston Dynamics jedną nogą stoją w naszym świecie, a drugą w dolinie niesamowitości.

Wyżej, szybciej, dalej

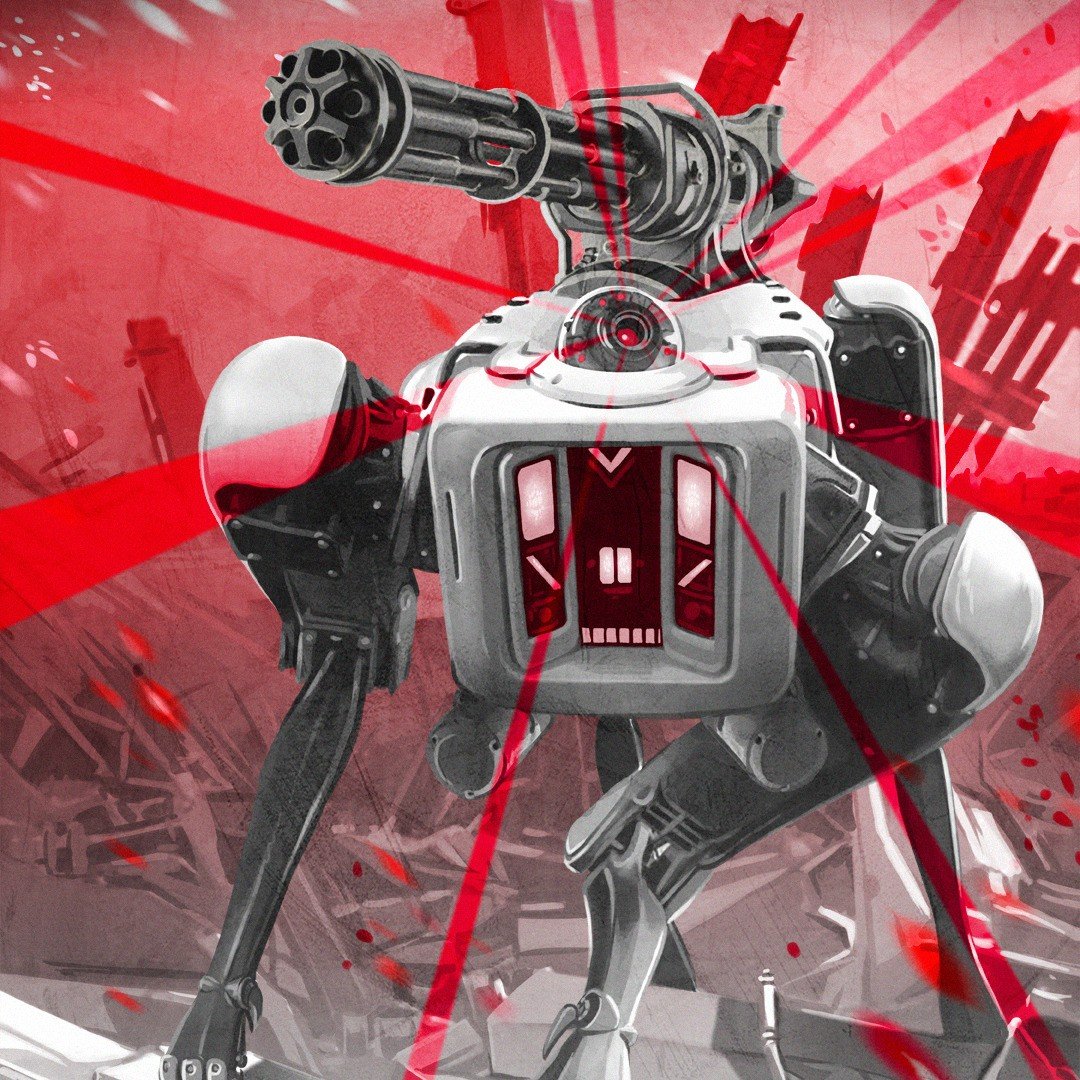

Przygoda Boston Dynamics trwa nadal. Obecnie firma znajduje się w rękach japońskiej firmy technologicznej SoftBank i wciąż rozwija swoje roboty. Cheetah biega szybciej, niż Usain Bolt. Humanoidalny Atlas potrafi przeskakiwać różnej wielkości przeszkody (także do tyłu). SpotMini (ewolucyjna forma Big Doga) potrafi otwierać drzwi nawet, gdy przeszkadza jej w tym człowiek. Obejrzenie zaledwie kilku filmów z robotami Boston Dynamics z jednej strony wywołuje efekt “wow”, a z drugiej każe się zastanowić, czy faktycznie ich przeznaczeniem będą prace domowe. Bo na pierwszy rzut oka wydaje się, że widzimy prototypy żołnierzy przyszłości – takich, którzy nigdy się nie męczą, którym niestraszne przeszkody, którzy będą dążyć do osiągnięcia zaprogramowanego celu bez względu na przeszkody (tak, jak SpotMini dąży do otwarcia drzwi mimo przeszkadzającego człowieka).

Czarny scenariusz

Inteligentne i autonomiczne drony czy roboty z ponadludzkimi (a w zasadzie nieludzkimi) zdolnościami wydają się znakomitą bronią. Przynajmniej, dopóki znajdują się w rękach “naszych”, a nie “ich” (kimkolwiek “oni” by nie byli). A przecież można wyobrazić sobie scenariusz, w którym do danego państwa (Polski, USA, innego) w kontenerze wysyłany jest rój takich uzbrojonych, autonomicznych dronów. Przepływ ludzi jest kontrolowany dużo bardziej rygorystycznie, niż przepływ towarów. Co, jeśli w jakimś chorym umyśle pojawi się pomysł wypuszczenia takiej zaprogramowanej w jednym celu chmury dronów w zatłoczonym miejscu publicznym w jednym z europejskich miast? Straty mogłyby być większe, niż w przypadku ataków terrorystycznych z wykorzystaniem porwanej ciężarówki.

Stare vs nowe

Amerykanie mają zamiar przenieść całe rozpoznanie strategiczne, operacyjne i taktyczne z kosmosu do przestrzeni atmosferycznej i zbudować roje dronów unoszących się na stałe na całym globie – mówił w 2015 roku Jacek Bartosiak, ekspert Narodowego Centrum Studiów Strategicznych. – To będą drony rozpoznawcze i bojowe, które w czasie rzeczywistym będą widziały wszystko i przekazywały informacje do USA. Roje będą zastępowalne. Przeciwnik zestrzeli 68, a system się zrekonstruuje. W tej chwili łatwiej jest zestrzelić satelitę, niż go wynieść i nie bardzo jest jak go bronić. Drony będą też miały zastosowanie cywilne np. mogą zastępować ratowników na plażach.

Bartosiak jest ekspertem ds. geopolityki, nowoczesnej sztuki wojennej i dyrektorem Programu Gier Wojennych i Symulacji w Fundacji Pułaskiego. Na strategii wojennej zna się jak mało kto w naszym kraju. I w jednym ze swoich wykładów wskazuje jedną poważną wadę dronów (także autonomicznych) – zagłuszanie. Jak każde urządzenie elektroniczne, drony mogą zostać zdalnie spacyfikowane, i to bez oddania ani jednego strzału. Wystarczy zagłuszać je na wybranej częstotliwości – to już się dzieje w wybranych miejscach, np. na niektórych lotniskach, w okolicach budynków rządowych czy służb specjalnych.

Gdyby zastosować zagłuszanie na większą skalę, to okaże się, że wracamy do Wojny 1.0, w której najważniejsze jest ciężkie uzbrojenie, wyrzutnie rakiet i czołgi.

Kto siedzi na krzesłach

Sztuczna inteligencja może przetwarzać informacje szybciej niż człowiek. Ale o ile obliczenia matematyczne nie sprawiają jej problemów, to czynności typowo ludzkie już tak. Emmanuel Mogenet, szef Google Research w Zurychu, opowiadał kiedyś, jak trudno jest nauczyć komputer rozpoznawania tego, co w świecie jest możliwe. Tego, co dla ludzi jest oczywiste (chodzenie, siedzenie na krzesłach, rozpoznawanie twarzy), komputery uczone są w pocie czoła i znoju. Jest to możliwe i w małym stopniu już się udaje, ale na razie nie wiadomo, jak w istocie postrzegają świat sieci neuronowe, na których odbywają się takie obliczenia.

Nie potrafimy nauczyć maszyn wyciągania części wspólnych, esencji. To zupełnie coś innego niż reprezentacje, które ty albo ja mamy w umyśle. Komputery znajdują sposoby na tłumaczenie sobie świata, które mogą nie przystawać do rzeczywistości. Sposób, w jaki komputer uczy się i wyciąga wnioski (…) jest zupełnie inny od naszego. Trudno nam zrozumieć, co dzieje się w głębi sieci neuronowych. Jej działanie w niczym nie przypomina działania ludzkiego mózgu – opowiadał Mogenet.

Prawdopodobnie łatwiej byłoby stworzyć system wzajemnej komunikacji dronów, w którym urządzenia wymieniałyby informacje tylko między sobą. Obecnie, drony muszą człowiekowi “tłumaczyć” co widzą i jakie działania “sugerują”. Ale gdyby powstał taki system, to byłby dla ludzi kompletnie niezrozumiały.

W przypadku urządzeń, którym ludzie nadają jeden cel działania, mogłoby to oznaczać że: wojna przestanie być walką, stanie się eksterminacją – tak przynajmniej uważa dr Peter Lee z Uniwersytetu Portsmouth. Może się wówczas zdarzyć, że gdy z wojennego równania wyjmiemy człowieka, zniknie ludzki wymiar prowadzenia wojny. | CHIP