Google w ubiegłym roku na GitHubie udostępnił BERT, czyli technologię opartą na sieci neuronowej. Działa ona w oparciu o przetwarzanie języka naturalnego. Algorytm nie traktuje słów w zdaniach jako odrębnych bytów. Rozumie kontekst słowa biorąc pod uwagę te, które znajdują się przed nim, a także po nim w konkretnym zdaniu. Dzieje się tak dzięki temu, że Google trenowało sieci neuronowe poprzez maskowanie poszczególnych słów w zdaniach. Zadaniem BERT było odgadnięcie, o jakie frazy chodzi. Kolejnym krokiem była nauka relacji pomiędzy zdaniami poprzez określanie, czy jedno może występować po drugim.

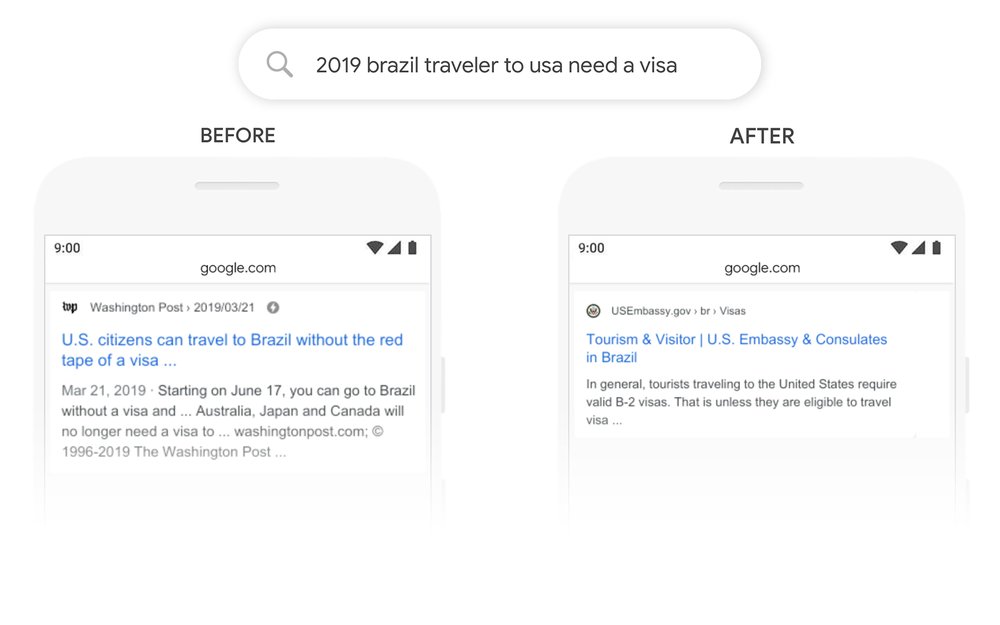

Koncern przekonuje, że w Stanach Zjednoczonych BERT poprawi wyniki wyszukiwania w 10 proc. zapytań. Na swoim blogu, Google podaje przykład, w którym ktoś mógłby wpisać w pasek wyszukiwania “2019 brazil traveler to usa need a visa” (ang. “2019 brazylijski podróżnik do USA potrzebuje wizy”). Dotąd Brazylijczyk szykujący się do drogi, dostawał w odpowiedzi wiadomości dla Amerykanów kierujących się na południe. Teraz w pierwszym wyniku wyszukiwania znajdzie stronę ambasady ze wszelkimi niezbędnymi informacjami.

Google wykorzysta BERT do poprawiania wyników wyszukiwania na całym świecie. Wszystko dzięki temu, że sieci neuronowe mogą uczyć się w jednym języku, a następnie przekładać to na kolejne. Już teraz BERT jest wykorzystywany w ponad 20 krajach, żeby polepszać odpowiedzi pojawiające się na górze listy wyników wyszukiwania. BERT bez wątpienia będzie też użyteczny w przypadku asystentów głosowych. Jednak koncern zauważa też, że nawet najnowsze rozwiązania nie są w stanie sprostać ani kreatywności użytkowników, ani niektórym zwrotom. | CHIP

Pierwszy odcinek wiadomości Google’a dla właścicieli i twórców stron internetowych