80-gigabajtowe A100 na horyzoncie

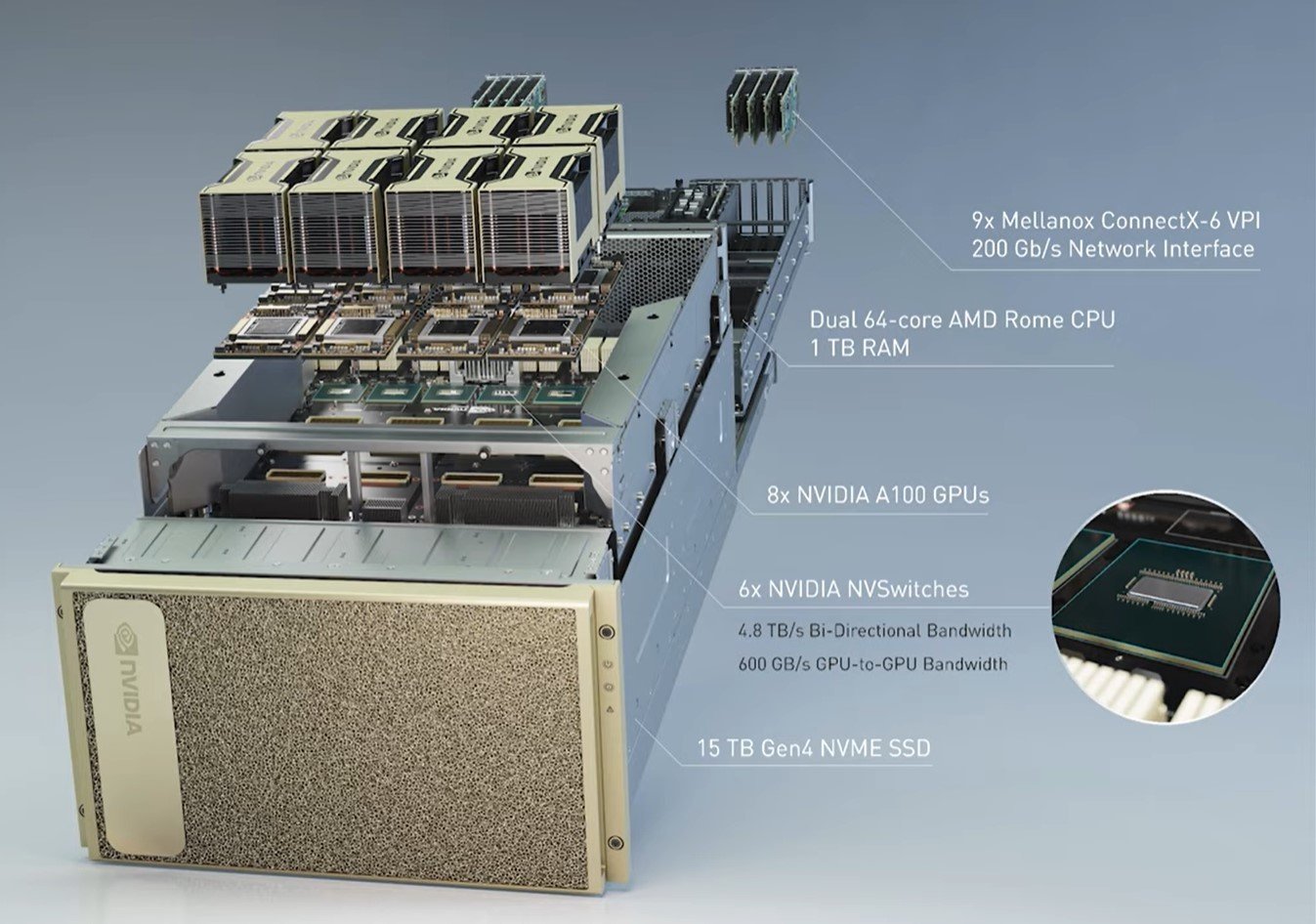

Na ten moment w ofercie firmy znajdują się dwa modele z rodziny A100. Różnica między nimi? Wyłącznie interfejs, bo obie posiadają ten sam rdzeń graficzny GA100 i 40 GB pamięci HBM2e, ale są przeznaczone albo na SXM4, albo znany nam znacznie lepiej PCIe 4.0. Chociaż oba modele oferują podobną szczytową moc obliczeniową, istnieją różnice w połączeniu między procesorami graficznymi, ponieważ wariant PCIe jest ograniczony tylko do dwóch procesorów graficznych przez NVLink.

Czytaj też: Widziałem laserowy telewizor HiSense. Robi wrażenie

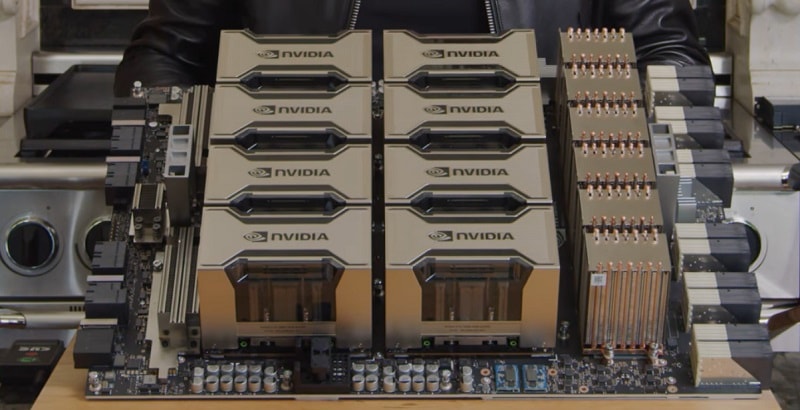

Te akceleratory graficzne są tymi najwydajniejszymi i nic w tym dziwnego, jako że bazują na wspomnianym GPU, będącym wręcz arcydziełem. Jednak w tego typu sprzętach rdzeń jest tylko częścią wydajności. Ważna jest też pamięć. Wspominam o tym, bo najwidoczniej na rynku profesjonalnym wykształciła się potrzeba na akcelerator graficzny NVIDIA A100 z 80 GB HBM2e, czyli z dwukrotnie okazalszym pokładem pamięci.

Wzmiankę o tym znajdziemy w oficjalnej dokumentacji Data Center firmy, ale ta oficjalnie nie ujawniła jeszcze istnienia tych modeli. Premiera ma mieć miejsce za tydzień i ogólnie można potraktować można to bardziej jako ciekawostkę… chyba że należycie do tych, którzy z A100 zrobią pożytek i mają do nich dostęp.

Co takiego wyjątkowego jest w akceleratorach A100?

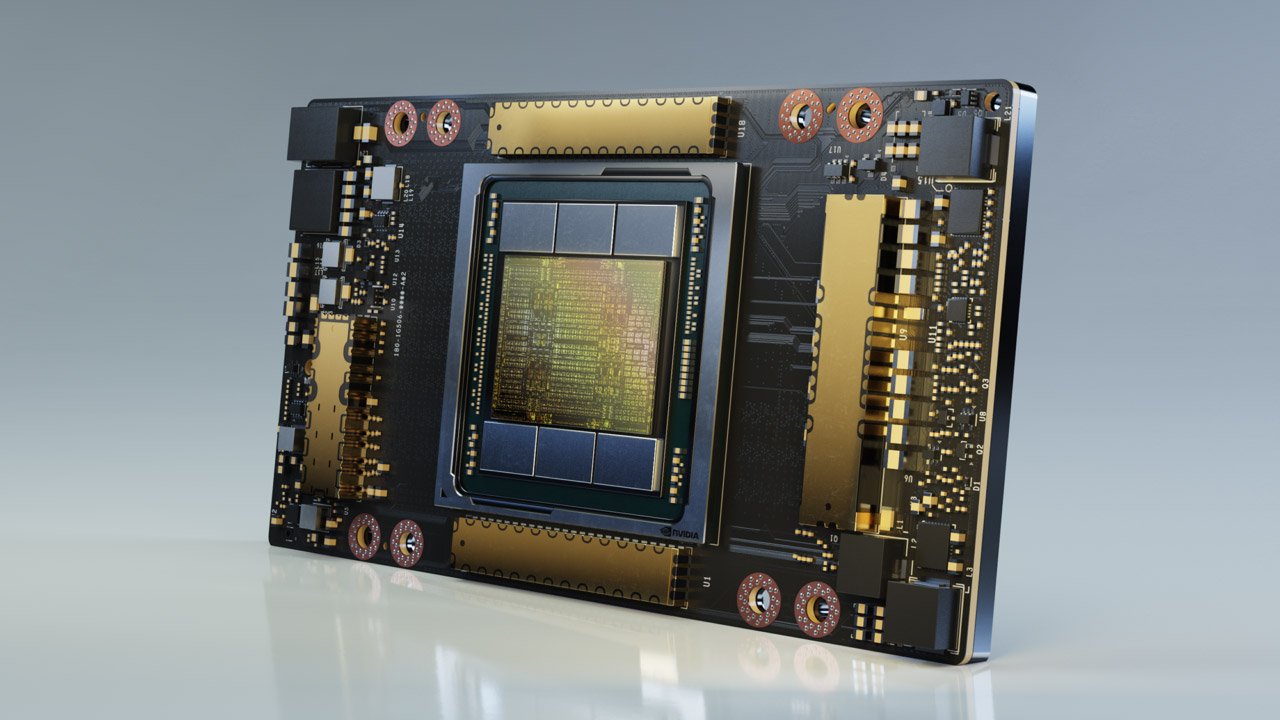

Jak już wspomniałem, A100 może pochwalić się GPU GA100, a tak się składa, że to największy procesor graficzny oparty na architekturze NVIDIA Ampere. Zawiera on aż 54 miliardy tranzystorów na powierzchni krzemu o wielkości 826 mm kwadratowych, co przekłada się na wydajność FP64 na poziomie 9,7 TF dla rdzeni CUDA i 19,5 TF dla Tensor.

Czytaj też: Microsoft zmusi nas do Windowsa 11. DirectStorage API ruszy tylko tam

Układy pamięci A100 są też wyjątkowe, bo naprawdę daleko im do możliwości stosowanych w konsumenckich modelach układów GDDR6 w tym pozytywnym dla nich znaczeniu. Jeśli zastanawia Was, jak lepsze są pamięci HBM w porównaniu do GDDR, najlepiej zrozumieć to na podstawie przepustowości.

Podczas gdy stosowane obecnie HBM2e mają do zaoferowania przepustowość 460 GB/s, obecne w najlepszej karcie graficznej na rynku (RTX 3090) pojedyncze kości pamięci GDDR6X oferują jakieś 19/21 Gb/s. Oczywiście na przepustowość karty ma też wpływ magistrala oraz liczba samych kości.

Czytaj też: Intel rozwinie rynek łączności. Sieć 5G jest dla firmy bardzo ważna

Dlatego też w A100 80 GB przepustowość wyniesie aż 2039 GB/s, czyli o prawie 500 GB/s więcej względem wersji z 40 GB HBM2e, która to pod kątem przepustowości ma do zaoferowania 1555 GB/s.