Chociaż na pełnokrwiste komputery kwantowe trzeba będzie jeszcze trochę poczekać, naukowcy coraz mocniej naciskają, by największe firmy tworzyły własne projekty. Microsoft, IBM, Google – to tylko te najbardziej “medialne” marki. Nawet ci, którzy kwestionują znaczenie kwantową supremację Google’a, podkreślają wagę kwantowej korekcji błędów. W Science pokazała się bardzo ciekawa praca na ten temat.

Naprawdę jest różnica między komputerem kwantowym za 100 mln dolarów z 10 000 kubitów, który jest generatorem losowego szumu, a najpotężniejszym komputerem na świecie.Chad Rigetti, fizyk i współzałożyciel Rigetti Computing

Komputer kwantowy jak statek

Eksperci przekonują, że kluczowym celem komputerów kwantowych powinna być możliwość rozprzestrzenienia informacji zakodowanej w pojedynczym kubicie, nawet wtedy, gdy szum zakłóca bazowe kubity. Dobrym porównaniem jest tu to użyte przez Scotta Aaronsona, informatyka z Uniwersytetu Teksańskiego w Austin:

Próbujemy zbudować statek, który pozostanie tym samym statkiem, nawet jeśli każda jego deska zgnije i będzie musiała zostać wymieniona.

To ważny kamień milowy dla największych firm budujących komputery kwantowe – Google, Rigetti Computing czy IBM. Zarówno Hartmut Neven z laboratorium Quantum Artificial Intelligence w Google i Jay Gambetta z IBM przekonują, że w ciągu najbliższych lat “zobaczymy efekty tych prac”.

Małe przypomnienie – klasyczny komputer prezentuje dane w ciągu bitów zapisywanych pod postacią 0 lub 1. Komputer kwantowy z kolei wykorzystuje kubity (bity kwantowe), które mogą mieć postać 0, 1 lub obu tych wartości jednocześnie. To trochę tak, jakby być w dwóch miejscach w tym samym momencie. Prezentowane jako jony, fotony lub maleńkie obwody nadprzewodzące, takie dwoiste stany stanowią o przewadze komputera kwantowego nad klasycznym. Jednocześnie jednak stanowią o jego kruchości – każda, nawet najmniejsza interakcja z otoczeniem, może zniekształcić zapisane dane. Aby stworzyć funkcjonalne komputery kwantowe, trzeba nauczyć się korygować te błędy. Eksperymenty Google’a i ogłoszona supremacja kwantowa to pierwszy krok do realizacji tego celu.

Jak przebić się przez szum?

Do zademonstrowania kwantowej supremacji Google’a, wystarczyły 53 kubity. Aby zakodować dane w pojedynczym kubicie z odpowiednią wiernością, konieczne musi być ich ok. 1000. Dlaczego?

Wynika to z algorytmu Shora z 1994 r., który jest jedną z podstaw kwantowej kryptografii. Peter Shor z MIT wykazał, że hipotetyczny komputer kwantowy powinien być w stanie szybko obliczać wielkie liczby, a tym samym dokonać możliwego rozkładu na czynniki pierwsze liczny naturalnej N. Algorytm Shora przedstawia możliwe faktoryzacje (rozkłady na czynniki) liczby jako fale kwantowe, które mogą jednocześnie przepływać przez kubity komputera, dzięki ich dwoistej naturze. Fale interferują ze sobą w taki sposób, że błędne faktoryzacje znoszą się nawzajem i pojawia się tylko ta właściwa. Maszyna działająca według algorytmu Shora mogłaby między innymi złamać systemy szyfrowania, które obecnie zabezpieczają komunikację internetową. W 2001 roku grupa informatyków z firmy IBM i Uniwersytetu Stanforda zademonstrowała działanie algorytmu Shora na 7-kubitowym komputerze kwantowym opartym o jądrowy rezonans magnetyczny. Dokonano wtedy rozkładu liczby 15.

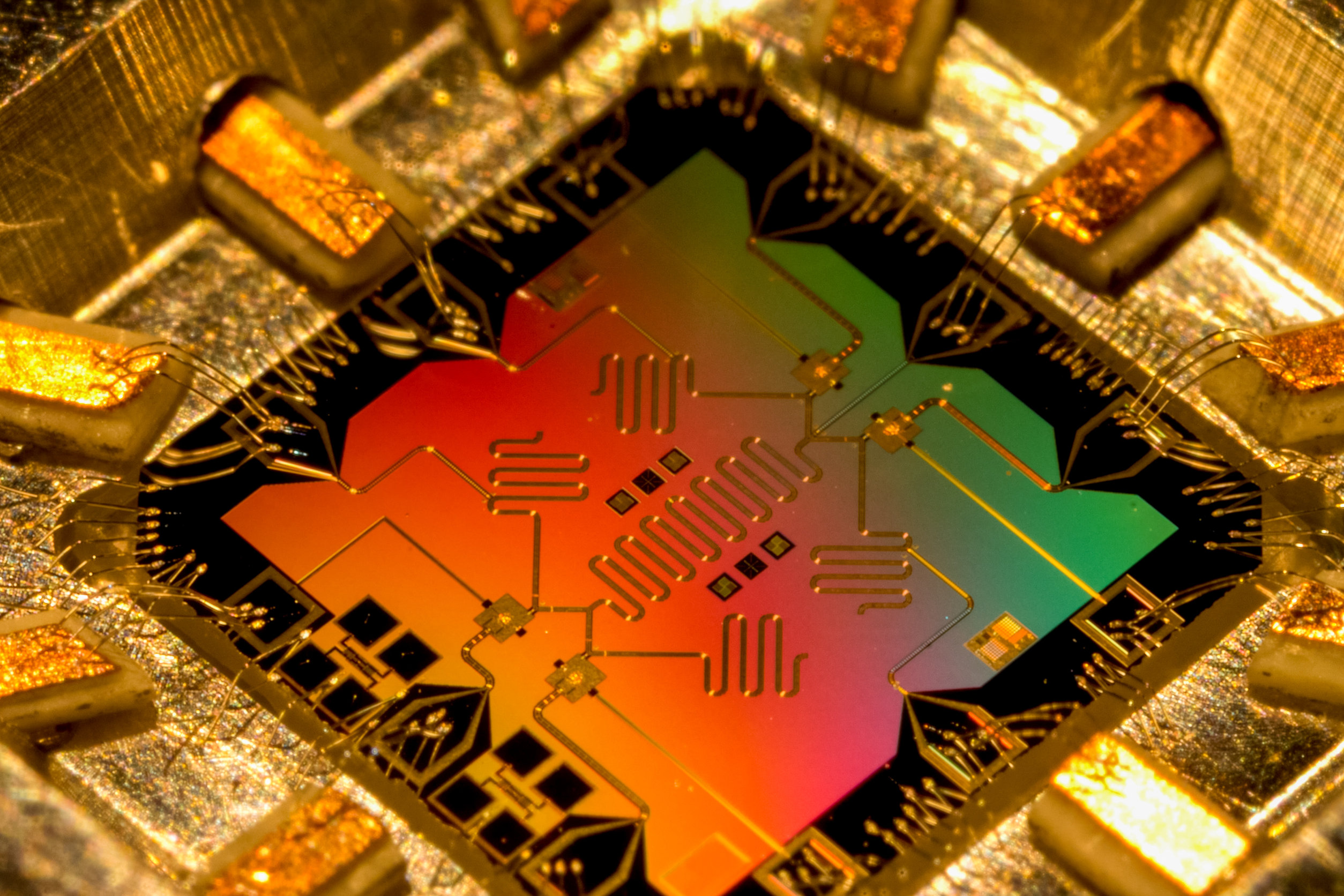

Shor dostrzegł, że każdy kubit będzie utrzymywał swój stan, więc fale kwantowe będą mogły rozchodzić się tak długo, jak będzie to konieczne. Prawdziwe kubity są znacznie mniej stabilne. Google, IBM i Rigetti używają kubitów wykonanych z maleńkich obwodów rezonujących z metali nadprzewodzących umieszczonych w mikrochipach, które jak dotąd okazały się łatwiejsze do kontrolowania i integrowania z obwodami niż inne typy kubitów. Każdy obwód ma dwa odmienne stany energetyczne, które mogą oznaczać 0 lub 1. Poddając obwód działaniu mikrofal, badacze mogą wprowadzić go w jeden z tych stanów lub dowolną ich kombinację – np. 30% 0 i 70% 1. Ale te pośrednie stany rozmywają się (dekoherują) w ułamku sekundy. Nawet zanim to nastąpi, szum może zakłócić stan i zmienić go, potencjalnie psując obliczenia.

Właśnie ten szum niemal zagłuszył sygnał w eksperymencie Google. Uczeni ustawili 53 kubity tak, aby kodowały wszystkie możliwe wyniki, które były w zakresie od 0 do 253. Następnie zaimplementowali zestaw losowo wybranych interakcji między kubitami, co sprawiło, że niektóre wyniki były bardziej prawdopodobne niż inne. Ze względu na złożoność interakcji, nawet najpotężniejszy superkomputer potrzebowałby tysięcy lat, aby obliczyć wzór. Komputer kwantowy Google dokonał czegoś, czego żadna inna maszyna na Ziemi nie byłaby w stanie dokonać. Problem polega na tym, że obliczony wzór był nieznacznie odróżnialny od losowych wyników spowodowanych szumem kubitów. Dlatego wielu ekspertów twierdzi, że to nie była żadna demonstracja ze strony giganta z Mountain View, a sprytna manipulacja.

Splątanie pomaga czy wszystko plącze?

Aby wyniki uzyskiwane w komputerach kwantowych były miarodajne, kubity muszą być tak niezawodne jak bity w klasycznych komputerach. To oznacza, że muszą być niewrażliwe na jakiekolwiek zaburzenia z zewnątrz. Niestety, nie da się przełożyć kodów korekcji błędów z klasycznych komputerów na komputery kwantowe.

Co więcej, mechanika kwantowa wymaga od uczonych, aby szukali błędów na oślep. Chociaż kubit może mieć wartość zarówno 0, jak i 1, to zgodnie z obowiązującymi teoriami, nie można zmierzyć dokładnej wartości, bez sprowadzenia kubitu do wartości 0 lub 1. To tak, jak z kotem Schrodingera.

Zakaz klonowania, czyli twierdzenie mówiące, że nie można wykonać kopii nieznanego stanu kwantowego, zostało sformułowane i udowodnione przez Williama Woottersa i Wojciecha Żurka oraz niezależnie przez Dennisa Dieksa w 1982 roku i ma fundamentalne znaczenie dla teorii mechaniki kwantowej oraz informatyki kwantowej. Mimo że nie można skopiować nieznanego stanu kwantowego kubitu, można rozszerzyć go na inne kubity przy pomocy zjawiska zwanego splątaniem kwantowym.

Splątanie kwantowe to bardzo subtelna sprawa. Poddany działaniu mikrofal, oryginalny kubit oddziałuje z innym poprzez bramkę CNOT (dwukubitową). Zmienia ona stan drugiego kubitu, jeżeli stan pierwszego wynosi 1 i pozostawia go bez zmian, jeżeli pierwszy kubit ma wartość 0. Ciekawe jest to, że operacja ta nie mierzy wcale stanu pierwszego kubitu i nie zaburza go. Dwa splątane kubity pozostają jednocześnie w stanie 0 i 1.

Jeśli oryginalny kubit jest w 30% w stanie 0 i w 70% w stanie 1, można połączyć go z innymi kubitami, tworząc łańcuch, np. trzech kubitów w stanie splątanym, w którym 30% wszystkich trzech jest 0, a 70% wszystkich trzech jest 1. To stan różny od trzech kopii oryginalnego kubitu. W rzeczywistości, żaden z trzech splątanych kubitów w łańcuchu nie ma własnego, jednoznacznie zdefiniowanego stanu kwantowego, ale te trzy kubity są całkowicie skorelowane. Jeśli zmierzymy pierwszy z nich i zmieni się on do wartości 1, to pozostałe dwa również muszą to zrobić. Ta korelacja jest esencją splątania. Dzięki splątaniu kwantowemu, naukowcy mogą łatwiej wychwytywać błędy w komputerach kwantowych, wplątując w kubity dodatkowe, zwane pomocniczymi. Każdy pomiar co prawda powoduje ich degradację, ale podstawowe kubity kodujące pozostają nietknięte.

Kiedy nadejdzie kwantowa przyszłość?

Naukowcy stoją jednak przed trudnym wyzwaniem. Manipulowanie poszczególnymi kubitami może wprowadzać błędy, a jeśli ten poziom błędów nie spadnie poniżej pewnej wartości, to splątanie kolejnych kubitów z oryginalnym spowoduje jedynie zwiększenie szumu w systemie. Pomocnicze kubity i inne mechanizmy korekcji błędów dodają jeszcze więcej szumu, a gdy uwzględni się te efekty, niezbędny próg błędu jeszcze bardziej się obniża. Aby schemat zadziałał, fizycy muszą obniżyć poziom błędu do mniej niż 1%. Ostatnie eksperymenty pozwoliły uzyskać poziom błędu 3%. Korekcja błędów wymaga również wielokrotnego manipulowania kubitami, co czyni cały proces bardziej wymagającym niż supremacja kwantowa.

Na ten moment, komputery kwantowe nie są w stanie udzielić ostatecznych odpowiedzi – zamiast tego odpowiedź, którą podają, jest najbardziej prawdopodobna, ale powinna być zweryfikowana przez klasyczny komputer. Na przykład, komputer kwantowy może podać najbardziej prawdopodobną odpowiedź na pytanie o złamanie algorytmu szyfrującego, ale będzie potrzebował klasycznego komputera do przetestowania odpowiedzi, aby ustalić, czy rzeczywiście została złamana.

Miną jeszcze całe dekady, zanim powstaną w pełni funkcjonalne i bezbłędne komputery kwantowe, ale jesteśmy na dobrej drodze do tej rzeczywistości.