Czym był procesor graficzny Larrabee Intela?

Na naszych łamach o Larrabee wspomnieliśmy stosunkowo niedawno, a to z okazji rozpisania się na temat tego, czy powinniśmy płakać (jako gracze) po tym, jak Intel najpierw oddał w nasze ręce, a następnie zablokował instrukcje AVX-512 dla platform z procesorami Alder Lake. Wtedy wspomnieliśmy, że instrukcje AVX-512, to dzieło z pierwszej dekady obecnego wieku, które ma swoje korzenie w projekcie Intel Larrabee. Ten miał na celu stworzenie procesora graficznego Intela typu GPGPU, czyli “tego wszechstronnego”, ale projekt upadł w 2009 roku i finalnie dał życie tylko Xeon Phi.

Czytaj też: Czym jest NFT? Niewymienialne tokeny mają swoje dobre i złe strony… zupełnie jak kryptowaluty

To właśnie w ramach mikroarchitektury Larrabee, której historia sięga 2006 roku (oficjalnie dowiedzieliśmy się o niej w 2008 roku) Intel opracował specjalny zestaw instrukcji AVX z 512-bitowym rejestrem. Sam w sobie procesor graficzny Larrabee Intela był okazją dla firmy do niemałych szaleństw, bo był którymś z rzędu podejściem do podbicia graficznego rynku i przebicia się przez ofertę NVIDIA oraz AMD. Przez swój charakter, przypominający bardziej hybrydę procesora graficznego i wielordzeniowego procesora centralnego (CPU), miał być wykorzystywany w tych bardziej profesjonalnych zadaniach.

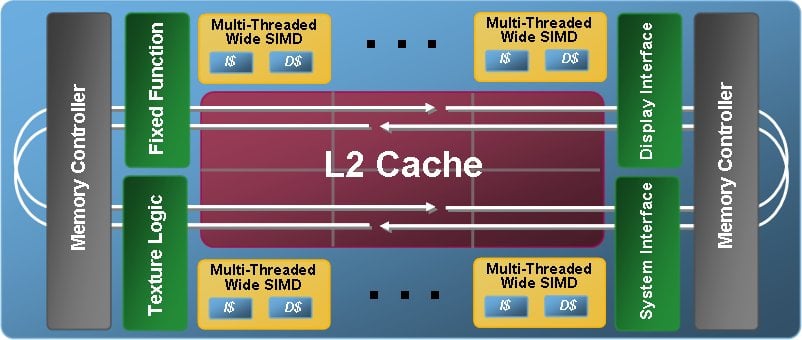

Oczywiście jak na GPU przystało, Larrabee obsługiwał tradycyjną grafikę rastrową w ramach API Direct3D, czy OpenGL. Jego wyjątkowość sprowadzała się do tego, że Intel połączył w jednym kawałku krzemu elementy CPU (związek z architekturą x86 i spójną hierarchię pamięci) z cechami charakterystycznymi dla GPU (512-bitowe jednostki wektorowe SIMD oraz te do próbkowania tekstur).

Czytaj też: Intel wycina siłą instrukcje AVX-512 z platform Alder Lake. Czy jest czego żałować?

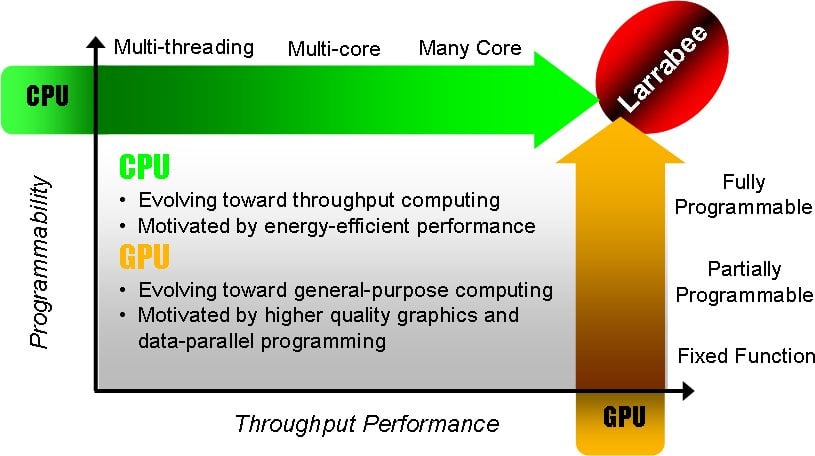

Jak to możliwe? Już spieszymy z wyjaśnieniem, choć zaznaczam, że nigdy nie powinniśmy krytykować Intela za próbę postawienia na swoim i próbę opracowania czegoś nowego. Bez takiego podejścia nie ma bowiem szansy na rewolucje, a poniższy diagram co do tego, co miały łączyć w sobie układy Larrabee, świetnie wskazuje, że na papierze pomysł był świetny.

Larrabee był znacznym odejściem od procesorów Intela. Pomimo wykorzystywania rdzeni na bazie architektury x86 i to z wieloma podobieństwami względem ówczesnych Intel Core. GPU Larrabee obsługiwał czterokierunkową wielowątkowość i bazował na jawnych instrukcji kontroli pamięci podręcznej, wykorzystując 1024-bitową magistralę pierścieniową do komunikacji między rdzeniami i pamięcią.

Czytaj też: Dlaczego gramy w gry? Badanie odpowiada jacy są Polscy gracze

Swoją wydajność oddawał w ręce 512-bitowej jednostce przetwarzania wektorowej, która mogła jednocześnie zajmować się 16 liczbami zmiennoprzecinkowymi pojedynczej precyzji na raz. Jeśli z kolei idzie o różnice Larrabee względem powszechnie przyjętych procesorów graficznych, sprawa rozbijała się o trzy główne kwestie. Intel, chcąc zapewnić mu wyższą elastyczność i szersze zastosowanie, postawił na:

- zestaw stricte procesorowych (CPU) instrukcji x86 ze specyficznymi rozszerzeniami

- niewielką liczbę wyspecjalizowanych akceleratorów/koprocesorów, odpowiadających za sferę graficzną

- spójność pamięci podręcznej we wszystkich rdzeniach

Warto tutaj wspomnieć, że procesor Larrabee wywodził się z układów Pentium, posiadając w pojedynczej matrycy do 32 rdzeni w układzie uporządkowanym z czterokierunkową wielowątkowością. Każdy rdzeń posiadał z kolei 512-bitową jednostkę przetwarzania wektorowego, a do komunikacji z pamięcią wykorzystywał dwukierunkową 512-bitową magistralę.

Czytaj też: Odkryto lukę bezpieczeństwa dysków SSD. Złośliwe oprogramowanie może nigdy nie zostać wykryte

Wedle konferencji Intela w 2008 roku, na której to przedstawiono Larrabee światu, programiści mogliby konkretnie ustawiać pożądane obciążenia dla każdego z 32 rdzeni. To miało zapewnić środowisku profesjonalnemu wyjątkowy koprocesor do obliczeń naukowych lub przetwarzania grafiki. Tak wyjątkowy, że Larrabee mógł robić to, co obecnie są w stanie dokonać karty GeForce RTX, czy nowsze Radeony – mowa o obsłużeniu Ray Tracingu w czasie rzeczywistym.

Droga Larrabee na rynek była wyboista i nigdy się nie skończyła

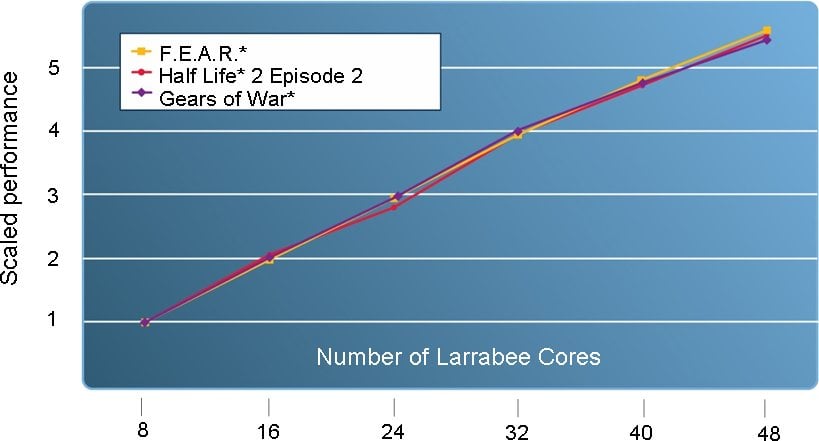

Rozpoczęty w 2006 roku projekt Larrabee zaliczył kilka kluczowych ogłoszeń, ale zdecydowanie najważniejszym dla graczy było wystąpienie Intela podczas SIGGRAPH 2008. Wtedy firma weszła w szczegóły działania procesora i pokazała, ile rdzeni wymaga ten procesor graficzny, aby uruchomić Gears of War, F.E.A.R i Half-Life 2: Episode 2 z 4-krotnym antyaliasingiem w 60 FPS i rozdzielczości 1600×1200. Na całe szczęście było to kolejno 25, 25 i 10 rdzeni, co nie wychodziło poza maksymalnie przewidziane w pierwszej generacji 32 rdzenie.

Czytaj też: Wydajność zużytego SSD. Wykończyliśmy dysk, żebyście Wy nie musieli

Niestety 4 grudnia 2009 roku Intel oficjalnie ogłosił, że pierwsza generacja Larrabee nie zostanie wydana w postaci karty graficznej z myślą o graczach przez opóźnienia w rozwoju sprzętu i oprogramowania. Dlatego Larrabee miało pozostać produktem przeznaczonym na rynek profesjonalny, co też się nie udało się, o czym dowiedzieliśmy się 25 maja 2010 roku. Wtedy Intel ogłosił, że Larrabee nie zostanie wydany jako procesor graficzny, ale jako produkt dla obliczeń o wysokiej wydajności, mający konkurować z akceleratorami Tesla od NVIDIA.

Tak też technologia Larrabee trafiła do działu superkomputerów Intela, który ostatecznie opracował akcelerator dla wysokowydajnych obliczeń pod nazwą kodową Knights Corner, a w 2012 roku w postaci koprocesorów Xeon Phi.