USB zrewolucjonizowało korzystanie z komputerów na wiele sposobów

Universal Serial Bus, czyli uniwersalna magistrala szeregowa, która jest już z nami od 1996 roku, stała się podstawowym złączem, bez którego nie wyobrażamy sobie komputerów i laptopów. Te złącza są stosowane tam, gdzie potrzebny jest zarówno transfer danych, jak i energii elektrycznej, czyli praktycznie w każdym sprzęcie elektronicznym codziennego użytku.

Czytaj też: Choć niechętnie, Apple w końcu potwierdza – iPhone przechodzi na USB-C

Nie bez powodu zresztą USB ma w nazwie określenie czegoś “uniwersalnego”, bo takie właśnie było, kiedy przed dekadami zastąpiło stare porty równoległe i szeregowe. Niczym odpowiednik SATA, które zastąpiło ATA, USB dziś nie wydaje się specjalnie rewolucyjnym złączem, ale dawniej był to standard całkowicie odmieniający sposób korzystania z komputerów. Oferowało bowiem szeroką kompatybilność, funkcję plug&play i hotplug, pozwalało systemowi natychmiast rozpoznawać rodzaj podłączonego sprzętu, a wisienką na torcie były wysokie transfery danych, jak na tamte czasy złącz zewnętrznych.

USB 2.0 powstało w 2001 roku, a nadal jest spotykane w laptopach i płytach głównych

Zacznijmy od tego, że tradycyjne USB-A 2.0 rzeczywiście znika powoli z naszego życia, bo nowe laptopy i płyty główne z górnej półki porzucają je na rzecz nowszych, lepszych rozwiązań. Wystarczy jednak spojrzeć na modele ze średniej i niskiej półki, żeby zrozumieć, że jeśli tak dalej pójdzie, to USB 2.0 będzie towarzyszyło nam jeszcze przez dobrą dekadę, a nawet dwie, jeśli obecnie kupowane budżetowe sprzęty posłużą tak długo.

Skąd ten wniosek? Bo patrzę tak na nasze testy płyt głównych i dostrzegam, że nawet najbardziej zaawansowane płyty główne nadal mają przynajmniej dwa porty USB 2.0 (np. ASRock Z790 PG Riptide), choć zdarzają się rodzynki całkowicie ich pozbawione (ASRock X570 PG Velocita). W laptopach sprawa ma się już znacznie lepiej, bo ze względu na coraz bardziej kompaktowe rozmiary i rozwijające się chipsety, producenci mogą z czystym sumieniem zrezygnować całkowicie ze starych standardów na rzecz nowych, kiedy stają przed wyborem dwóch USB 3.1 lub dwóch USB 2.0.

Jeśli już przy tym akurat jesteśmy, warto wspomnieć, dlaczego producentom tak naprawdę opłaca się nadal wykorzystywać złącza USB 2.0. Wprawdzie miejsce na panelu wyjść płyt głównych jest cenne, ale znacznie cenniejsze są ścieżki na płytach głównych, a z racji wyższych transferów, USB 3.X wymagają znacznie lepszych połączeń, które z kolei zajmują miejsce na laminacie i są droższe w implementacji, pochłaniając więcej miedzi. Nie są to pozornie ogromne kwoty, ale jeśli zsumować koszt materiałów i procesu produkcji, a następnie przemnożyć to przez setki tysięcy produkowanych modeli, wynik może zrobić wrażenie.

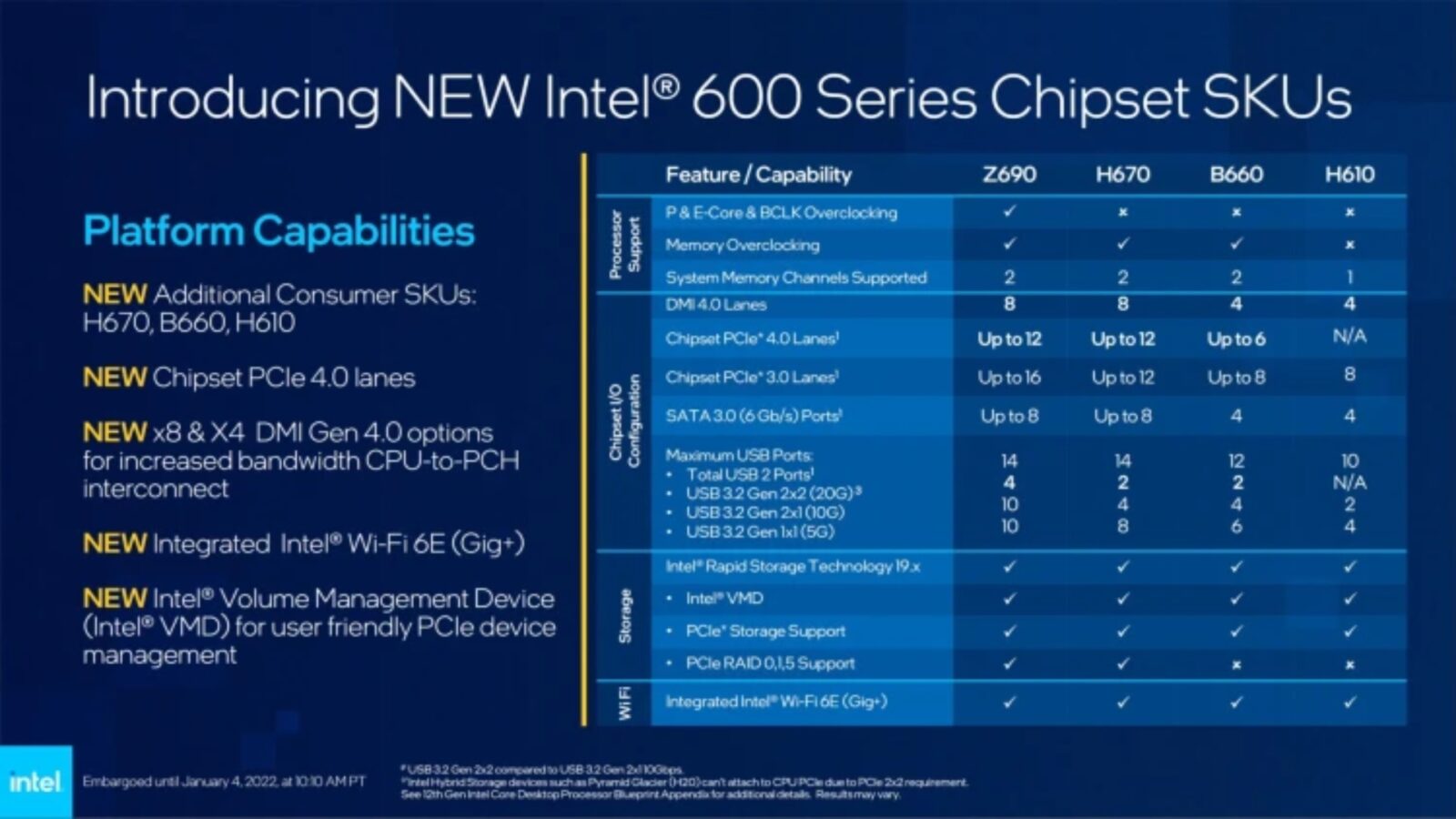

Dlatego właśnie tańsze płyty mają mniej zaawansowane chipsety, które są w stanie obsłużyć mniejszą liczbę bardziej zaawansowanych portów USB. Powyżej możecie zresztą rzucić okiem na porównanie chipsetów Intela z serii 600, które potwierdza, że liczba USB jest ograniczona zależnie od rodzaju tegoż układu. Jest ona więc bezpośrednio powiązana z “mocami przerobowymi” chipsetu, a USB 2.0 stanowią w tych konfiguracjach świetne “wypełnienie” jako standard wymagający najmniejszej ilości zasobów.

Co jest nie tak z USB 2.0?

USB 2.0 jest przestarzałe, a i tak nadal utrzymuje się w użytku, choć jeśli zastanowimy się nad tym, kompletnie go nie potrzebujemy. Nie tylko dlatego, że jego transfer jest mizerny (ledwie 480 Mb/s) na tle najnowszych wariantów USB 3.X (3.2 zapewnia aż 20 Gb/s) i tym bardziej USB4 o prędkości 40 Gb/s, ale też przez fakt, że większość nawet najnowszych sprzętów podpinanych do USB jest wstecznie kompatybilna ze USB 2.0. To pozornie coś dobrego, ale tylko wtedy, kiedy znacie się nieco na sprzęcie.

Sprawa ma się inaczej, jeśli za podpinanie peryferiów weźmie się kompletny laik i np. podepnie dysk zewnętrzny lub HUB nie do najwydajniejszego portu USB 3.X, a do USB 2.0. Jeśli zorientuje się, że coś jest nie tak, to są szanse, że po krótkim researchu przepnie urządzenie do dedykowanego portu, ale jeśli nie… to tak zapewne pozostawi swoją konfigurację, nie wiedząc, że jego sprzęt działa przez to wolniej i będzie tak trwać nierzadko przez długie lata.

Czytaj też: Klamka zapadła. Unia Europejska podała konkretną datę dla obowiązkowego USB-C w telefonach

Naprawdę chciałbym, żeby to był tylko wymyślony na potrzeby tego artykułu problem, ale ledwie kilka tygodni temu w taki oto sposób pozwoliłem znajomemu zapomnieć o bolączce przerywającego się ciągle połączenia sieciowego. Problem był spowodowany właśnie tym, że podłączył HUB z RJ-45 właśnie do USB 2.0, a następnie do tego samego HUB-u połączył myszkę i klawiaturę, nawet nie zdając sobie sprawy, że zapycha tym sposobem port. Dlatego też jestem pewny, że “problem USB 2.0” istnieje, nawet u niedzielnego użytkownika.

Wszystko przez to, że wiele obecnie stosowanych urządzeń może działać na USB 2.0, ale pełnię możliwości zapewniają tylko na jednej z wersji USB 3.0. Mowa o dyskach zewnętrznych, kamerkach internetowych, urządzeniach do przechwytywania obrazu z myślą o streamowaniu, czy właśnie wspomnianych HUB-ów. W gruncie rzeczy na połączeniu USB 2.0 nie traci (najczęściej) tylko myszka, klawiatura, kontroler i słuchawki…, ale to jedynie pozór.

Standard USB 2.0 zachowywany “dla peryferiów” to głębszy problem

W rzeczywistości USB 2.0 może śmiało poradzić sobie z transferem, którego potrzebują peryferia (dlatego też ciągle jest powszechnie używane – jest tanie, powszechnie znane i ciągle potrzebne), ale samo zastosowanie tego złącza generuje opóźnienie rzędu około milisekundy. Wszystko przez przewód, który przesyła elektrony tam i z powrotem przez miedziane druciki, a dokładniej mówiąc, ich opór energetyczny… i tak – to samo dręczy również nowsze USB. Problem w tym, że tak jak nowsze USB są stosowane głównie do podłączania HUBów, zewnętrznych nośników danych i peryferiów wrażliwych na transfer (m.in. kamerki), tak USB 2.0 przyjęło się jako podstawowy standard dla peryferiów.

Jak więc rozwiązać problem tego przestarzałego standardu, który jest z nami tylko dlatego, że firmy nie przejmują się około milisekundowym opóźnieniem i nadal pchają na rynek sprzęty z USB 2.0? W gruncie rzeczy ratunek przed tym opóźnieniem zapewniłoby ulepszenie USB o jeden światłowód, który pełniłby funkcję transferu danych, podczas gdy pozostałe odpowiadałyby ciągle za zapewnianie zasilania. Oczywiście w takiej sytuacji światłowód mógłby wysyłać dane tylko w jedną stronę, dlatego nie nadawałby się do wszystkich peryferiów, ale ograniczyłby opóźnienie zauważalnie w przypadku zwłaszcza myszek… choć byłoby to odczuwalne wyłącznie w grach.

Skrócenie czasu, w którym dane wejściowe są pozyskiwane z urządzeń peryferyjnych robiłoby bowiem ogromną różnice przy graniu w dynamiczne gry w 120 Hz i 120 FPS, bo wtedy dodatkowa milisekunda opóźnienia spowodowana samym interfejsem stanowiłaby ponad 10 procent z 8 ms potrzebnych do wygenerowania klatki. Im wyższa płynność, tym ten problem jest większy, bo przykładowo przy 240 FPS/240 Hz ta jedna milisekunda dodaje aż 25% opóźnienia do błogiego 4-milisekundowego input laga, niszcząc tym samym w pewnym stopniu ogólną responsywność.

Co zyskamy, jeśli USB 2.0 zniknie?

Podsumowując więc, gdyby z dnia na dzień ze świata zniknęły wszystkie porty USB 2.0, producenci musieliby albo wciskać nam koncentratory USB, żebyśmy mogli podpiąć do swoich komputerów myszkę, klawiaturę, a nierzadko również słuchawki oraz kontroler bez zajmowania wydajniejszych portów, albo wymyślić alternatywę w postaci np. opisanego wyżej “światłowodowego USB”. Wtedy takie przykładowe “USB-F” (USB-Fiber) zagwarantowałoby zerowe opóźnienia przesyłania danych, co doceniliby głównie gracze, a laicy byliby odgórnie chronieni przed wpadką z podpinaniem nowych sprzętów.

Czytaj też: Wyjaśniamy tajemnice USB i wskazujemy, dlaczego USB-C jest tak rewolucyjny

Czy zysk byłby warty poświęcenia? Zważywszy na ograniczoną liczbę graczy dynamicznych produkcji, którzy grają na przynajmniej 120-hercowych monitorach, a ich komputery pozwalają wyciągać w grach liczbę FPS-ów odpowiadającą odświeżaniu, najpewniej nie. Zwłaszcza że w potencjalnie najbardziej żyznym gruncie, który zyskałby na niższych opóźnieniach, czyli na rynku AR i VR, stawia się obecnie na bezprzewodowe rozwiązania. Więcej na temat samego input laga możecie przeczytać tutaj.