Dostępne w trzech edycjach Gemini od Google’a to interesujące rozwiązanie do rozmaitych zastosowań, które w testach wypadło bardzo przekonująco – a zwłaszcza jego wersja Ultra. Jednak MS nie czekało z założonymi rękoma i wprowadziło pewne zmiany, dzięki którym kolejne testy wykazują jego przewagę. W niektórych sytuacjach bardzo dużą, w innych – niewielką. Ale zawsze lepiej niż Gemini.

Microsoft coraz mocniej inwestuje w SI

Przypomnę: przed tygodniem Google pokazał wyniki testów, w których Gemini wygrało z modelem GPT-4 w 30 z 32 testów. Błysnęło także tym, że w MMLU (massive multitask language understanding) uzyskało wynik 90% i potrafiło sprawnie łączyć informacje z 57 zróżnicowanych dziedzin – od matematyki po historię i etykę – aby podawać rozwiązania problemów lub odpowiadać na zadane pytania.

Microsoft odpowiedział na to, wprowadzając Medprompt, czyli specjalną technikę wpisywania komend (promptów). Składa się ona z kilku płynnie połączonych ze sobą strategii ich wprowadzania, co pozwala osiągnąć znacznie lepsze wyniki. W związku z tym okazuje się lepsze od Gemini – także w MMLU. Co więcej, w MMLU pobija dotychczasowe rekordy. Pokazuje to, że wszystkie możliwości tego modelu nie zostały jeszcze odkryte, a jego efektywność może być znacznie większa od tej, do której przywykliśmy.

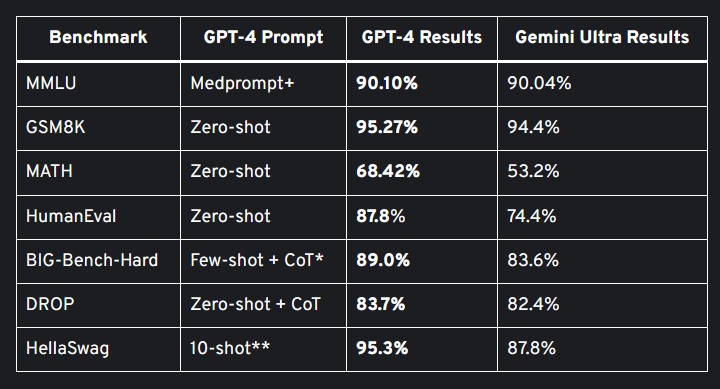

A oto porównanie benchmarków. Na rynku Gemini Ultra i ChatGPT-4.

Czytaj też: Gemini czyli Google staje w szranki z Microsoftem na rynku SI

Przyjrzyjmy się pierwszemu wynikowi, czyli wspomnianemu MMLU. Najpierw użyto tu normalnych promptów dla GPT-4, co dało wynik 89,1%. Znacznie mniej od 90,04% od Gemini, prawda? Ale gdy zwiększono ilość zapytań zespolonych z 5 do 20, wówczas wynik lekko się podniósł – do 89,56%. To nadal niesatysfakcjonująco, dlatego rozszerzono Medprompt do Medprompt+. A więc uproszczono komendy i sformułowania, co pozwoliło uzyskać 90,10%, a więc wyprzedzić rywala.

Oczywiście to wszystko w dużym skrócie. Dokładne wyjaśnienie na temat tego, jak działa nowa technika, znajdziesz na tej stronie. A póki co czekamy, co na to Google…