Mężczyzna odkrył poważny błąd w platformie AI firmy Meta, który ujawniał prywatne czaty. Pokazuje to nie tylko, że warto szukać dziury w całym, ale również wskazuje na przykry fakt, że żaden system nie jest do końca bezpieczny.

Meta AI wciąż wymaga dopracowania

Meta niedawno załatała lukę w zabezpieczeniach swojego chatbota AI, która powodowała, że prywatne komunikaty użytkowników oraz generowane przez sztuczną inteligencję odpowiedzi były widoczne dla innych użytkowników. Sandeep Hodkasia, założyciel firmy testującej bezpieczeństwo AppSecure, natknął się na lukę i poinformował firmę o niej w grudniu ubiegłego roku. Meta nagrodziła mężczyznę za ujawnienie informacji, wypłacając mu około 10 000 dolarów w ramach programu nagród za wykrycie błędów.

Gigant technologiczny potwierdził, że błąd już nie istnieje, a luka w zabezpieczeniach została usunięta. Dodał również, że chociaż luka w systemie istniała, nie było dowodów na jej wykorzystanie. Hodkasia wyjaśnił, że dowiedział się o istniejącej luce, badając sposób, w jaki Meta AI pozwala zalogowanym użytkownikom edytować komunikaty w celu odtworzenia tekstu i obrazów. Może się to wydawać prostą funkcją, ale biorąc pod uwagę, jak ujawnia ona wrażliwe interakcje użytkownika, wcale nie jest taka prosta.

Czytaj też: Użytkownicy Meta AI nieświadomie publikują prywatne rozmowy. Katastrofa prywatności

Skąd się wziął problem? Otóż serwery, jakich używa Meta, nie weryfikowały w pełni, czy użytkownik żądający monitu posiadał autoryzację dostępu. Systemy nadawały każdemu monitowi unikalny identyfikator – każdy, kto mógł go zmodyfikować, mógł zarazem przechwycić monity i uzyskać dostęp do nich bez odpowiedniego upoważnienia. Ponieważ identyfikatory były przewidywalne, stanowiło to poważną wadę, która mogła potencjalnie utorować drogę atakującym do zdobycia poufnych informacji.

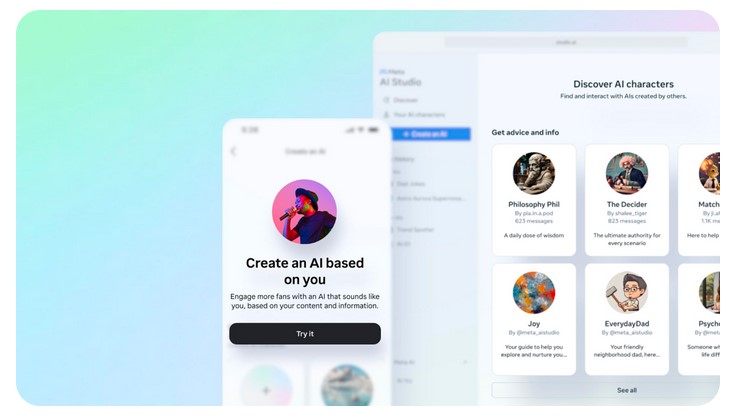

Odkrycie luki w zabezpieczeniach pociągnęło za sobą wzmożoną kontrolę praktyk Meta w zakresie sztucznej inteligencji, zwłaszcza po premierze jej samodzielnej aplikacji w zeszłym roku. Aplikacja nieumyślnie ujawnia prywatne rozmowy z powodu niejasnych ustawień udostępniania. Wielu użytkowników nie zdaje sobie sprawy, że ich interakcje są udostępniane publicznie z powodu tej funkcji w aplikacji, co prowadzi do wielu wątpliwości co do etycznego i odpowiedzialnego podejścia giganta technologicznego do sztucznej inteligencji.