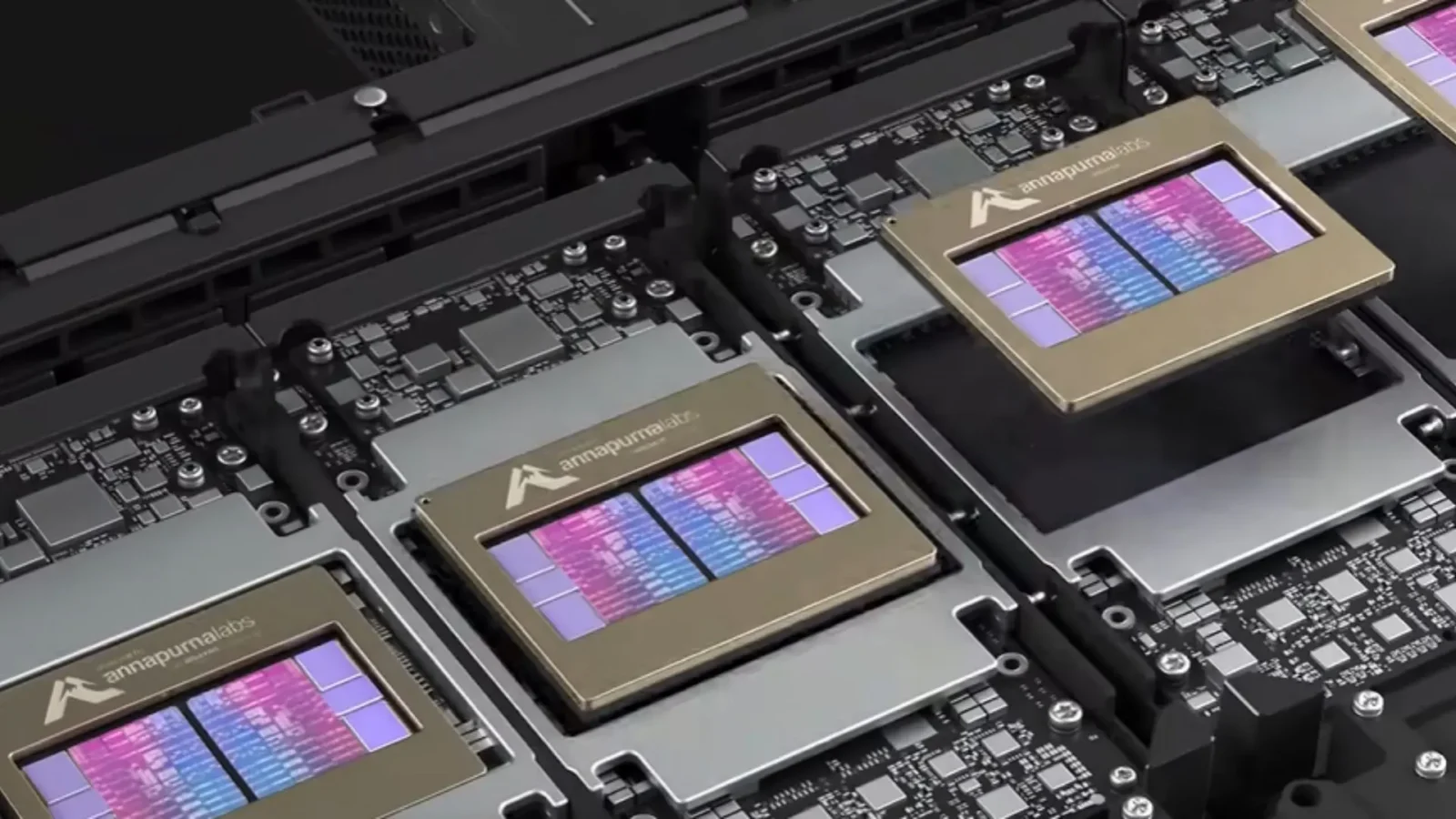

Nowe układy Trainium3 w litografii 3 nm

Najważniejszą informacją dotyczącą Trainium3 jest przejście na proces litograficzny 3 nm – taka zmiana pozwala oczywiście na upakowanie znacznie większej liczby tranzystorów na mniejszej powierzchni. W porównaniu do swojego poprzednika, Trainium2, nowy układ oferuje:

- 4-krotny wzrost wydajności obliczeniowej,

- 40-procentową poprawę efektywności energetycznej (wydajność na wat),

- Prawie 4-krotnie większą przepustowość pamięci.

Te parametry nie są jedynie pustymi cyframi w specyfikacji – większa przepustowość pamięci jest krytyczna przy trenowaniu dużych modeli językowych (LLM), które muszą nieustannie przesyłać ogromne ilości danych między pamięcią a jednostkami obliczeniowymi. Eliminując te „wąskie gardła”, Trainium3 pozwala na znacznie szybsze iteracje podczas uczenia maszynowego.

Sam chip to tylko część układanki. Amazon zaprezentował również Trn3 UltraServer – zintegrowane rozwiązanie serwerowe zaprojektowane specjalnie, by wykorzystać potencjał nowego procesora. Poprzednia generacja serwerów (Trn2) mieściła 64 chipy, nowy Trn3 UltraServer skaluje się aż do 144 połączonych układów Trainium3 w jednym systemie. Dzięki temu firmy mogą trenować modele o skali, która wcześniej wymagała budowania skomplikowanych i kosztownych klastrów z tysięcy oddzielnych maszyn.

Zagęszczenie mocy obliczeniowej w ramach jednego serwera ma bezpośrednie przełożenie na szybkość komunikacji między chipami. W świecie AI, gdzie modele są trenowane równolegle na wielu procesorach, opóźnienia w przesyłaniu danych są wrogiem numer jeden dla twórców modeli – Amazon zaś twierdzi, że nowa architektura pozwala na 3-krotnie wyższą przepustowość na chip przy jednoczesnym zachowaniu niskich opóźnień.

Do walki wchodzą mistrzowie Excela

To, co najbardziej interesuje mistrzów Excela, czyli dyrektorów finansowych firm technologicznych, to nie nanometry, ale dolary. Strategia Amazonu od lat opiera się na oferowaniu lepszego stosunku ceny do wydajności, a Trainium3 jest tego doskonałym przykładem – klienci mogą spodziewać się oszczędności rzędu 30-40% w porównaniu do korzystania z porównywalnych instancji na bazie GPU Nvidii. W przypadku niektórych zastosowań, takich jak wnioskowanie (inference) w czasie rzeczywistym czy generowanie wideo, partnerzy tacy jak Decart zgłaszają nawet 4-krotny wzrost szybkości przy o połowę niższych kosztach.

Dla firm takich jak Anthropic (twórcy modelu Claude), które ściśle współpracują z AWS, dostęp do tańszej mocy obliczeniowej oznacza możliwość trenowania kolejnych generacji „inteligentniejszych” modeli bez nadmiernych wydatków. „Demokratyzacja dostępu do superkomputerów” – tak Amazon określa swoją misję, sugerując, że trenowanie modeli frontierowych (najnowocześniejszych) nie powinno być zarezerwowane tylko dla garstki najbogatszych korporacji.

Czytaj też: iPhone 17 Pro stracił kluczową funkcję i nikt nie wie, dlaczego

Panu bogu świeczkę, diabłu ogarek – Trainium4 i współpraca z Nvidią

Ciekawym wątkiem poruszonym przy okazji premiery jest fakt, że Amazon nie zamyka się całkowicie na technologie konkurencji. Zapowiedziano już prace nad Trainium4, który ma wykorzystywać technologię NVLink Fusion od Nvidii. Sugeruje to pragmatyczne podejście: Amazon buduje własne, tańsze chipy dla masowego klienta, ale jednocześnie integruje najlepsze technologie łączenia chipów dostępne na rynku, nawet jeśli pochodzą od rywala. Dzięki temu w przyszłości zapewne zobaczymy centra danych integrujące rywalizujące ze sobą układy AI i GPU w hybrydowych jednostkach obliczeniowych.

Premiera Trainium3 to coś więcej niż tylko aktualizacja sprzętu – era monopolu na rynku akceleratorów AI może dobiegać końca. Dzięki przejściu na technologię 3 nm i znacznemu zwiększeniu gęstości serwerów, nie mówiąc o agresywnej polityce cenowej, Amazon oferuje realną alternatywę dla firm budujących przyszłość sztucznej inteligencji. Rywalizacja między architekturami wywodzącymi się z GPU a wyspecjalizowanymi układami AI zapowiada się co najmniej interesująco.