Dla tokijskiego uniwersytetu rutynowa kopia zapasowa okazała się koszmarna w skutkach. Na szczegóły jeszcze czekamy, ale powód usunięcia danych badawczych z superkomputera doskonale znamy

Między 14 a 16 grudnia trwał koszmar, który będzie spełzać sen z powiek członkom aż 14 grup badawczych na Kyoto University. Jednym bardziej, a drugim tylko przez chwilę, o czym za moment. Aż tyle zespołów naukowców zostało dotkniętych błędem podczas rutynowej procedury tworzenia kopii zapasowej, która sama w sobie ma właśnie uchronić dane naukowców przed takimi incydentami. Szczegóły pozostają jeszcze nieznane poza tym, że proces zatrzymano, kiedy wykryto błąd, ale jego skutki doskonale znamy.

Czytaj też: Galerie handlowe staną się hybrydowe. I to szybciej niż myślicie

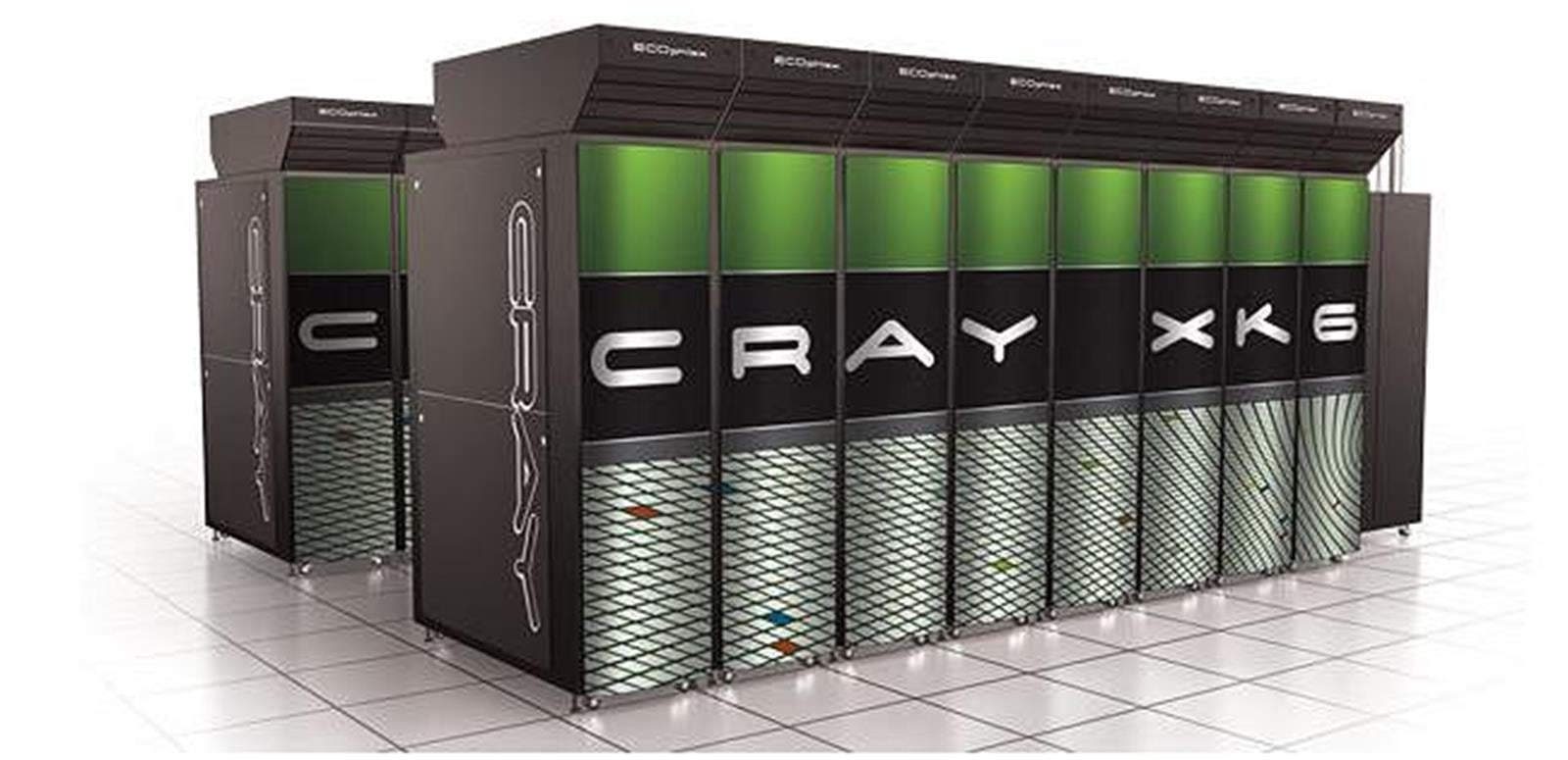

Przez błąd system usunął około 34 milionów plików należących do 14 różnych grup badawczych, które były efektem pracy superkomputera. Nie byle jakiego, bo naukowcy na tym japońskim uniwersytecie mają dostęp do superkomputerów firmy Cray, wśród których ten najwydajniejszy ma dostęp do aż 122400 rdzeni obliczeniowych i 197 TB pamięci. Nie jest więc sam w sobie magazynem danych (co nie dziwi) i dlatego uzyskane z jego pomocą obliczenia i dane są przesyłane do stosownych magazynów danych za pośrednictwem systemu Exascaler, który może przesyłać 150 GB danych na sekundę i przechowywać do 24 petabajtów informacji.

Czytaj też: Miła niespodzianka: Kosmiczny Teleskop Jamesa Webba będzie działał dłużej niż planowano

Sam w sobie koszt stworzenia superkomputera jest wydatkiem rzędu miliardów złotych, ale są to wydatki konieczne, aby popychać wiele odkryć, analiz i wynalazków do przodu. Jednak zakup, to dopiero początek i tak też każda godzina pracy takich sprzętów, które nierzadko przypominają rozmiarami komputery z początku cyfrowej ery (te w pomieszczeniach), często kosztuje całe setki dolarów. Możemy więc sobie wyobrazić, jak ważne te dane były dla naukowców i drogie nie tylko pod kątem wartości ukrytej w nich wiedzy.

Czytaj też: Starship od SpaceX jeszcze nie poleci w kosmos. Plany kolonizacji Marsa stanęły pod znakiem zapytania

Pocieszeniem jest jednak to, że z początkowych szacunków utraty 100 TB danych, utracono “tylko” 77, z czego ponad połowa, bo 10 z 14 grup badawczych najpewniej odzyska część swojej pracy. Oby jednak historia się nie powtórzyła, bo na ten moment uniwersytet całkowicie zrezygnował z procesu tworzenia kopii zapasowych i wprowadzi go ponownie w gdzieś w 2022 roku w formie przyrostowej kopii zapasowej oraz tej kompletnej.