W ostatnich dniach ChatGPT potwierdził mi, że sztucznej inteligencji nie ma co ufać

Jak bardzo wasze życie zmieniło się od premiery ChatGPT i niedawnego wzrostu jego popularności do tego stopnia, że nawet najmniej zaawansowani technologicznie użytkownicy dowiedzieli się co nieco na jego temat? Moje w pewnym stopniu przeżyło rewolucję, bo narzędzie okazało się świetnym zamiennikiem przeszukiwania odpowiedzi na Stack Overflow w poszukiwaniu odpowiedzi na programistyczne problemy i wątpliwości.

Czytaj też: Sprawdziłem, jak działa nowy Bing. Internet zmieni się nie do poznania

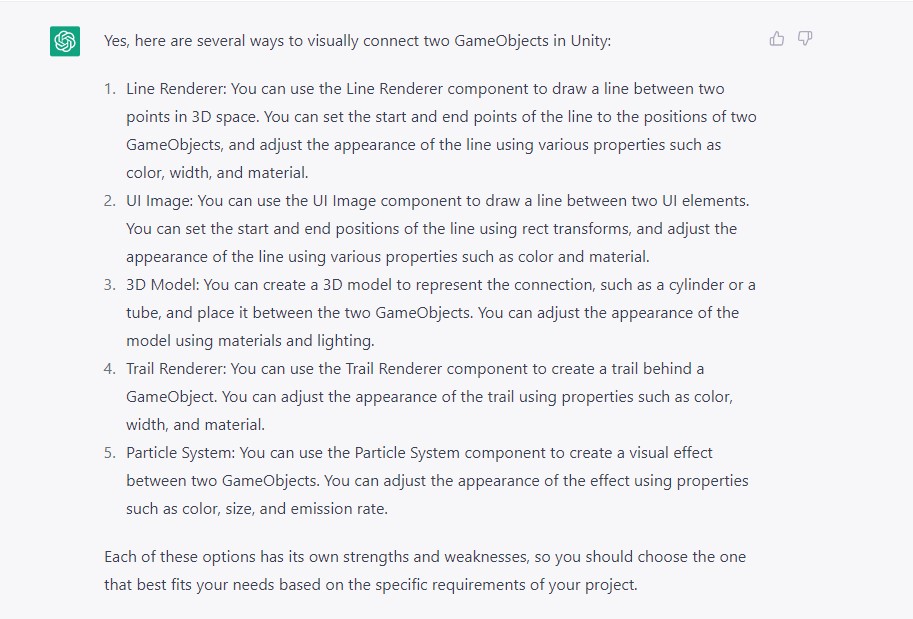

Chciałem znaleźć sposób na wizualne połączenie dwóch postaci na mapie. Bam, dostałem listę potencjalnych rozwiązań… o których doskonale wiedziałem i które analizowałem przed zadaniem pytania chatbotowi. Tyle tylko, że żadne zaproponowane rozwiązanie nie spełniało wymagań mojego scenariusza i dopytywanie ChatGPT na niewiele się zdało, więc dopiero przegrzebywanie sieci pozwoliło mi znaleźć to, czego szukałem.

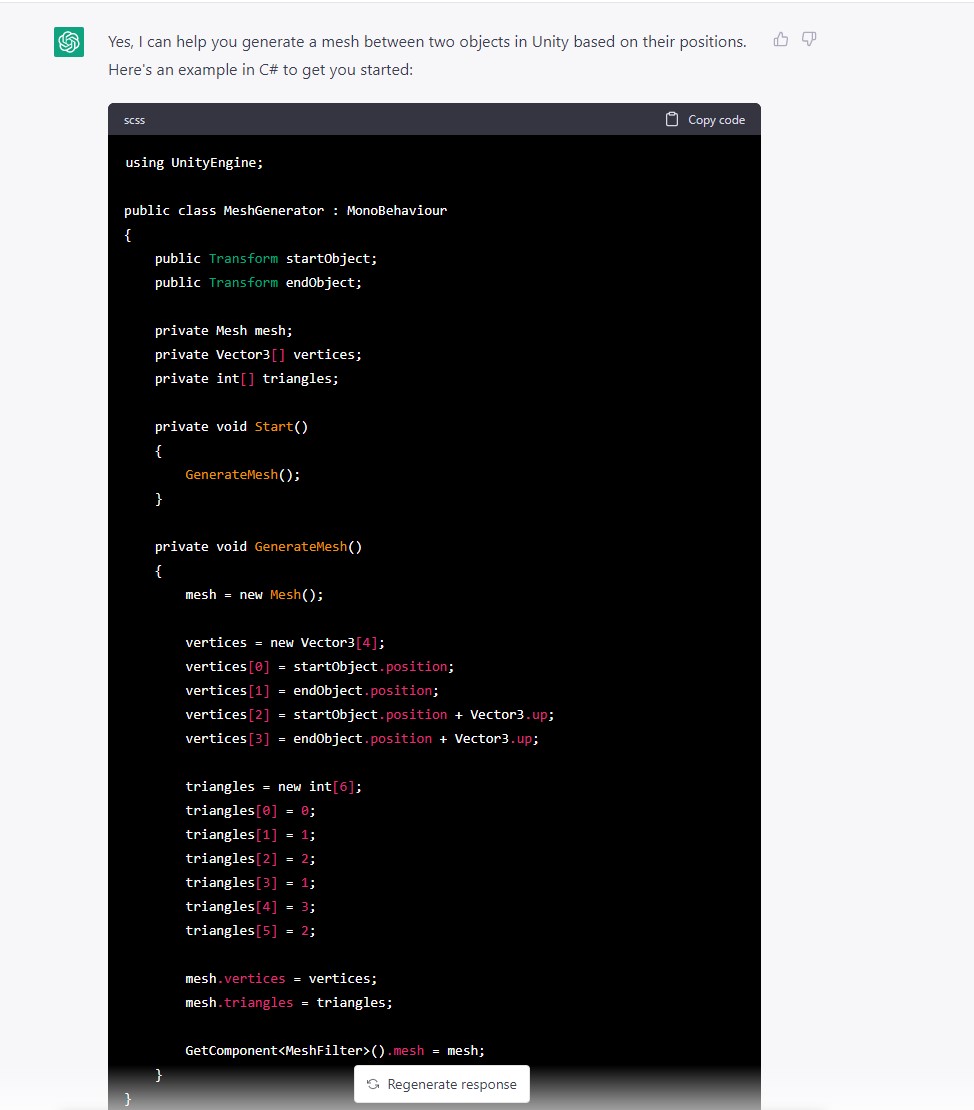

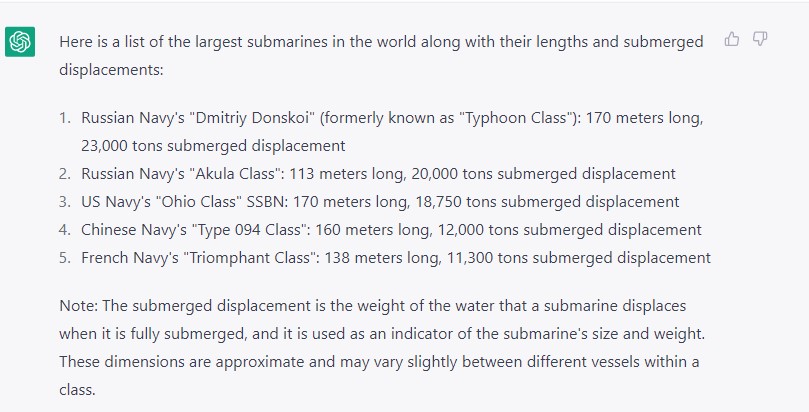

Wystarczyło jednak zapytać bota, czy aby odszukane przeze mnie rozwiązanie również by się nadało i voila, potwierdził moje przemyślenia, a nawet podrzucił wstępny kod do generowania danej struktury i go wyjaśnił. W tego typu scenariuszach sprawdza się więc idealnie…, ale tylko wtedy, jeśli macie proste problemy do rozwiązania. W innym wypadku research jest po prostu koniecznością i to nie w chatbocie, a w starej dobrej przeglądarce. Sprawa ma się bardzo podobnie podczas wyszukiwania ciekawostek i robienia np. zestawień, a świetnym tego przykładem jest moja próba wygenerowania listy pięciu największych okrętów podwodnych na potrzebę artykułu o decyzji rosyjskiej marynarki.

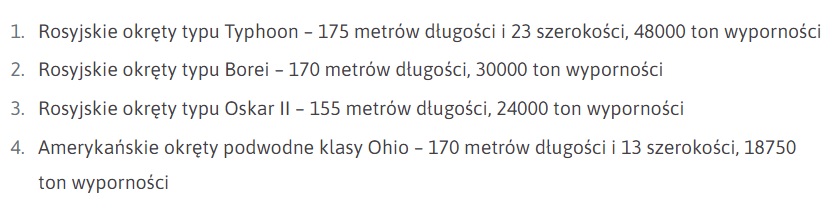

Owoc pracy ChatGPT możecie podejrzeć powyżej… tyle tylko, że obeznani w świecie okrętów podwodnych wiedzą, że ten TOP 5 to wierutne bzdury. Sztuczna inteligencja nie tylko nie zadbała o odpowiednią kolejność tego zestawienia, ale też pomyliła kilka wartości i podała nie interesującą mnie wyporność (po zanurzeniu), a tę po wynurzeniu. Innymi słowy, w tej próbie przyspieszenia sobie pracy z ChatGPT finalnie straciłem więcej czasu na weryfikowanie informacji w innych źródłach, bo poprawne zestawienie wygląda o tak:

Dlatego właśnie ChatGPT i wszelką jego konkurencję należy – póki co – traktować jak popełniające błędy narzędzia, a nie coś, co może zastąpić bardziej doświadczonego człowieka w pracy. Porównanie listy okrętów jest tego dobrym przykładem, ale to ten z programowania jest najlepszy, bo pokazuje, że ślepe wklepywanie w okienko czatu zapytań i kopiowanie podawanych rozwiązań, to przepis na katastrofę. Tak się bowiem składa, że każda z pięciu propozycji kompletnie nie nadawałaby się do współtworzonej przeze mnie gry (możecie ją nawet ograć w ramach festiwalu dem na Steamie), gdzie albo generowałaby problemy wizualne, albo wydajnościowe. Wraz z rozwojem technologii może się to poprawić, ale tego typu przykłady mówią jasno – nie ufajcie sztucznej inteligencji. To (jeszcze) nie czas, żeby była w stanie zastąpić ludzi, a jeśli nie wierzycie mi, to zapewne uwierzycie krytykom, którzy zaatakowali Google po prezentacji możliwości Barda.

Chatbot Bard sprzedał fejka na oficjalnej prezentacji. Jeśli to nie idealne ostrzeżenie, to nie wiem, co może nim być

Na temat interaktywnego silnika sztucznej inteligencji Bard, który został stworzony przez firmę Google, rozpisywaliśmy się już w dniu jego zapowiedzi jako o konkurencji dla m.in. ChatGPT. Ma być wbudowany bezpośrednio w przeglądarkę, dzięki czemu wyszukanie danej frazy będzie podrzucać nam nie tylko te tradycyjne wyniki wyszukiwania (wyselekcjonowane głównie przez algorytmy SI właśnie), ale też te nowe, będące efektem wyszkolenia Barda na ogromnym zestawie danych. Google może w tej kwestii wyjść na prowadzenie na tle konkurencji, bo to przecież firma, która rozdaje karty w sieci jako najpopularniejsza przeglądarka.

Czytaj też: Zapamiętajcie ten dzień. Microsoft zapoczątkował dziś nową erę Internet

Zadaniem chatbota Bard, który na ten moment korzysta z uproszczonego silnika LaMDA (Language Model for Dialogue Applications) będzie analiza zadanego pytania oraz przygotowanie możliwie dokładnej odpowiedzi w języku naturalnym z wykorzystaniem gigantycznej wręcz bazy skatalogowanych informacji zgromadzonych przez Google. Tyle tylko, że podczas oficjalnej prezentacji pokazał, że w jego odpowiedzi nie ma co bezgranicznie wierzyć.

Jakiś czas po niedawnej prezentacji okazało się, że Bard sprzedał nam wierutnego fejka, wspominając w zestawieniu trzech ciekawostek na temat Kosmicznego Teleskopu Jamesa Webba, że to on właśnie odpowiada za zrobienie pierwszych zdjęć egzoplanet. Problem w tym, że pierwsze takie zdjęcie powstało już w 2004 roku, a ledwie miesiąc temu świat obiegła informacja o pierwszej egzoplanecie zaobserwowanej przez wspomniany teleskop. Wspominam o tym nie bez powodu, bo są szanse, że narzędzie firmy Google może więc mieć znacznie większy problem z tego typu informacjami. Taki, a nie inny wynik odpowiedzi Barda może być efektem świeżych treści na temat pierwszej egzoplanety zaobserwowanej przez wspomniany teleskop lub dziwną korelacją z samym czasem publikowanych informacji.

Czytaj też: Świat byłby bezpieczniejszy, gdyby nie Chiny. Po cichu wspierają inne kraje w dążeniu do nuklearnej zagłady

Pamiętajmy, że pod maską tych chatów kryją się ogromne zestawy danych, a że te do znalezienia w Google są albo dobrze ukryte pod clickbaitowymi tytułami z najważniejszą informacją ukrytą pod toną treści (w imię SEO), albo zwyczajnie fałszywe, Bard może mieć problem. Z czasem zapewne będzie nam dane dowiedzieć się, jak wielki ten problem jest, ale Google w tej akurat kwestii sam strzelił sobie w stopę, przyzwalając na i nawet promując tego typu treści.