Sztuczna inteligencja to zaawansowane programy komputerowe, które do działania wymagają ogromnej mocy obliczeniowej

Sztuczna inteligencja jest tak naprawdę realizowaną od dawna próbą symulacji ludzkiej inteligencji w maszynach. Wyróżnia się wiele jej odłamów, a na tę chwilę żadne jej zastosowanie nie jest na tyle zaawansowane, aby określić go mianem tego, do czego aktualnie się dąży, czyli do AGI (Artificial General Intelligence). Mowa o “prawdziwej sztucznej inteligencji”, zwanej też tą ogólną, o której będzie można wreszcie powiedzieć, że naśladuje ludzkie myślenie.

Czytaj też: Bing nie wie, który mamy rok i dostaje napadów szału. Sztuczna inteligencja potyka się o własne nogi

Na obecnym etapie rozwoju sztuczna inteligencja jest wykorzystywana najczęściej tylko w jednym specjalistycznym zadaniu (rozpoznawaniu twarzy, generowaniu transkrypcji, przeszukiwaniu ogromnych zbiorów danych). Termin ten odnosi się więc do programów komputerowych, które mogą wykonywać zadania wymagające zwykle ludzkiej inteligencji. Programy te bazują na algorytmach, a te najczęściej mogą przetwarzać duże ilości danych i uczyć się na ich podstawie, aby wreszcie podejmować decyzje w oparciu o wzorce i spostrzeżenia.

Algorytmy te nie są w żadnym razie “magią”, czy wiedzą tajemną. W praktyce to często algorytmy oparte na modelach matematycznych i analizie statystycznej, które ciągle się ulepszają. Dlatego też sztuczna inteligencja ma wiele praktycznych zastosowań i pewne jest, że w nadchodzących latach będzie miała coraz większy wpływ na szereg aspektów naszego codziennego życia. Nieważne, czy będziemy sobie zdawać z tego sprawę, czy wręcz przeciwnie.

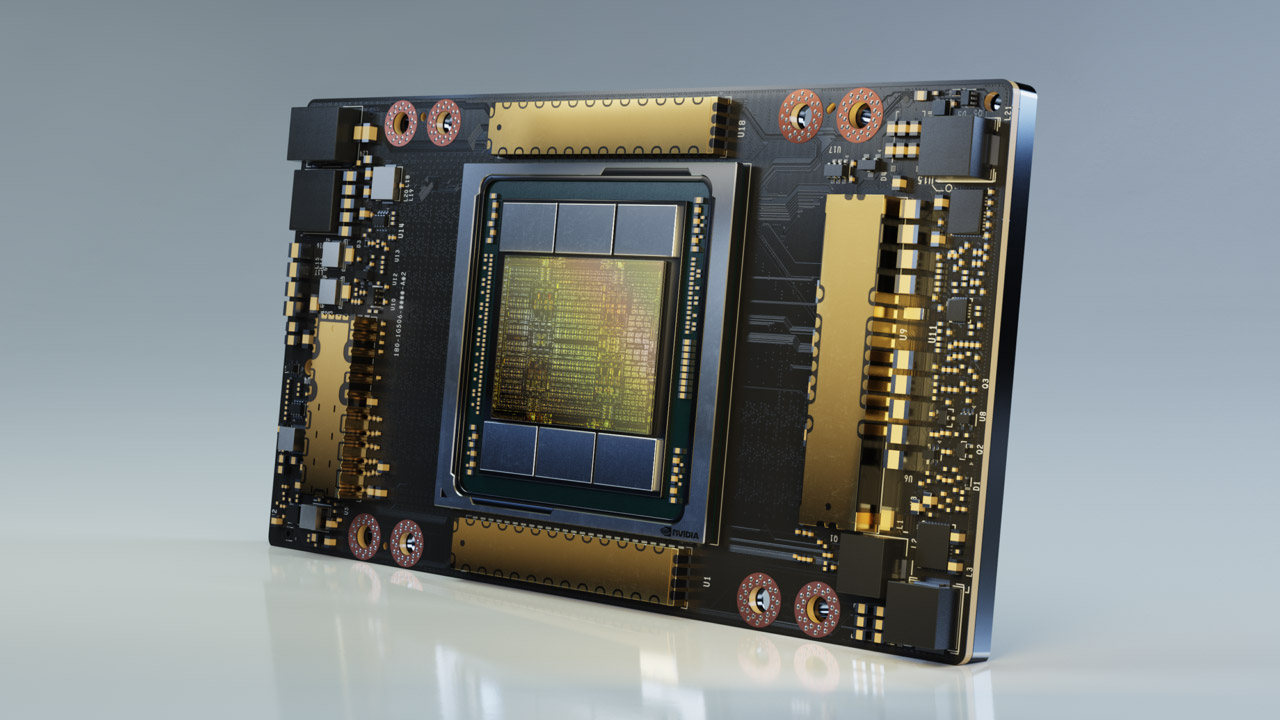

Tyle tylko, że im więcej od przeróżnych systemów sztucznej inteligencji wymagamy, tym ta musi mieć dostęp do zarówno okazalszych baz danych, jak i wydajniejszego sprzętu, żeby na tych danych operować. Przykładem takiego sprzętu jest kosztujący 10000 dolarów, czyli prawie 45000 zł wyspecjalizowany procesor A100 firmy Nvidia, który wykorzystuje podstawy architektury Ampere. Są duże szanse, że wpisując coś w nowego Binga, czy okienko ChatGPT, to właśnie A100 “zapewnia” wam pośrednio odpowiedź.

Czytaj też: Czego pragnie sztuczna inteligencja? Bing jest z nami od niedawna, a już ma dość ludzi

Tak przynajmniej wynika ze słów Nathana Benaicha, czyli inwestora, który stwierdził ostatnio, że układ A100 Nvidii stał się istną podstawą branży SI. Trudno się temu dziwić, bo firma panuje ponoć nad aż 95% rynku procesorów graficznych, które są wykorzystywane do uczenia maszynowego. Nadaje się zresztą idealnie do algorytmów, które wykorzystują wspomniane chaty lub generatory grafik.

W ofercie firmy Nvidia znajdują się dwa modele z rodziny A100. Różnica między nimi sprowadza się wyłącznie do interfejsu, bo oba akceleratory posiadają ten sam rdzeń graficzny GA100 i 40 GB pamięci HBM2e, ale są przeznaczone albo na SXM4, albo na PCIe 4.0. GA100 to obecnie największy procesor graficzny oparty na architekturze NVIDIA Ampere, który zawiera aż 54 miliardy tranzystorów na powierzchni krzemu o wielkości 826 mm kwadratowych. Przekłada się to na wydajność FP64 na poziomie 9,7 teraflopów dla rdzeni CUDA i 19,5 teraflopów dla wyspecjalizowanych pod kątem obliczeń SI rdzeni Tensor. To połączenie dopełnia pamięć HBM2e o przepustowości 460 GB/s, co zapewnia odpowiednio szybki transfer kluczowych dla SI danych z układu pamięci do procesora.

Czytaj też: Sztuczna inteligencja Google musi trenować przed premierą. Zgadnijcie, na kogo zrzucono to zadanie

Jeśli wierzyć analizie New Street Research, chat w wyszukiwarce Bing może wymagać ośmiu takich procesorów, aby udzielić odpowiedzi na pytanie poniżej sekundy. To z kolei ma oznaczać, że Microsoft potrzebuje ponad 20000 serwerów z 8 tego typu procesorami tylko po to, by udostępnić tę funkcję wyszukiwarki dla wszystkich. Jako że Nvidia sprzedaje akurat tego typu serwery (DGX A100) w cenie prawie 200000 dolarów, oznacza to, że ta wyjątkowa funkcja Microsoftu może kosztować nawet 4 miliardy dolarów. Taka oto jest cena “magii” stojącej za sztuczną inteligencją.