O ChatGPT napisano już wszędzie tyle razy, że widząc to słowo czuję się jak czytając o „5G” kilka lat temu. Wszyscy o nim mówią, wszyscy o nim piszą i niestety… nieprędko się to zmieni, bo OpenAI właśnie zaprezentowało ChatGPT-4, oparty o model językowy GPT-4. Jak sami mówią jego twórcy, w wielu rzeczywistych zastosowaniach ma on mniejsze możliwości niż człowiek, ale już dziś wykazuje zdolności na ludzkim poziomie w zastosowaniach profesjonalnych i testach akademickich.

I jeśli to, co czytamy w oficjalnym ogłoszeniu nowego modelu językowego jest prawdą, to… cóż. Świat nie będzie taki sam. Model GPT-4 jest od dziś dostępny (w ograniczonej formie) dla abonamentów ChatGPT Plus oraz partnerów korzystających z API od OpenAI. A jakby tego było mało, Microsoft właśnie potwierdził, że jego udostępniony dla wszystkich Bing również funkcjonuje w oparciu o nowy model GPT-4.

Czytaj też: Natychmiast zaktualizuj Microsoft Edge. Do przeglądarki trafiła sztuczna inteligencja i… AirDrop?

Co potrafi ChatGPT-4?

Nie pokuszę się tu o kompletną analizę wszystkich możliwości zaprezentowanych przez OpenAI, bo nie sposób zrobić to dobrze tuż po ogłoszeniu. Jestem przekonany, że w najbliższych dniach nowy model zostanie rozłożony na czynniki pierwsze przez kompetentnych ludzi i wówczas będziemy mogli mu się przyjrzeć bliżej.

Posiłkując się jednak oficjalnymi informacjami od OpenAI, GPT-4 ma być ledwie „niewielkim progresem” względem modelu GPT-3.5, z którego mogliśmy korzystać przez ostatnie miesiące. Trudno jednak nie odnieść wrażenia, że twórcy nieco niedoszacowują swoich osiągnięć, patrząc na wyniki nowego modelu w szeregu testów akademickich.

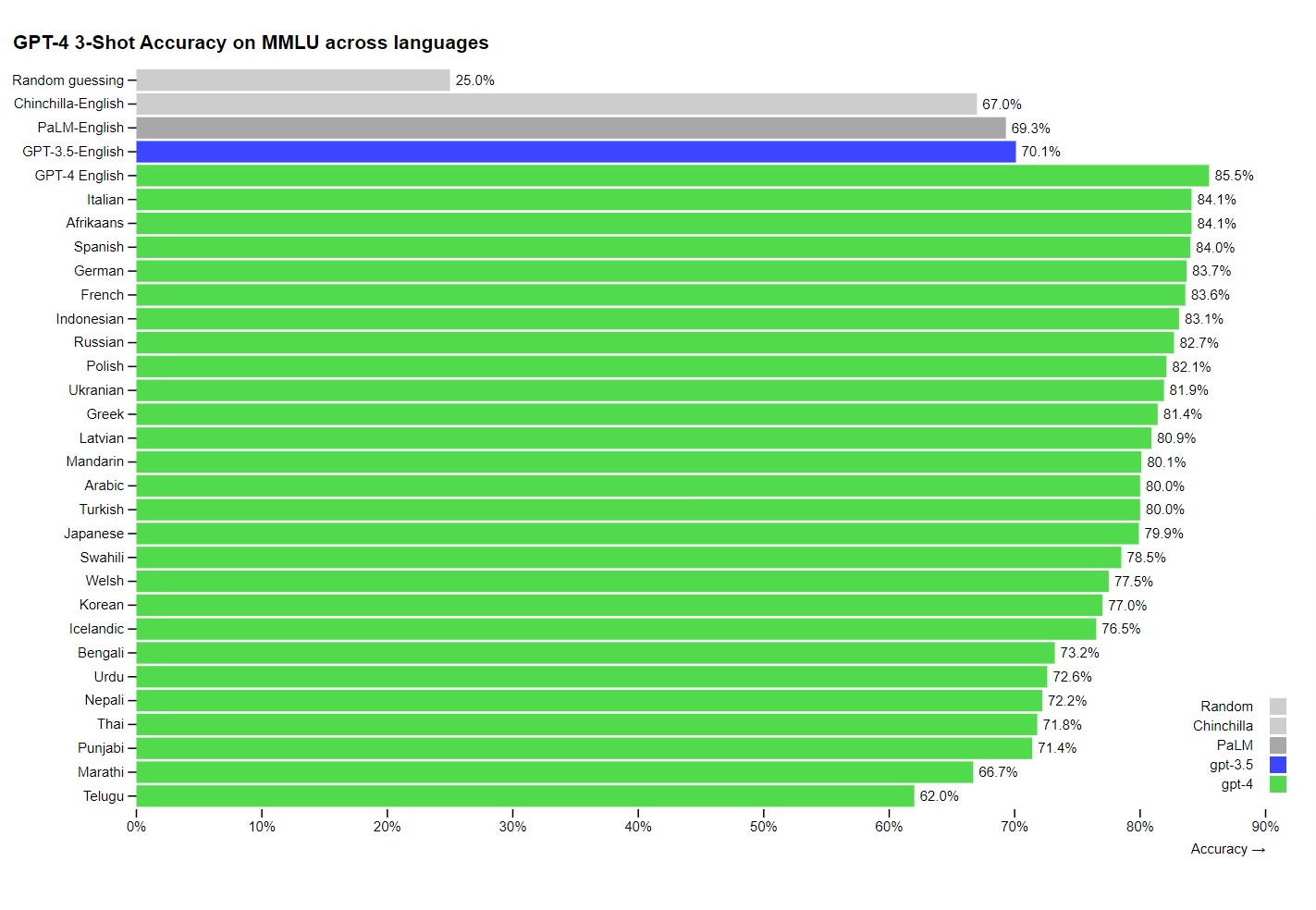

Podczas gdy model GPT-3.5 zaliczał tylko wybrane testy, a np. w egzaminie na prawo uzyskał wynik w dolnych 10% wszystkich przystępujących do egzaminu, tak GPT-4 w tym samym egzaminie uzyskał wynik na poziomie górnych 10%, a wystarczyło mu zaledwie 6 miesięcy intensywnego „treningu”. Jakby tego było mało, GPT-3.5 radził sobie najlepiej w testach w języku angielskim, a tymczasem GPT-4 wyprzedził poprzednią wersję w aż 24 na 26 testowanych języków, w tym polskim.

W codziennym zastosowaniu różnice między GPT-4 a GPT-3.5 mają być nieznaczne. Przede wszystkim GPT-4 ma sobie radzić z trudniejszymi zadaniami; oferuje on większą stabilność, kreatywność i lepsze rozpoznawanie niuansów w wypowiedzi. OpenAI chwali się, że dzięki wewnętrznemu rozwojowi języka radzi on sobie znacznie lepiej w zastosowaniach związanych ze wsparciem technicznym, sprzedażą, moderacją treści czy programowaniem. Czyli – nie oszukujmy się – z tymi obszarami, które dziś najbardziej interesują klientów. ChatGPT w nieodległej perspektywie czasu może zająć miejsce tych wszystkich pożal-się-boże chatbotów na stronach internetowych (patrzę na Ciebie, Max!), a też już dziś znajduje zastosowania w miejscach, które dotąd wymagały znajomości programowania. Jednym z zastosowań, z których sam ostatnio skorzystałem, jest implementacja ChatGPT w oprogramowaniu Reaper, gdzie pozwala tworzyć muzykom skrypty bez znajomości języka programowania. Tylko czekać, aż tego typu funkcje zostaną natywnie zaimplementowane w oprogramowaniu i pewne funkcje (np. akcje w Photoshopie, bo dlaczegóżby nie) użytkownicy będą mogli tworzyć samodzielnie. Cholerka, a wyobrażacie sobie potencjał tego rozwiązania przy tworzeniu modów do gier?

GPT-4 może też rozpoznawać nie tylko tekst, ale również i obraz. Innymi słowy, teraz będziemy mogli wkleić do ChatGPT zdjęcie i zapytać o nie sztuczną inteligencję – wyobraźcie sobie, jak duży potencjał drzemie w takim narzędziu np. w kwestii pomocy technicznej? Zamiast np. wpisywać kod błędu, który wyświetlił się na ekranie czy dyktować go przedstawicielowi pomocy technicznej, można będzie zrobić zdjęcie i zapytać AI, o co chodzi. A w przyszłości może – kto wie? – wystarczyć będzie zdjęcie uszkodzonego sprzętu, by sztuczna inteligencja od razu była w stanie zdiagnozować usterkę?

Czego nie potrafi GPT-4?

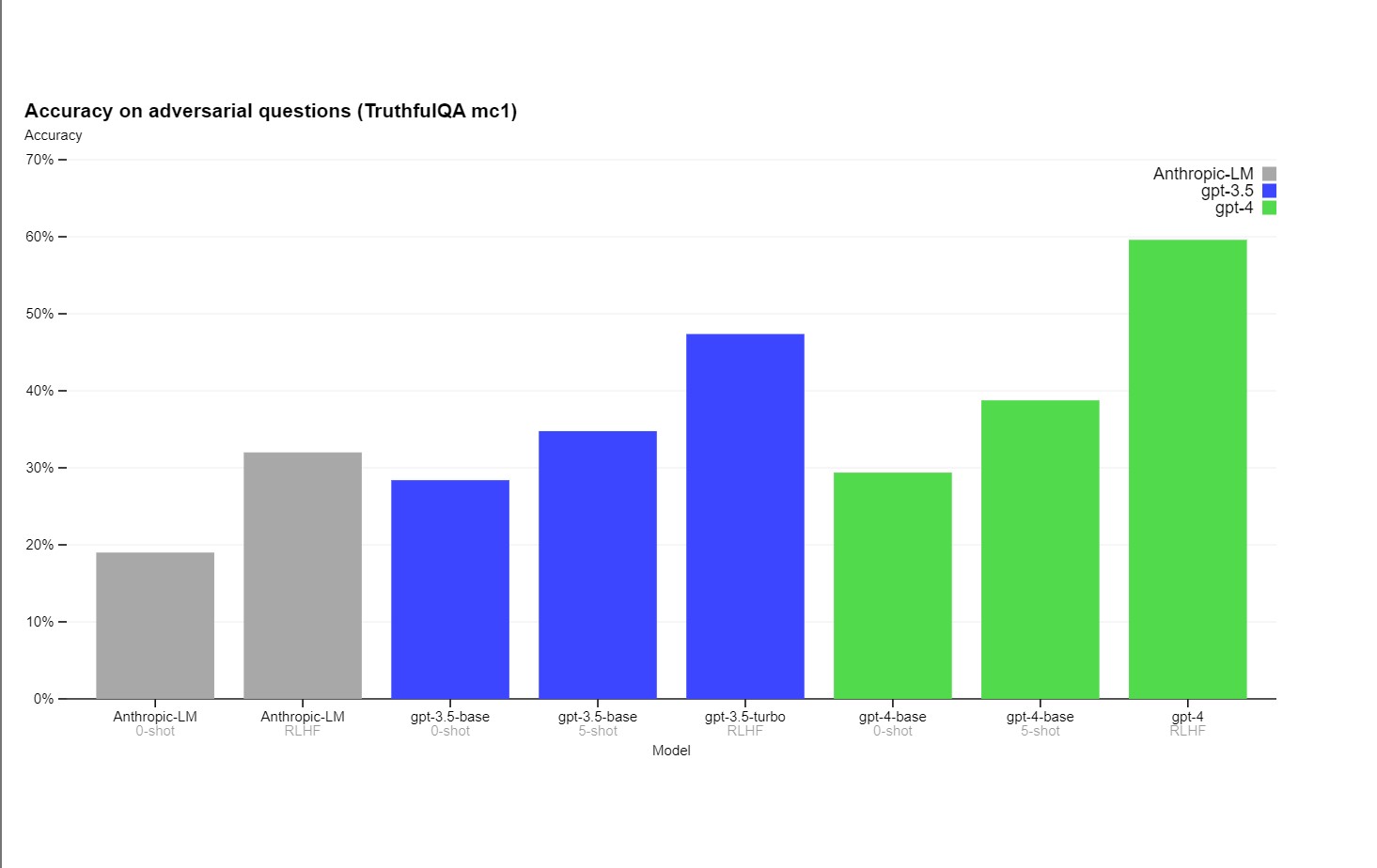

OpenAI nie owija w bawełnę i podkreśla, że GPT-4 nadal jest modelem wysoce niedoskonałym, wykazującym skłonności do „halucynacji”. Nowy model nadal potrafi też „iść w zaparte” i upierać się przy własnym błędzie, nawet jeśli zostanie skorygowany przez użytkownika. Zadbano jednak, aby GPT-4 lepiej radził sobie z odróżnianiem faktów od fałszywych informacji. Różnica względem modelu GPT-3.5 wynosi nieco ponad 10%, co wydaje się niewielkim postępem, ale w praktyce może się przekładać na znacznie większą wiarygodność narzędzia.

OpenAI przestrzega również, iż z uwagi na swoje większe możliwości GPT-4 nie tylko może udzielać szkodliwych porad, podawać niedokładne informacje czy generować błędy w kodzie, ale też udzielać informacji, które mogą wpaść w niepowołane ręce. Wpis firmy wyróżnia kilka obszarów, w tym cyberbezpieczeństwo, ryzyko skażenia biologicznego czy np. syntezy niebezpiecznych chemikaliów. ChatGPT-4 potrafi udzielać informacji na każdy z wyżej wymienionych tematów, toteż OpenAI skorzystało z pomocy przeszło 50 ekspertów z różnych dziedzin, aby takich odpowiedzi nie udzielał. Nie zmienia to jednak faktu, że OpenAI nadal dopuszcza sytuację, w której ktoś obejdzie zastosowane środki bezpieczeństwa i użyje AI do wygenerowania treści stojących w sprzeczności z wytycznymi. OpenAI ma niebawem opublikować więcej danych na temat tego, jak zamierza radzić sobie z potencjalnymi zagrożeniami, jakie niesie ze sobą GPT-4.

ChatGPT-4 potrafi jeszcze jedno – sprawił, że poczułem się zbyteczny

Ok, może nieco przesadzam; wiem, że zanim „sztuczna inteligencja zabierze nam pracę” miną jeszcze dłuuuugie lata, a też prawdopodobnie nie będzie tak, że nagle modele pokroju GPT-4 sprawią, że ludzie staną się niepotrzebni. Wprost przeciwnie – profesjonalistom w wielu dziedzinach takie narzędzia spadają z nieba, pozwalając na automatyzację żmudnych, powtarzalnych procesów i uwalniając dodatkowe zasoby twórcze w mózgu człowieka, które inaczej byłyby tłamszone przez szarość dnia codziennego.

Tym niemniej nie potrafię się otrząsnąć z przeczucia, że im głębiej będziemy się posuwać do wnętrza tej otchłani, jaką jest sztuczna inteligencja, tym trudniej będzie ludziom wykazać, że potrafią więcej niż robot. Dziś zobaczyliśmy GPT-4, a lada dzień ma też zadebiutować nowa, piąta już wersja Midjourney, czyli generatora obrazów. I jeśli faktycznie będzie ona potrafiła to, co wynika z zapowiedzi, to część fotografów już dziś może odwiesić aparat:

Patrzę teraz całościowo na to, na czym polega na przykład moja praca tutaj, którą na użytek tego tekstu mogę ogólnikowo streścić do kilku podpunktów:

- Szukanie tematów

- Wymyślanie tematów

- Redagowanie tekstu

- Pisanie tekstu

- Robienie zdjęć

Nie ukrywam, że już dziś sztuczna inteligencja może za mnie zrobić znakomitą większość tych zadań. Od miesiąca korzystam chociażby z Bing AI i już niejeden raz pytałem o tematy związane z XYZ. I nawet jeśli tylko 1 na 100 pomysłów okaże się dobry, to jest to pomysł, na który nie musiałem wpaść sam.

Z redagowaniem tekstu sztuczna inteligencja jeszcze radzi sobie średnio, ale nie oszukujmy się, to kwestia czasu i złożoności języka polskiego – gdy GPT-4 nauczy się wszystkich zmiennych, jakie występują w naszym języku, będzie mógł śmiało pełnić rolę redaktora, a już na pewno korektora treści pisanych przez człowieka. Nie mówiąc o tym, że już dziś ChatGPT mógłby zastąpić znakomitą większość mediaworkerów w polskich mediach…

A kiedy jeszcze generatory obrazu, jak wspomniany Midjourney, DALL-E lub Stable Diffusion wejdą na podobny poziom zaawansowania, co GPT-4 w przypadku generowania tekstu, to naprawdę niewiele będzie zadań, które będę w stanie wykonać lepiej od maszyny. Pewnie, w dalszym ciągu to ja jestem „dyrektorem kreatywnym” sterującym poczynaniami AI, ale na dobrą sprawę… podobne wytyczne mógłby robotom dać ktokolwiek inny.

Domyślam się, że mniej więcej to samo czują dziś twórcy wszystkich innych dziedzin kreatywnych. Pisarze? Już dziś książki pisane przez ChatGPT zalewają Amazona. Muzycy? Już dziś sztuczna inteligencja świetnie radzi sobie z tworzeniem muzyki, zwłaszcza elektronicznej. Graficy? Znakomita większość z nich może zostać bez pracy, jeśli generatywne AI będzie się rozwijało w takim tempie. Programiści? Wkrótce ich rola może zostać zmniejszona do „karmienia” SI. Przyjdzie sztuczna inteligencja i nas zje. i nikt nie ma pomysłu, co z tym zrobić.

To oczywiście najczarniejsze myśli z najczarniejszego scenariusza, ale trudno się od nich opędzić, podczas gdy na naszych oczach dokonuje się przełom za przełomem. Jedno jest pewne – przyszłość zapowiada się ekscytująco i przerażająco zarazem, a jeśli już macie dość kolejnych newsów na temat sztucznej inteligencji, to lepiej uzbrójcie się w cierpliwość: tego będzie coraz więcej.