Aby dobrze zrozumieć z czym właściwie mamy do czynienia, warto zacząć od pojęcia tzw. segmentacji obrazu. Tak bowiem określamy proces podziału obrazu na części (segmenty lub regiony) odpowiadające znajdującym się na nim obiektom. Jest to zarazem jeden z kluczowych elementów techniki rozpoznawania obrazu stosowany zarówno w analizie naukowej, jak i podczas typowej obróbki zdjęć w domowym zaciszu.

Stworzenie precyzyjnego modelu segmentacji wymagało dotychczas zaawansowanej wiedzy eksperckiej i solidnego zaplecza infrastrukturalnego do szkolenia sztucznej inteligencji, z użyciem prawidłowo dobranych danych treningowych. I właśnie tu do akcji wkracza Meta z projektem o nazwie Segment Anything, który ma rozszerzyć dostęp do tego typu rozwiązań. Efekt finalny stanowi nowy model o nazwie SAM (Segment Anything Model).

Model SAM od Meta – pokaż albo napisz co zaznaczyć

Model reaguje zarówno na kliknięcie danego rejonu przez użytkownika, jak i wprowadzenie opisu obiektu do wyizolowania z obrazu. Mówiąc wprost: automatycznie zaznaczy na obrazie wszystkie koty, jeśli go o to ładnie poprosimy. Poza samym modelem Meta oferuje również bazę, na którą składa się 11 milionów zdjęć pozyskanych na licencji od “dużej firmy zajmującej się fotografią” (możemy tylko spekulować, że chodzi o jakiegoś stocka).

W skład bazy danych SA-1B poza zdjęciami wchodzi również gigantyczny zestaw ponad 1,1 miliarda masek segmentacyjnych – to efekt pracy modelu SAM. Całość (model i dane treningowe) została udostępniona bezpłatnie do celów niekomercyjnych (na licencji Apache 2.0). To jeszcze nie koniec, bo każdy chętny może się pobawić wersją demonstracyjną na stronie projektu, zarówno korzystając z już załadowanych zdjęć, jak i przesyłając własne.

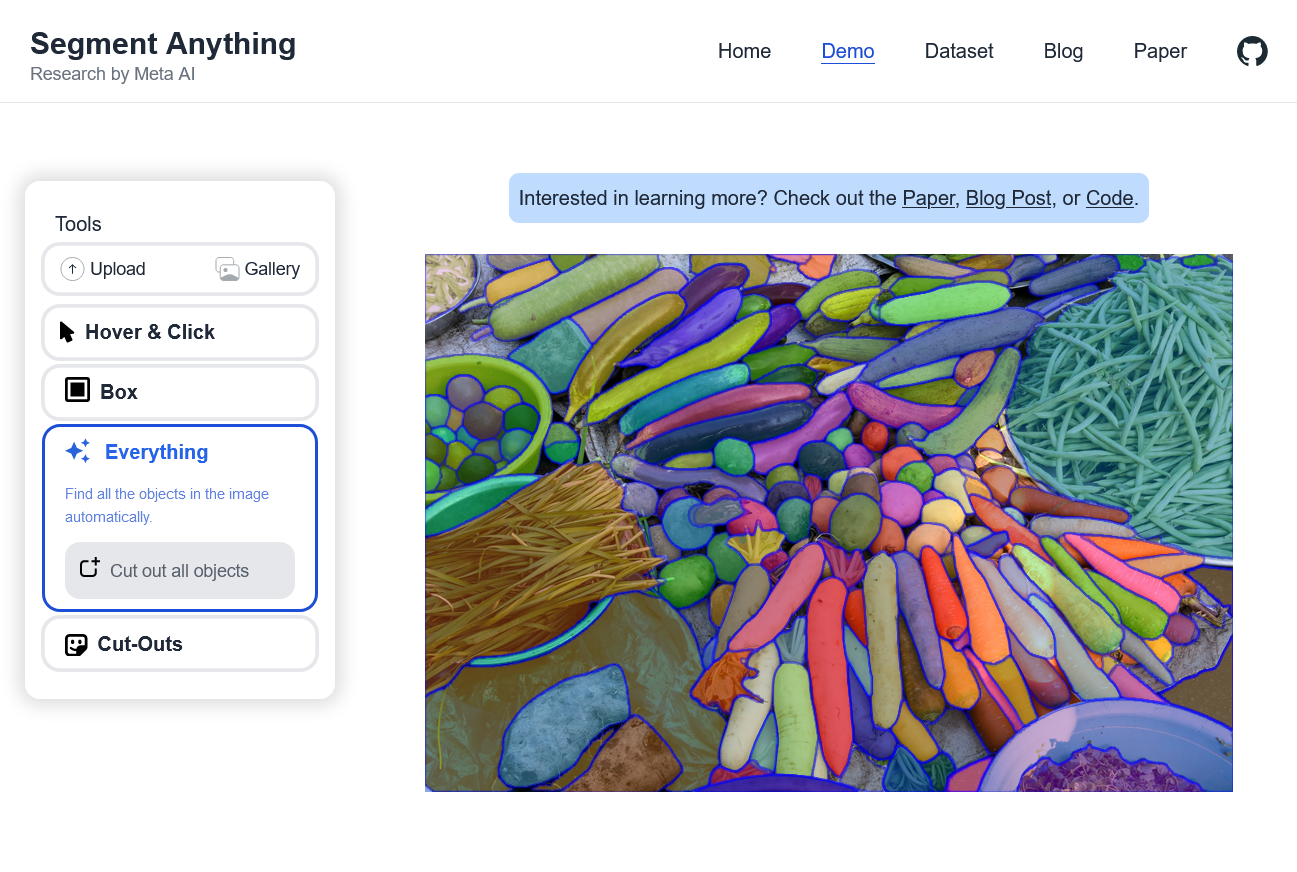

W wersji demonstracyjnej Segment Anything możemy pobawić się zaznaczaniem w jednym z trzech wariantów: Hover & Click (selekcja po najechaniu kursora myszki), Box (zaznaczenie obiektu przez narysowanie wokół niego prostokątnego zaznaczenia), a także Everything (automatyczne rozpoznawanie wszystkich obiektów na zdjęciu). Wygląda na to, że w tej wersji nie da się na razie sprawdzić wspomnianego zaznaczania na bazie wpisanego tekstu.

Czytaj też: Coraz więcej krajów przeciwko ChatGPT. Sztuczna inteligencja musi podlegać kontroli

Na uwagę zasługuje umiejętność izolowania przez model SAM obiektów, na które nie trafił dotychczas w swoich w danych treningowych. O ile sama segmentacja obrazu nie jest nową technologią, o tyle inicjatywa Meta może się przyczynić do popularyzacji tego typu narzędzi. W momencie wzmożonej walki z konkurencją warto docenić politykę otwartości Meta, która w przypadku modeli językowych z rodziny LLaMA zaczęła już przynosić pierwsze efekty w postaci pobocznych projektów branżowych.

A w przyszłości? Takie modele jak SAM mogą służyć do rozpoznawania otoczenia przez okulary rozszerzonej rzeczywistości (AR), dając użytkownikom szereg dodatkowych informacji. Jeśli mamy kiedykolwiek dożyć ery autonomicznych pojazdów, trudno będzie wyobrazić sobie poruszanie się po mieście bez dobrze działającej segmentacji obrazu (rozpoznawania przeszkód, innych pojazdów, elementów otoczenia, etc.).

W mikroskali zajawkę technologii segmentacji w swoim otoczeniu możecie znaleźć podczas zabawy ze zdjęciami w iPhonie. Wystarczy nacisnąć dłużej obiekt na zdjęciu, a po chwili będzie można go przenieść (bez otaczającego tła), np. do wiadomości na Messengerze. Oczywiście, nie działa to jeszcze tak kompleksowo, ale już teraz widać, w którą stronę będzie zmierzać.