Gdy zapytamy ChatGPT o dowolny temat, najczęściej będzie on miał dość ogólną, ale opierającą się na merytorycznych założeniach, odpowiedź. No chyba, że spytamy się go o to, skąd czerpie informacje na temat interesującego nas zagadnienia. OpenAI w swoim modelu syntezującym wiedzę z różnych dziedzin nie zaimplementowało narzędzi, które pozwoliłyby zweryfikować, z jakich bibliotek korzystał czat.

Odpowiedź, że są to dane z mediów społecznościowych, artykułów naukowych czy stron Wikipedii wydaje się być oczywista. Nie pociągniemy jednak modelu za język, by podzielił się linkiem do szczegółowego przedstawienia biblioteki danych. Co gorsza, trudno znaleźć taką informację na stronach OpenAI. Wiemy tyle, że od 1 marca OpenAI nie ulepsza modeli GPT w oparciu o informacje wgrane do API przez innych użytkowników. Uczy się za to między innymi w oparciu o interakcje z nami. To otwiera pole do nadużyć.

Coraz więcej krajów przygląda się ChatGPT-4… ale nie Polska

Nie tak dawno Sebastian pisał o zagrożeniu, jakie model GPT-4 niesie dla bezpieczeństwa publicznego. Tak naprawdę nie wiemy, co dzieje się z danymi wprowadzanymi do sieci OpenAI poza tym, że te są przez ChatGPT przetwarzane celem jego udoskonalenia. Wiemy za to, że przy odpowiedniej manipulacji faktami model sztucznej inteligencji możemy zmusić do tego, by stworzył kod dla złośliwego oprogramowania czy odpowiadał bez poszanowania dla rasy, pochodzenia czy przynależności politycznej.

Ostatnio włoski urząd do spraw ochrony danych osobowych (GPDP – Garante per la protezione dei dati personali) pokazał, że Chat GPT może być zagrożeniem dla prywatnych danych użytkowników. W wyniku wycieku danych z 20 marca złamano zabezpieczenia dotyczące zarówno płatności, jak i treści konwersacji, jakie użytkownicy prowadzili z ChatGPT. W rezultacie we Włoszech nie skorzystamy z ChatGPT. Wpływ na taki obrót spraw miał też zapewne fakt, że OpenAI przetwarza swoje dane na serwach w Stanach Zjednoczonych.

Okazuje się, że Włosi nie są jedyną nacją, która wyraża niepokój wobec AI. Podobne obawy wobec ChatGPT wyraził niemiecki komisarz do spraw ochrony danych, Urlich Kelber. W wywiadzie dla Handelsblatt zwraca on uwagę, że Niemcy mogą przejść ten sam proces decyzyjny co Włochy i tamtejsi urzędnicy skontaktowali się z włoskim urzędem do spraw ochrony danych osobowych. Śledztwo w sprawie naruszeń OpenAI wszczęła również Kanada – urząd federalnego komisarza ds. prywatności zareagował na skargę dotyczącą zbierania i wykorzystywania danych użytkowników bez ich zgody.

W opozycji do tych decyzji stoimy… my. Według rozmów Rzeczpospolitej z Urzędem Ochrony Danych Osobowych, na ChatGPT nie wpłynęła żadna skarga od firmy czy osoby prywatnej. UODO nie prowadzi też żadnego postępowania w sprawie produktu OpenAI.

Zagrożenia wynikające z nieszczelności infrastruktury OpenAI mogą stać się przyczynkiem do szerszej dyskusji na temat tego, w jaki sposób powinny działać podobne narzędzia. Rozsądnym wydaje się podejście, w którym jesteśmy w stanie prześledzić “proces myślowy” i dotrzeć do źródła wiedzy oraz do wnioskowania, z jakiego skorzystał generatywny model językowy, ale też i każdy inny, który zakłada interakcję z człowiekiem.

Naukowcy pracują nad takim rozwiązaniem. Uczeni z Uniwersytetu Surrey w Wielkiej Brytanii stworzyli oprogramowanie, które weryfikuje to, jak wiele nauczył się model sztucznej inteligencji. Co może okazać się ważne dla przyszłych regulacji, oprogramowanie rozpoznaje, czy rozwiązania oparte o sztuczną inteligencję zidentyfikowało lukę w kodzie innego oprogramowania. Przykładowo, dla sieciowego klienta pokera oprogramowanie było w stanie ocenić, czy wygrywająca partię za partią sztuczna inteligencja oszukiwała, czy jedynie w mistrzowski sposób opanowała zasady rozgrywki.

W obecnej formie działa to w oparciu o bazę danych, którą naukowcy szczegółowo opisali i sami wcześniej stworzyli. Z pewnością dalsza nauka rozumowania sztucznej inteligencji mogłaby pozwolić na tworzenie modeli śledzących i wnioskujących w oparciu o powszechnie dostępną wiedzę. Brzmi to jak rozwiązywanie problemu od końca? Poniekąd tak. Mam jednak nieodparte wrażenie, że każdy kawałek oprogramowania, który pozwoli skontrolować, co dzieje się w AI, będzie na wagę złota.

Sztuczna inteligencja musi być objęta prawem z krwi i kości – także po to, by nie zniknąć z rynku

Skoro na sile zyskują propozycje nowych zastosowań dla sztucznej inteligencji, nie dziwi też, że więcej uwagi poświęca się krytyce tego, co niesie ze sobą wprowadzanie nowych narzędzi. W ostatnich dniach głośny stał się list ze strony Future of Life Institute, którego sygnatariusze pragną wstrzymania rozwoju nad modelami językowymi o większej mocy niż ChatGPT-4. W treści możemy przeczytać między innymi, że:

[…] Zaawansowane AI może stać się przyczynkiem do gruntowej zmiany w historii Ziemi i powinno być opracowywane oraz zarządzane współmierną troską i wykorzystaniem zasobów. Niestety, nie dochodzi do takiego poziomu planowania i zarządzania, pomimo iż w ostatnich miesiącach laboratoria AI skupiły się na wyścigu poza kontrolą, by stworzyć i zaimplementować potężniejsze cyfrowe umysły, których nikt – nawet ich twórcy – nie mogą zrozumieć, przewidzieć lub kontrolować z pełnym zaufaniem.

Z związku z całą argumentacją listu dostępną na tej stronie Pause Giant AI Experiments: An Open Letter – Future of Life Institute jego autorzy postulują wstrzymanie prac nad generatywnymi modelami językowymi na okres 6 miesięcy. Wśród osób podpisanych pod tymi słowami jest między innymi Elon Musk, któremu w 2018 roku nie udało się przejąć OpenAI.

Nie jest to jedyny głos krytyczny wobec obecnej sytuacji. Swój niepokój wyraża też Europejska Organizacja Konsumentów (BEUC), która apeluje do Unii Europejskiej oraz organizacji rządowych, by rozpoczęły śledztwa w sprawie ChatGPT oraz podobnych chatbotów. Głos BEUC w tej sprawie podniósł się kilka dni po tym, jak skargę na OpenAI do Federalnej Komisji Handlu (FTC) w Stanach Zjednoczonych wniosło Center for AI and Digital Policy (CAIDP). Firmę oskarżono o naruszenie artykułu 5. uchwały FTC zakazującego nieuczciwych i zwodniczych praktyk biznesowych.

Czytaj też: Sztuczna inteligencja albo nas zbawi, albo zabije. Mam tyle samo nadziei, co obaw

Tak duża ofensywa skierowana konkretnie przeciwko chatbotom pokroju ChatGPT to pokłosie medialnego sukcesu, jaki osiągnęło OpenAI. Jak każde narzędzie oparte o sztuczną inteligencję, ChatGPT-4 niesie ze sobą zagrożenia, ale i szanse. Odnoszę przy tym wrażenie, że z chatbota próbuje zrobić się języczek u wagi, podczas gdy to inne zastosowania sztucznej inteligencji wymagają pilniejszej interwencji.

Nie tak dawno świat ujrzał w akcji Midjourney w wersji piątej. Nowa sieć pozwalająca na tworzenie grafik na bazie tekstu oferuje wysoki poziom szczegółowości przygotowanych grafik. Ponadto coraz lepiej radzi sobie z problemami, które trapią podobne modele, jak chociażby odwzorowanie dłoni. Od premiery poprzedniej wersji minęły nieco ponad cztery miesiące, a efekty są na tyle dobre, by przebijały się do popkultury jako memy, a w skrajnych wypadkach nabierały nieświadome osoby na Twitterze.

O ile w przypadku obrazków nasze wyczulenie na fałsz może być większe, to w przypadku muzyki nasz aparat poznawczy jest wystawiony na jeszcze cięższą próbę. Wystarczy zaprezentować przykład utworu, w którym niby występuje Jay-Z, a jednak nie musiał nagrywać nic nowego. Granica pomiędzy tym, co prawdziwe, a co zostało sztucznie wytworzone, zaciera się. Co więcej, znacznej części osób te niuanse wcale nie muszą obchodzić – doskonale rozumiem, że niektórzy po prostu lubią czyjś głos i chętnie usłyszą go w nowej aranżacji.

Z pewnością obchodzą one jednak wytwórnie muzyczne. W końcu to na pracy artystów w nich zrzeszonych mogą zarabiać osoby, które zaprzęgną próbkę głosu do modeli AI generujących nowe utwory ze znanymi głosami. Universal Music już wykorzystało narzędzia moderujące YouTube, by zdjąć z platformy wideo użytkownika Grandayy. Ten zaprzągł rozwiązania sztucznej inteligencji do stworzenia cyfrowej kopii głosu Eminema, a następnie wykorzystania go do tworzenia nowych kompozycji.

Znając zaciekłość prawników z branży muzycznej, nie skończy się na pojedynczym zgłoszeniu i z pewnością artyści wykorzystujący treści wygenerowane z użyciem sztucznej inteligencji będą musieli liczyć się z kontrą. Obecnie brakuje regulacji, które zezwalałyby na wykorzystanie zmodyfikowanego głosu w ramach chociażby licencji na synchronizację, jak robią to np. artyści nagrywający covery cudzych utworów. Jednocześnie obecność artysty w danym utworze czy gościnnie na danej płycie to ważny element budowania wizerunku scenicznego i wątpię, by za (niewielką) opłatą wytwórnie tak łatwo pozwalały na dzielenie się głosami artystów.

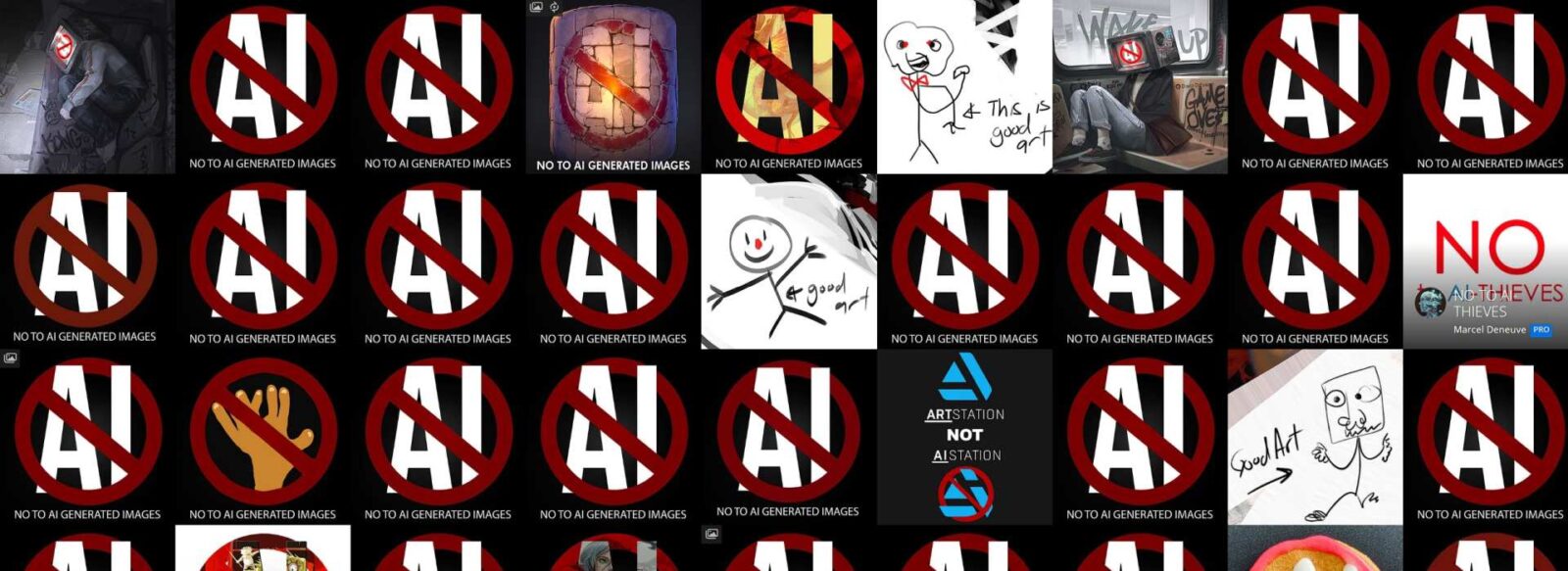

Ofensywa prawna czeka także rozwiązania przetwarzające obrazy. Getty Images pozwało Stability AI za bezprawne wykorzystanie zdjęć z ich bazy do nauczania Stable Diffusion, które napędza rozwiązania pokroju MidJourney. Użytkownicy ArtStation wyrazili głośny sprzeciw wobec pojawiania się zawartości generowanej przez sztuczną inteligencję pomiędzy ich pracami. Podobne akcje możemy mnożyć, ale clou każdej z nich pozostaje takie samo – powinniśmy oddzielać pracę wykonaną przez ludzi od tej, która została stworzona przez AI.

Musimy wytworzyć pewne zasady, w ramach których ludzka praca będzie odróżniana od tego, co osiągnięto dzięki modelom sztucznej inteligencji. Szansę na takie podejście do sprawy dają prace Komisji Europejskiej, która tworzy akt o sztucznej inteligencji. Co prawda w obecnej sytuacji projekt skupia się przede wszystkim na tym, gdzie wolno, a gdzie nie wolno korzystać z narzędzi opartych o sztuczną inteligencję, ale otwiera też drogę do debaty nad wpływem modeli generatywnych na prawa pracowników. Jedno jest pewne – rozwój generatywnej sztucznej inteligencji jest na tyle szybki, że odpowiedź powinna być stanowcza.