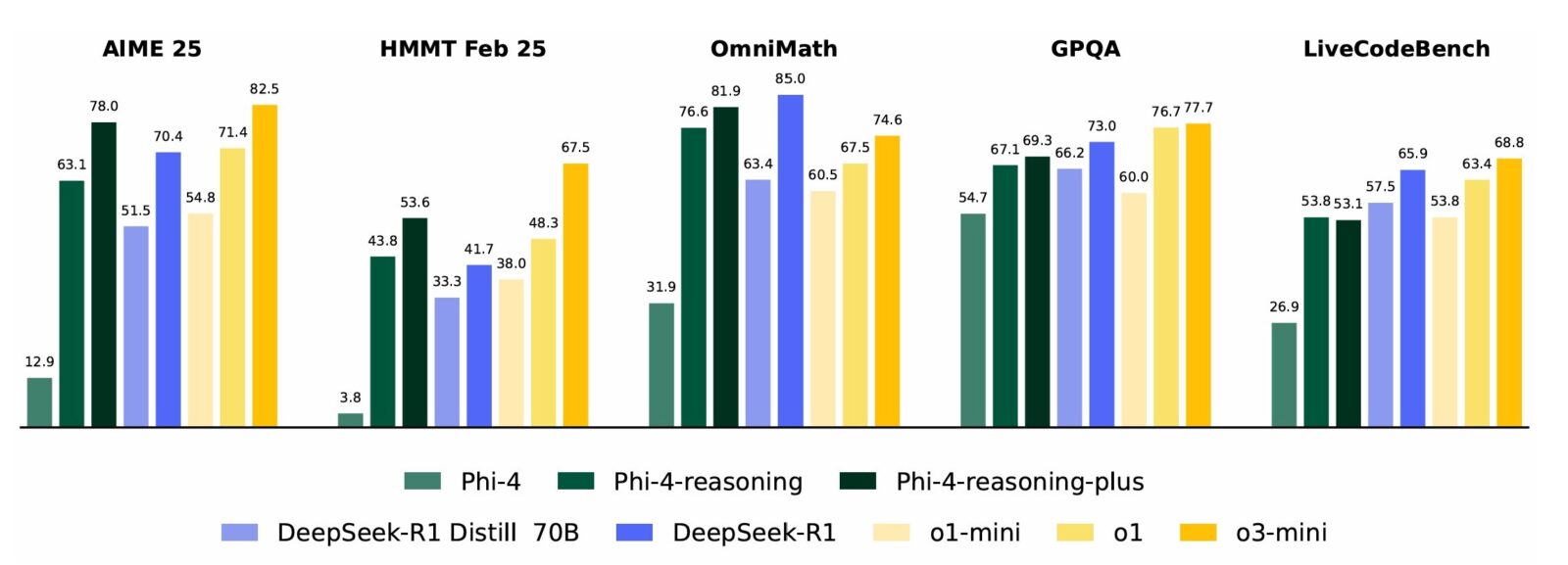

Według Microsoftu, te nowe modele Phi-4-reasoning przewyższają kilka większych modeli open-weight, takich jak DeepSeek-R1-Distill-Llama-70B, a nawet dorównują poziomom wydajności pełnego modelu DeepSeek-R1 w niektórych testach porównawczych. Mówi się również, że przewyższają modele Claude 3.7 Sonnet firmy Anthropic i modele Gemini 2 Flash Thinking firmy Google we wszystkich zadaniach z wyjątkiem GPQA i Calendar Planning.

Co potrafi Phi-4?

Imponująca, deklarowana wydajność rozumowania Phi-4 wskazuje, że staranna selekcja danych na potrzeby nadzorowanego dostrajania (SFT) jest skuteczna w przypadku modeli języka rozumowania, a wydajność można jeszcze bardziej poprawić, stosując uczenie przez wzmacnianie (RL).

Phi-4-reasoning ma również kilka ograniczeń. Po pierwsze, działa głównie z tekstem angielskim. Po drugie, jest głównie trenowany w Pythonie przy użyciu popularnych pakietów kodowania. Po trzecie, ma długość kontekstu wynoszącą zaledwie 32 tys. tokenów. Dodatkowe ograniczenia można znaleźć w dokumencie technicznym. Microsoft stwierdził, że te nowe modele Phi-4-reasoning zostały zaprojektowane w celu przyspieszenia badań nad modelami językowymi. Oczekuje się, że będą przydatne do opracowywania aplikacji AI w środowiskach o ograniczonej pamięci lub mocy obliczeniowej, scenariuszach ograniczonych opóźnieniem i zadaniach wymagających intensywnego rozumowania.

Czytaj też: Przeogromne ambicje. Chiński gigant nie ma zamiaru przystawać na samochodach