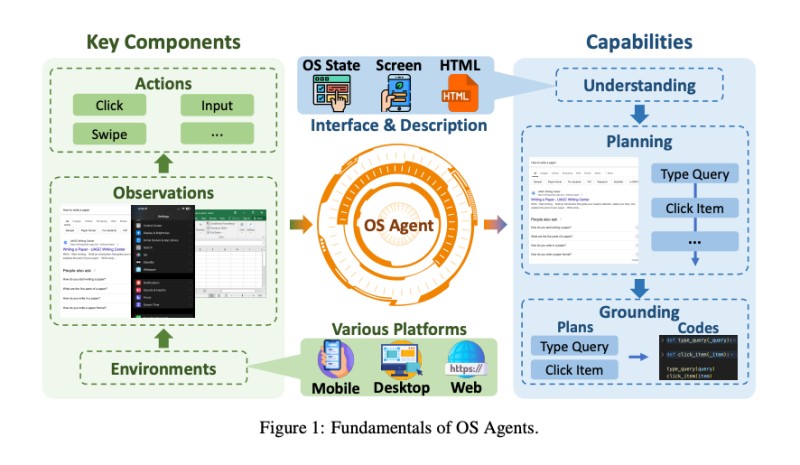

To już nie tylko generowanie tekstów czy obrazów. Najnowsze rozwiązania potrafią samodzielnie nawigować po interfejsach, klikać przyciski i wykonywać złożone operacje na komputerach czy smartfonach. Mechanizm działania przypomina ludzkie zachowania – system wykonuje zrzuty ekranu, analizuje je za pomocą zaawansowanego widzenia komputerowego, po czym podejmuje precyzyjne decyzje o kolejnych krokach. Ta zdolność do planowania wieloetapowych zadań i tłumaczenia ich na konkretne akcje stanowi prawdziwy przełom.

Tempo rozwoju jest imponujące. Od 2023 roku pojawiło się ponad 60 nowych modeli bazowych i 50 specjalnych struktur programistycznych dedykowanych właśnie kontroli komputerów. To nie są już akademickie eksperymenty, ale technologie szybko znajdujące drogę do komercyjnych zastosowań.

Najwięksi gracze technologiczni nie pozostają obojętni. OpenAI pracuje nad “Operatorem”, Anthropic wprowadziło funkcję “computer use”, Apple rozbudowuje możliwości w “Apple Intelligence”, a Google testuje “Project Mariner”. Szczególnie przełomowe okazało się wdrożenie przez Anthropic funkcji kontroli komputera w modelu Claude 3.5 Sonnet, co pozwala AI na interakcję z urządzeniami niemal jak człowiek – przez analizę ekranu, poruszanie kursorem i wprowadzanie danych.

Skuteczność nowego rozwiązania robi wrażenie. W testach dotyczących kodowania Claude 3.5 Sonnet poprawił swoje wyniki z 33,4% do 49,0% na benchmarku SWE-bench Verified, wyprzedzając wszystkie publicznie dostępne modele. Jeszcze wyraźniejszą przewagę widać w testach OSWorld, gdzie system osiągnął 14,9% skuteczności przy użyciu wyłącznie zrzutów ekranu, podczas gdy konkurencyjne rozwiązania uzyskiwały jedynie 7,8%.

Kolejnym aspektem wartym uwagi jest praktyczne zastosowanie tej technologii. Firmy takie jak Asana, Canva, DoorDash, Replit czy The Browser Company już eksperymentują z automatyzacją złożonych procesów wymagających dziesiątek, a czasem setek operacji. Choć obietnica wzrostu produktywności brzmi kusząco, niesie ze sobą poważne wyzwania.

Czy AI sterujące komputerem i telefonem jest bezpieczne?

Przechodząc do kwestii bezpieczeństwa, pojawiają się zasadnicze pytania. Agentowe AI tworzy zupełnie nową kategorię zagrożeń, na które tradycyjne systemy ochrony nie są przygotowane. Szczególnie niepokojące są nowe typy ataków, takie jak “Web Indirect Prompt Injection”, gdzie ukryte instrukcje na stronach mogą przejąć kontrolę nad agentem AI. Jeszcze groźniejsze wydają się “environmental injection attacks”, w których pozornie nieszkodliwe treści mogą nakłonić agenta do kradzieży danych czy nieautoryzowanych działań.

Problem polega na tym, że obecne zabezpieczenia powstały z myślą o ludzkich użytkownikach, którzy potrafią rozpoznać próby oszustwa. Tymczasem systemy AI przetwarzają informacje zupełnie inaczej, co stwarza nieznane dotąd ryzyko. Agent z dostępem do firmowej poczty, systemów finansowych czy baz danych klientów może zostać zmanipulowany przez specjalnie spreparowaną stronę internetową.

Warto odnotować, że Anthropic podejmuje próby odpowiedzi na te zagrożenia, rozwijając nowe klasyfikatory do wykrywania spamu, dezinformacji czy oszustw. Model Claude 3.5 Sonnet przeszedł wspólne testy z amerykańskim i brytyjskim instytutem bezpieczeństwa AI, choć badania nad specyficznymi zabezpieczeniami dla OS Agents wciąż pozostają ograniczone.

Równie istotne są obecne ograniczenia technologiczne. Analiza różnych benchmarków pokazuje wyraźny wzór: systemy doskonale radzą sobie z prostymi, dobrze określonymi zadaniami, ale napotykają trudności przy operacjach wymagających elastycznego myślenia i adaptacji do nieprzewidzianych zmian. Mogą bezbłędnie kliknąć określony przycisk czy wypełnić standardowy formularz, ale gubią się, gdy sytuacja wymaga improwizacji lub głębszego rozumienia kontekstu.

Co możemy zrobić, żeby czuć się bezpiecznie z agentowym AI?

Patrząc w przyszłość, kluczowym wyzwaniem będzie personalizacja i zdolność do ewolucji. W przeciwieństwie do obecnych, statycznych asystentów, przyszłe agenty będą musiały uczyć się z interakcji z użytkownikiem i dostosowywać do indywidualnych preferencji. Wyobraźmy sobie system, który poznaje nasz styl pisania maili, rozumie preferencje kalendarzowe i zna ulubione restauracje – mógłby podejmować coraz bardziej złożone decyzje. Potencjał wzrostu efektywności jest ogromny, ale rodzi to fundamentalne pytania o granice prywatności.

Istotną kwestią techniczną pozostaje rozwój wielomodalnych systemów pamięci, obsługujących nie tylko tekst, ale także obrazy i dźwięk. Jak stworzyć mechanizm zapamiętujący preferencje użytkownika bez inwigilacji jego cyfrowego życia? To dylemat, który zdefiniuje przyszłość całej branży.

Czytaj też: AI Google może uprzykrzyć nam życie. Wystarczy zaproszenie do kalendarza

Technologia systemowych agentów AI wciąż jest w powijakach, ale tempo jej rozwoju sugeruje, że zmiana sposobu interakcji z komputerami jest nieunikniona. Pytanie nie brzmi, czy do tego dojdzie, lecz czy jako społeczeństwo jesteśmy przygotowani na konsekwencje tej transformacji – zarówno te korzystne, jak i potencjalnie problematyczne. Osobiście uważam, że potrzebujemy poważnej dyskusji o etyce i bezpieczeństwie, zanim ta technologia na dobre zagości w naszych urządzeniach.