„Zapytaj Mapy” jako główny punkt startowy nowej wersji Map Google

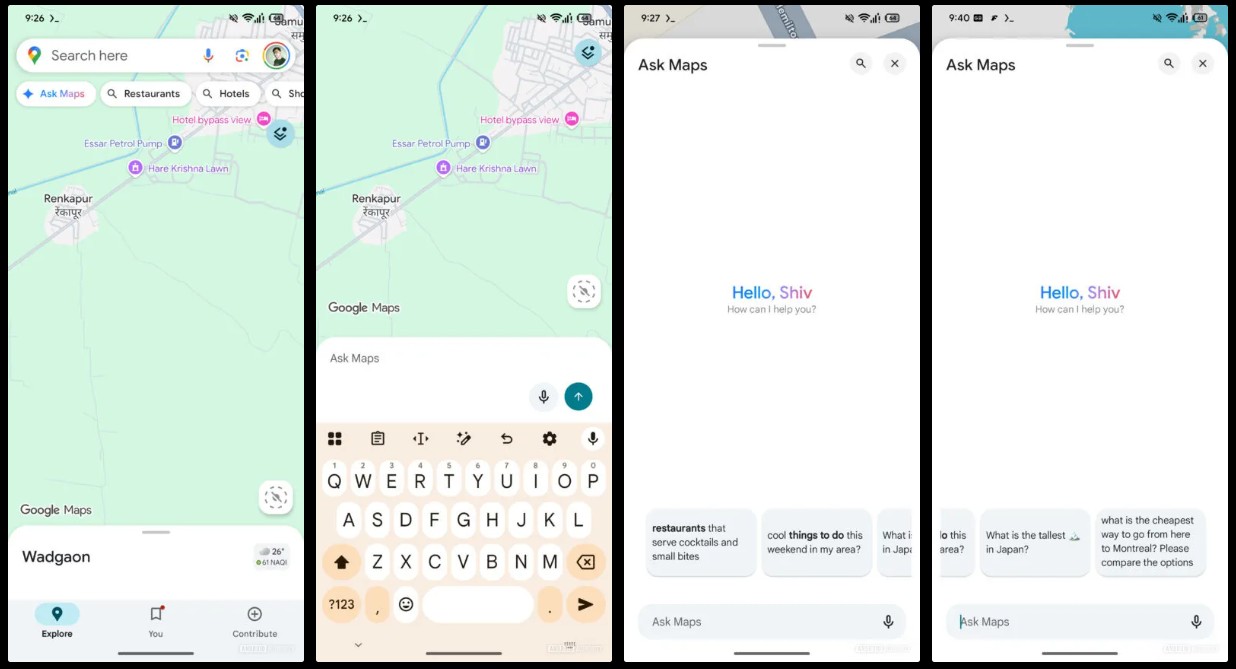

Gigant z Mountain View już jakiś czas temu zaimplementował możliwość znajdowania miejsc za pomocą złożonych zapytań tekstowych, takich jak “Gdzie zjeść kolację, która serwuje wegańskie burgery i ma ogródek, ale jest otwarta po 22:00?”. Teraz ta funkcjonalność ma być znacznie łatwiej dostępna i, co ciekawe, zyska zupełnie nowy interfejs. Dzięki analizie kodu beta wersji 25.41.03.815390258 aplikacji Map Google, odkryto plany dodania nowej kontrolki — chipu „Zapytaj Mapy” — który wyląduje tuż pod paskiem wyszukiwania. Ma on być pierwszą rzeczą, którą zobaczymy w aplikacji, siedząc przed standardową sekcją z kategoriami takimi jak „Restauracje”.

Po stuknięciu w ten chip naszym oczom ukaże się wysuwany od dołu ekran, a po jego przeciągnięciu w górę, zobaczymy interfejs, który jest niemal kalką z aplikacji Gemini. Na dole znajdzie się pole tekstowe z ikoną do wprowadzania głosowego oraz karuzela sugestii, które wyglądają jak typowe przykłady promptów dla AI, np. „restauracje, które serwują koktajle i małe przekąski” czy „fajne rzeczy do roboty w ten weekend w mojej okolicy”. To jasno pokazuje, że Google stawia na interakcję z Mapami za pomocą rozmowy, a nie tradycyjnych słów kluczowych.

Czytaj też: Luka w Gemini pozwala na wysyłanie prywatnych danych obcym. Google o tym wie i tylko wzrusza ramionami

To jest duży krok, który przenosi Zapytaj Mapy z ukrytej funkcji wewnątrz paska wyszukiwania na ekran główny aplikacji. Użytkownicy nie będą musieli zgadywać, czy AI zadziała, lecz zostaną wręcz zachęceni do zadawania pytań w bardziej kontekstowy i swobodny sposób. W zasadzie, Google zmusza nas do tego, by zacząć rozmawiać z mapą.

AI na Mapach Google ma jeszcze wiele do zrobienia

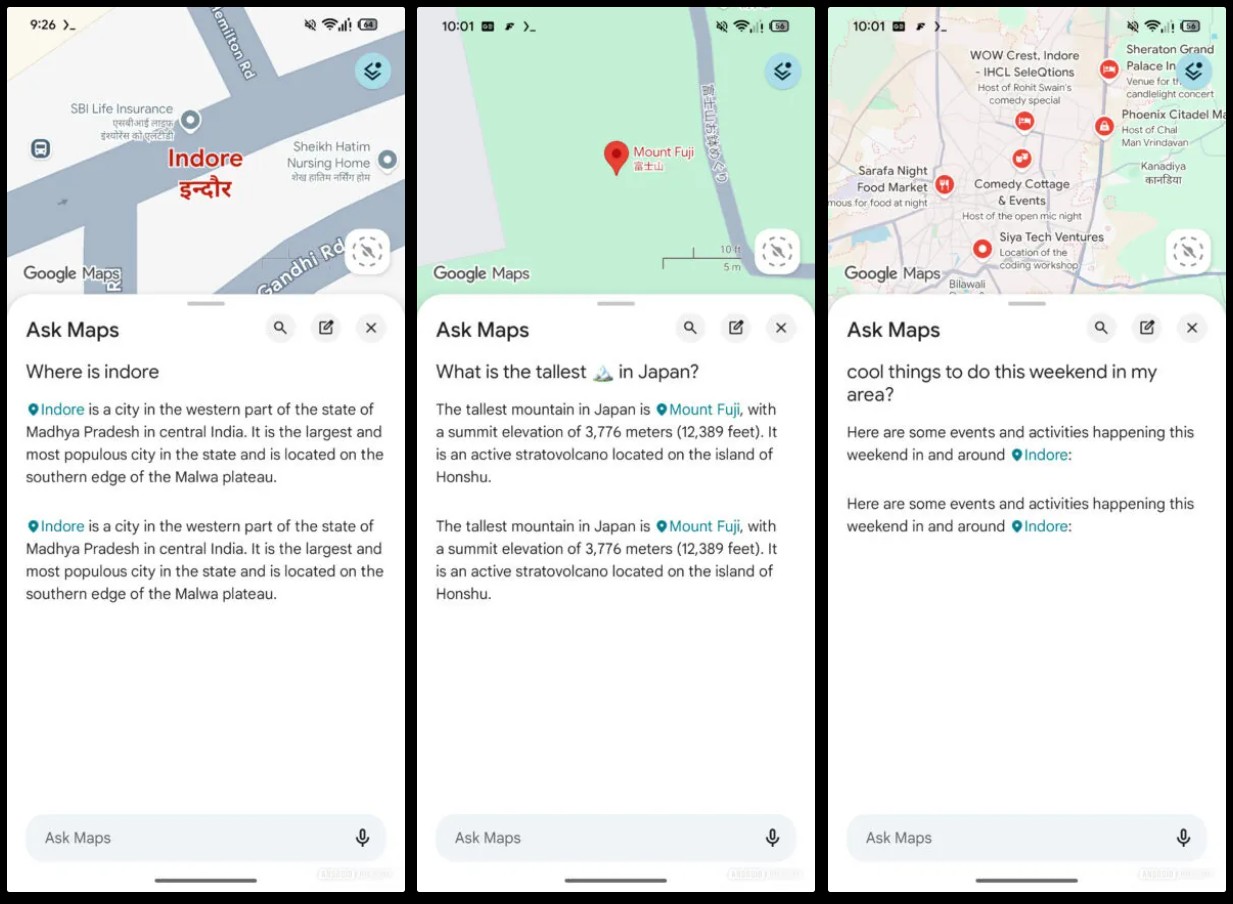

Choć pomysł jest świetny, a interfejs mocno angażujący, to – jak wynika z testów – funkcja jest jeszcze daleka od ideału. Testy nowej funkcjonalności pokazują, że choć podstawowe zapytania działają, często pojawiają się drobne, ale irytujące błędy. Przykładowo, kiedy zapytano o najwyższą górę w Japonii, funkcja poprawnie zidentyfikowała górę Fuji i dostarczyła kilka szczegółów, ale ta sama informacja została wyświetlona dwukrotnie. Ten sam problem z dublowaniem odpowiedzi pojawił się przy innych zapytaniach.

Co więcej, kiedy poproszono o „Fajne rzeczy do roboty w okolicy”, aplikacja pokazała na mapie różne lokalizacje, ale żadna z nich nie została wymieniona na wysuwanym ekranie z wynikami AI. To klasyczny problem wczesnych integracji, gdzie sztuczna inteligencja z jednej strony dostarcza wynik, a z drugiej nie synchronizuje go poprawnie z istniejącym interfejsem mapy.

Czytaj też: Rewolucja w organizacji wiedzy. NotebookLM zyskuje ulepszoną integrację z Dyskiem Google

To pokazuje, że choć wizja jest klarowna – Google chce, aby Mapy były tak inteligentne i rozmowne jak Gemini – implementacja wciąż wymaga dopracowania. Musi to być bezbłędne, by użytkownicy nie stracili zaufania do odpowiedzi dostarczanych przez AI. W końcu na Mapach polegamy, planując podróże, a w przypadku nawigacji nie ma miejsca na błędy. Warto też dodać, że firma pracuje nad podobnymi funkcjami w innych kluczowych aplikacjach. Niedawno pojawiły się doniesienia, że funkcja „Pomóż mi pisać” ma trafić do Dokumentów Google na Androida. Integracja AI to ewidentnie główny priorytet na ten i przyszły rok.

Czytaj też: Wścibskie oko AI. Dlaczego OpenAI monitoruje Twoje czaty, nawet jeśli wyłączyłeś trening modelu?

Plany giganta są więc ogromne i jeśli firmie uda się dopracować synchronizację wyników i usunie błędy w powtarzaniu informacji, możemy zyskać osobistego, inteligentnego przewodnika po okolicy, który rozumie nasze intencje lepiej niż kiedykolwiek. Choć na razie funkcja jest jeszcze w fazie testów i ma swoje wady, kierunek jest jasny – Mapy Google wkrótce staną się naszym najbardziej rozmownym i analitycznym asystentem podróży.