Pszczółka Maja z Microsoftu robi wrażenie swoimi parametrami

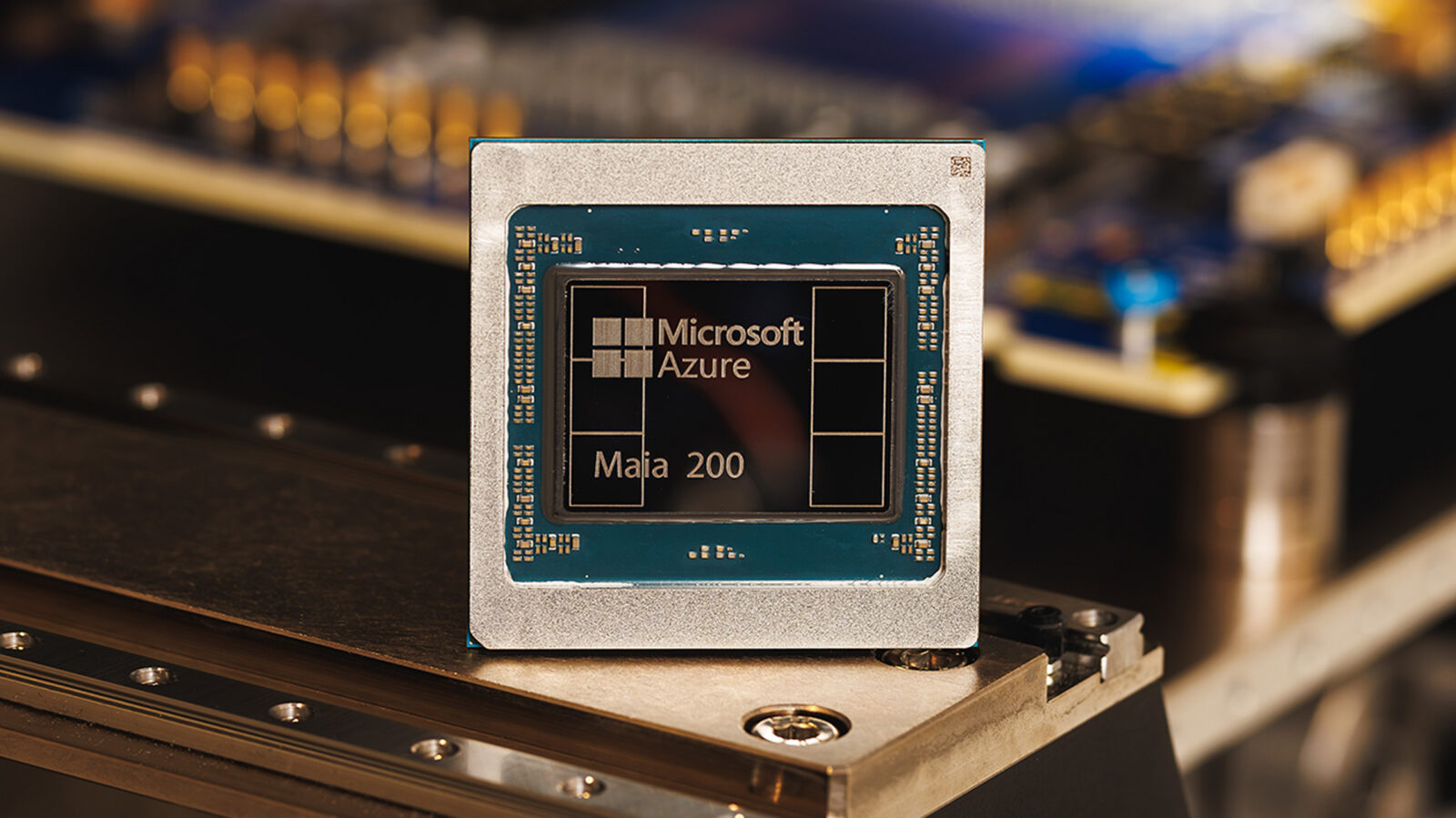

Microsoft postawił na głęboką specjalizację, tworząc akcelerator, który ma przetwarzać miliardy parametrów modeli AI niezwykle szybko i znacznie oszczędniej niż dotychczasowe rozwiązania. Sercem nowego akceleratora jest układ scalony wyprodukowany w zaawansowanym procesie 3 nanometrów przez TSMC liczący ponad 100 miliardów tranzystorów. Microsoft wyposażył Maia 200 w dedykowane rdzenie tensorowe, które natywnie obsługują formaty danych FP8 i FP4, niezbędne obliczeń w sieciach neuronowych.

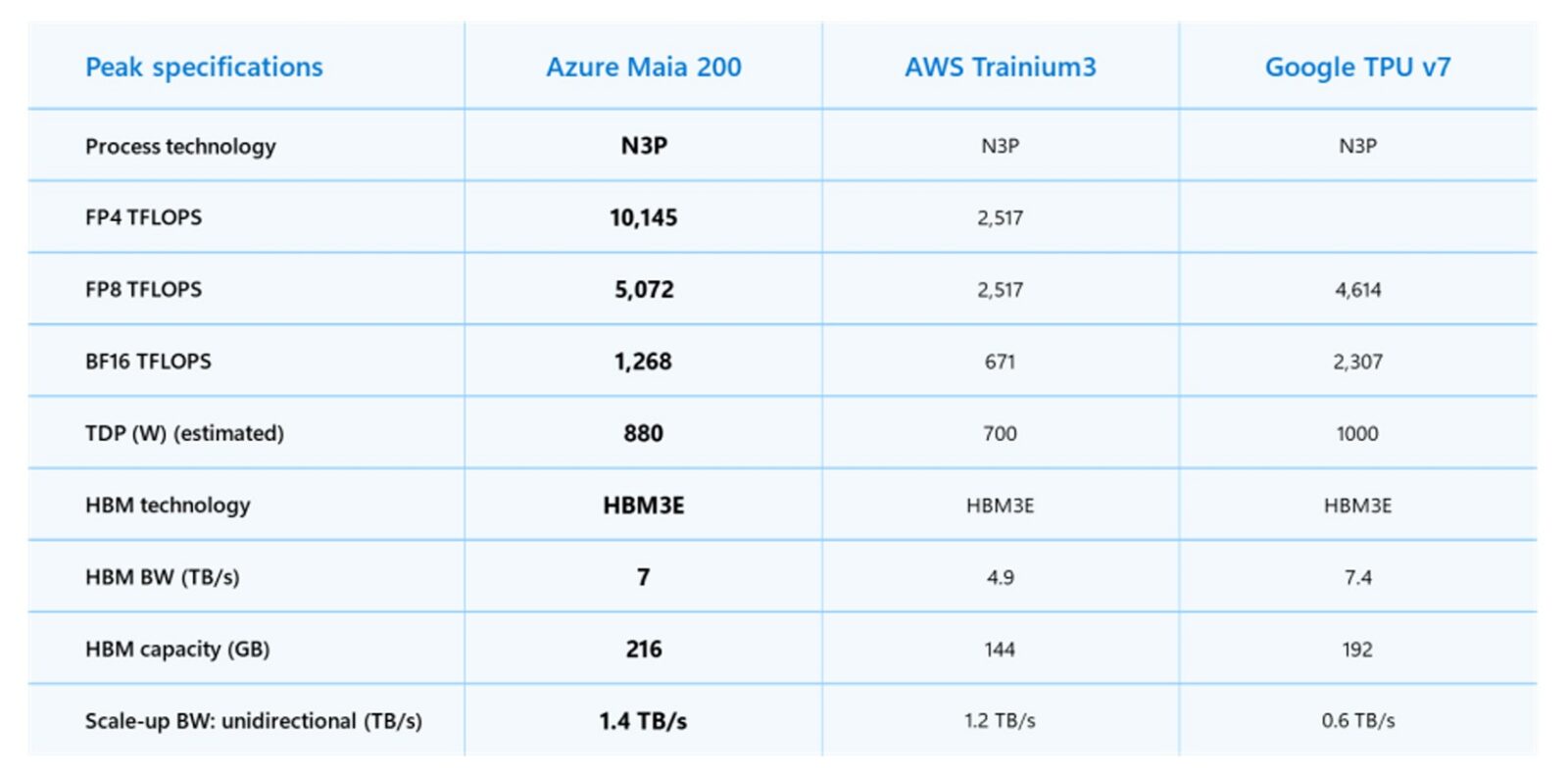

Tak wydajny układ musiał rzecz jasna otrzymać odpowiednio dużo szybkiej pamięci – Maia 200 dysponuje zatem 216 GB wysokowydajnej pamięci HBM3e, oferującej przepustowość na poziomie 7 TB/s, oraz dodatkowymi 272 MB wbudowanej pamięci SRAM. Taka konfiguracja ma zapewnić błyskawiczny dostęp do olbrzymich modeli AI podczas procesu wnioskowania. Jeśli chodzi o czystą moc obliczeniową, Microsoft deklaruje, że Maia 200 osiąga ponad 10 petaFLOPS przy precyzji 4-bitowej i około 5 petaFLOPS przy precyzji 8-bitowej. Dla porównania jest to około 66% mocy najwydajniejszych układów Nvidia Vera Rubin w FP4 i blisko 100% mocy dla FP8.

Nie jest tajemnicą, że Microsoft projektował swój układ z myślą o dwóch głównych konkurentach: Amazonie i Google. Firma twierdzi, że Maia 200 oferuje trzykrotnie wyższą wydajność w precyzji FP4 niż najnowszy akcelerator Amazon Trainium trzeciej generacji. W przypadku formatu FP8 nowy chip ma też przewyższać wydajność siódmej generacji układów TPU od Google.

Być może nawet istotniejsza jest deklarowana poprawa efektywności kosztowej. Microsoft szacuje, że Maia 200 zapewnia o 30% lepszy stosunek wydajności do ceny w porównaniu z jego dotychczasowymi systemami. W skali globalnych centrów danych, gdzie rachunki za energię są astronomiczne, każdy procent oszczędności przekłada się na ogromne kwoty.

Czytaj też: Koniec świętego spokoju na WhatsAppie? Reklamy nadchodzą, ale będzie wyjście

Architektura dla tysięcy chipów Maia 200 działających w harmonii

Pojedynczy, potężny akcelerator to za mało dla współczesnych modeli AI. Microsoft zaprojektował zatem dwupoziomowy system skalowania oparty na standardowym Ethernecie. Każdy układ Maia 200 ma do dyspozycji dedykowaną przepustowość 1,4 TB/s przez 28 łączy Ethernet 400 Gb. Cała architektura pozwala na sprawne i przewidywalne działanie w klastrach obejmujących nawet 6144 akceleratory, co jest niezbędne do rozproszenia obliczeń najbardziej wymagających modeli.

Firma udostępnia też zestaw narzędzi dla programistów – Maia SDK. Mają one pomóc w optymalizacji kodu pod kątem nowego sprzętu, oferując jednocześnie pewną przenośność między różnymi akceleratorami. To ważny krok, bo bez odpowiedniego oprogramowania nawet najlepszy hardware pozostaje bezużyteczny.

Czytaj też; AMD prezentuje AI Bundle, zunifikowany instalator narzędzi AI w sterownikach Radeon Adrenaline

Maia 200 – od pomysłu do przemysłu

Microsoft chwali się, że znacząco skrócił cały proces – od otrzymania pierwszego krzemu do pełnego wdrożenia w centrum danych. Czas ten został zmniejszony o ponad połowę w porównaniu do poprzednich, podobnych projektów, dzięki zaawansowanym symulacjom i przeprowadzonym na długo przed fizyczną produkcją, co pozwoliło wychwycić i rozwiązać potencjalne problemy jeszcze „na papierze”.

Maia 200 debiutuje już w regionie centrum danych US Central. Kolejnym etapem wdrożenia ma być lokalizacja US West 3 w Arizonie. Pierwsze egzemplarze akceleratora trafią do wewnętrznego zespołu Microsoft Superintelligence, zajmującego się rozwojem najbardziej zaawansowanych modeli AI firmy. Będą one wykorzystywane do kluczowych zadań, takich jak generowanie danych syntetycznych czy uczenie ze wzmocnieniem.

Nowy sprzęt zasili także platformę Microsoft Foundry, oferującą narzędzia AI dla deweloperów, oraz usługę Microsoft 365 Copilot zintegrowaną z pakietem Office. Firma sygnalizuje, że w przyszłości technologia może stać się szerzej dostępna dla zewnętrznych klientów chmurowych, jednak na konkretne szczegóły przyjdzie nam jeszcze poczekać.