Największy problem ze zrobotyzowanymi dłońmi wcale nie brzmi w stylu “jak poruszać palcami”, tylko “skąd wiedzieć, co się dzieje przy kontakcie”. Tak się składa, że człowiek nie myśli o tym świadomie, ale stale łączy wzrok z dotykiem, bo m.in. czuje, że nakrętka stawia opór, wie, że przedmiot się ślizga, wyczuwa mikroprzesunięcia zanim jeszcze je zobaczy. W robotach ten “drugi kanał” bywa drogi, skomplikowany albo zwyczajnie pomijany. W tym jednak miejscu pojawia się nowa praca badawcza, która próbuje obejść problem w sposób dość przewrotny: nie budować dłoni od zera, tylko inaczej nauczyć ją rozumieć kontakt.

Dwa etapy nauki. Najpierw obserwacja, potem praktyka

Zespół z Chin zaproponował dwustopniowy schemat uczenia wielopalczastej dłoni robota, inspirowany tym, jak uczą się ludzie: najpierw oglądasz, jak ktoś coś robi, a dopiero potem próbujesz sam. W ich ujęciu pierwsza faza to samouczenie (self-supervised) reprezentacji łączącej wzrok i dotyk na bazie demonstracji człowieka. Dopiero druga faza to właściwe “ćwiczenie” w symulacji, gdzie jedna, wspólna polityka sterowania ma opanować kilka umiejętności naraz, zamiast uczyć się każdej oddzielnie.

Czytaj też: Świetny napęd, ale za mało rowerów. Czy to koniec wielkich marzeń?

W praktyce brzmi to jak próba nauczenia robota intuicji kontaktu bez drogiej skóry pełnej czujników. Zamiast rozbudowanych sensorów haptycznych wykorzystuje się obraz z pojedynczej kamery (monocular) oraz bardzo proste sygnały dotyku w stylu “jest kontakt” albo “nie ma kontaktu”. Nie mówimy tu więc o pełnej mapie nacisku czy wektorach sił na opuszkach, tylko o binarnym bodźcu, który ma wystarczyć, by model lepiej zgadywał, co dzieje się z obiektem w dłoni.

Po co łączyć dotyk ze wzrokiem, skoro kamera “widzi wszystko”?

W manipulacji kamera bardzo często nie widzi tego, co najważniejsze. Robotyczne palce zasłaniają obiekt, obiekt zasłania palce, a przez to kluczowy moment (mikropoślizg albo minimalne przekoszenie) bywa schowany w martwym polu. W materiale opisującym eksperymenty zwraca uwagę próba odtworzenia w sieci neuronowej mechanizmu, który działa trochę jak ludzka integracja sensoryczna, bo gdy tylko “wzrok” ma “przerwę” przez zasłonięcie, dotyk podtrzymuje “stan świata” i pozwala nie zgubić obiektu w trakcie ruchu.

Czytaj też: Naukowcy zbudowali sztuczne oko inspirowane owadami. Drony dostaną zmysł, który trudno będzie zaskoczyć

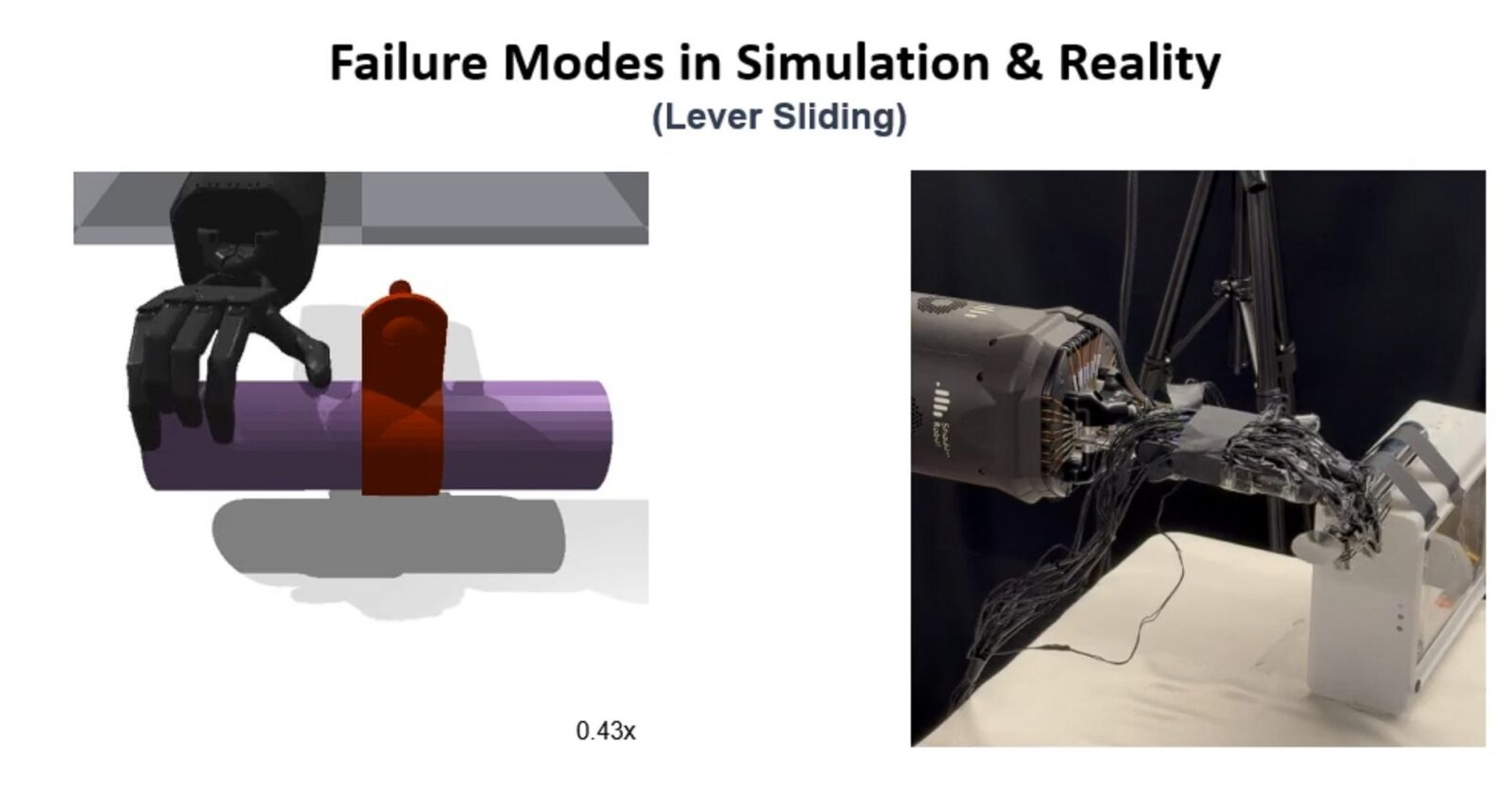

To jest też miejsce, w którym warto zachować ostrożność w interpretacji. Integracja wzroku i dotyku może być “ludzko podobna” na poziomie zachowania, ale wciąż może opierać się na kruchych skrótach statystycznych. Najlepiej widać to po porażkach, które badacze pokazali, zamiast zamiatać je pod dywan. Pojawiają się problemy z momentem obrotowym przy małych zakrętkach, zakleszczanie palców w wąskich elementach (np. uchwycie kranu), ograniczenia zakresu ruchu nadgarstka i sytuacje, w których obiekt ucieka, bo dłoń nie kontroluje poślizgu tak, jak powinny to robić sprawne palce.

Czytaj też: Nowe badania wywracają podręcznik metalurgii. Ten rozgrzany metal staje się twardszy, a nie miększy

W testach system sprawdzano na łącznie ośmiu zadaniach. Pięć było “widzianych” w treningu symulacyjnym (np. odkręcanie nakrętki czy przesuwanie dźwigni), a trzy były nowe i wymagające podobnej koordynacji ręka-obiekt, ale niebędące kopią ćwiczeń. W pracy podano, że na pięciu złożonych zadaniach i 25 obiektach uzyskano średnio 85% skuteczności, a następnie udało się uogólnić umiejętności na trzy niewidziane wcześniej zadania. Czy to świetny wynik? Niespecjalnie, bo oznacza, że co mniej więcej szósta próba się nie uda, a w realnym zastosowaniu taka zawodność szybko stanie się problemem. Dlatego ważniejsze od samej liczby jest to, że badacze próbowali psuć warunki podczas weryfikacji swojego dzieła, bo zmieniali oświetlenie i podmieniali sensory, a system nadal działał. To sugeruje, że model nie nauczył się wyłącznie jednej, kruchej sztuczki pod konkretne ustawienie stanowiska.

Dlaczego takie podejście może działać i dlaczego wciąż może zawieść?

Robot uczy się w symulacji szybko i tanio, ale potem rzeczywistość (tarcie, luzy, elastyczność materiałów, nieidealne czujniki) robi swoje. Autorzy próbują tę przepaść zmniejszyć przez lepsze “rozumienie kontaktu” jeszcze przed treningiem polityki sterowania. Takie podejście ma o tyle dużo sensu, że dotyk jest właśnie tym, czego symulacje najczęściej nie oddają dobrze, a co w prawdziwej manipulacji decyduje o wyniku. Ale jest też druga strona, bo trenowanie na ludzkich demonstracjach może przemycić do modelu nie tylko dobre nawyki, lecz także złe skróty. Widać to w opisywanych “nienaturalnych” akcjach robota, takich jak wykorzystywanie paznokcia kciuka do podważania zakrętki.