W prawdziwym terenie liczy się coś innego niż ostrość: szeroki kontekst, natychmiastowa reakcja i pewność, że sensor nie przestanie działać w niesprzyjających warunkach. Jeszcze ciekawiej robi się wtedy, gdy robot ma nie tylko omijać przeszkody, ale też interpretować zagrożenia, których nie da się zobaczyć. Wycieki gazu, opary chemiczne, strefy niebezpieczne dla człowieka – tu sama kamera bywa ślepa. Właśnie w tym miejscu pojawia się nowy, bardzo nieoczywisty kierunek, który uznaje, że zamiast budować kolejne “lepsze oczy” jak u ludzi, lepiej sięgnąć po to, czym posługują się owady.

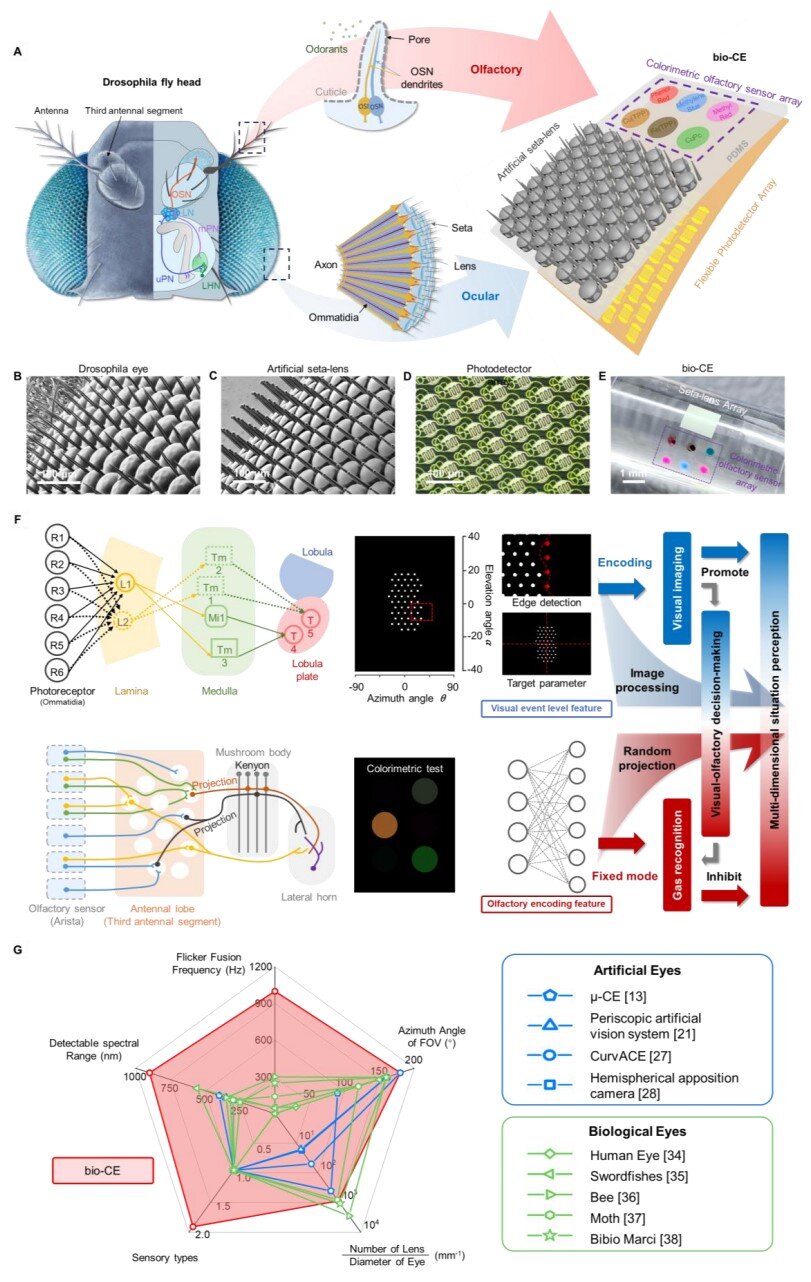

Zespół z Chin opisał w Nature Communications urządzenie w skali owada, które łączy dwa zmysły w jednym module: widzenie szerokokątne i czucie chemiczne, czyli w praktyce “węch”. Autorzy nazywają je bio-C, a więc bioniczne oko złożone, zaprojektowane tak, by mogło prowadzić małe roboty i drony w ciasnych, chaotycznych przestrzeniach.

Dlaczego klasyczna kamera nie zawsze jest odpowiedzią?

W popularnej narracji kamera jest “uniwersalnym sensorem”. Problem w tym, że im mniejszy jest robot, tym bardziej kamera zaczyna być kosztowna. Nie cenowo, tylko energetycznie i obliczeniowo. Szeroki kąt widzenia da się osiągnąć obiektywem typu “rybie oko”, ale wtedy rośnie zniekształcenie obrazu, a naprawa perspektywy i detekcja przeszkód potrafią zjadać cenny budżet mocy. Rozwiązania pokroju LiDAR pomagają, lecz w mikrodronach masa i pobór energii szybko stają się wysoką barierą.

Czytaj też: System wizyjny inspirowany mózgiem rozkłada dotychczasowe technologie na łopatki

Owad idzie inną drogą. Jego oko złożone nie próbuje tworzyć jednego, ostrego “zdjęcia świata”. Zamiast tego zbiera wiele prostych sygnałów z małych kierunkowych kanałów i jest wybitne w tym, co w nawigacji kluczowe: wykrywaniu ruchu i zmian w otoczeniu. Owady płacą za to rozdzielczością, ale zyskują coś, czego brakuje wielu maszynom – reakcję tu i teraz, a na dodatek w szerokim polu widzenia. Przykładowo u muszko owocowej Drosophila jedno oko to rząd wielkości 700-800 ommatidiów (fasetek). W badaniach nad zachowaniem muszek często przewija się też liczba około 200 Hz jako punkt odniesienia dla ich zdolności rozróżniania szybkiego migotania (tzw. flicker fusion). Dla człowieka typowe widełki, w zależności od warunków i metod pomiaru, są najczęściej podawane znacznie niżej, bo wynoszą 50-90 Hz.

Jak zrobić oko złożone w skali owada?

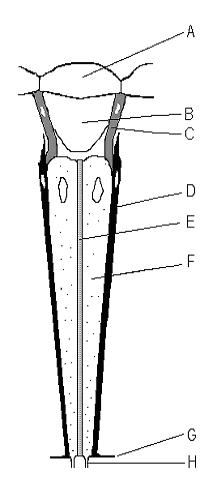

W nowej pracy najciekawsza nie jest sama inspiracja, tylko wykonanie. Autorzy zbudowali miniaturowe oko złożone, gdzie każde ommatidium “patrzy” w swój wycinek sceny i upchnęli 1027 kanałów detekcji na obszarze 1,5 x 1,5 mm. To zaledwie 2,25 mm kwadratowego powierzchni, a więc skala, w której zaczynają się typowe problemy mikrooptyki, bo precyzja osiowania, stabilność mechaniczna, wpływ wilgoci, a nawet drobne błędy geometrii soczewek.

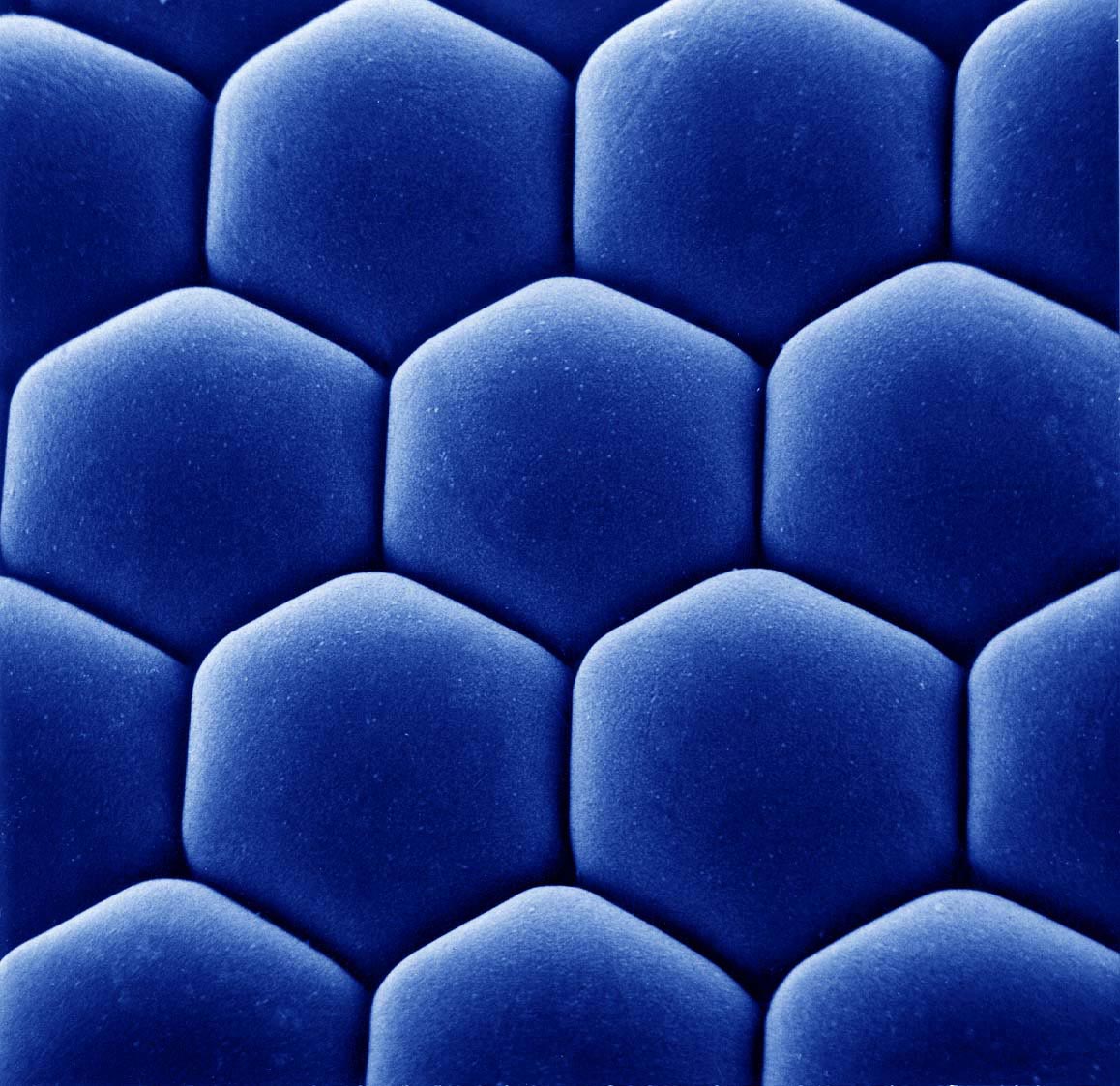

Kluczowy trik polega na tym, że mikrosoczewki nie są osobno produkowane i “doklejane” do matrycy. Zamiast tego są drukowane bezpośrednio na elastycznych fotodetektorach organicznych metodą femtosekundowej dwufotonowej polimeryzacji (FL-TPP). W uproszczeniu: laser o ultrakrótkich impulsach utwardza materiał dokładnie w ognisku, co pozwala rzeźbić struktury 3D w mikroskali z bardzo wysoką kontrolą kształtu. W materiale pomocniczym padają też konkrety sprzętowe (m.in. długość fali 780 nm i impuls 90 fs w procesie), co sugeruje, że nie jest to “tania sztuczka”, tylko precyzyjna fotonika laboratoryjna.

Całe oko uformowano na cylindrycznej powierzchni o promieniu 0,6 mm, czyli o średnicy około 1,2 mm. Taka geometria pomaga w uzyskaniu szerokiego pola widzenia bez jednego dużego obiektywu, bo w grę wchodzi aż 180 stopni w azymucie, co oznacza, że sensor “widzi na boki” bez obracania się platformy. Pomiędzy soczewkami dodano również mikroskopijne struktury przypominające szczecinki, które są wzorowane na owadach. Ich zadanie to ograniczanie kondensacji w warunkach dużej wilgotności i mgły, a więc dokładnie tam, gdzie klasyczna optyka potrafi przegrać z fizyką.

1 kHz i 0,1 ms – po co aż taka szybkość?

W streszczeniu pracy pada liczba, która od razu przyciąga wzrok: 1 kHz. Jest to deklaracja, że układ jest w stanie sensownie rejestrować bardzo szybkie zmiany w oświetleniu i ruchu w skali milisekund, a nie klatek wideo. Autorzy doprecyzowują, że odpowiedź fotoelektryczna fotodetektorów wynosi 0,1 ms, co zresztą tłumaczy, skąd w ogóle bierze się taki zapas czasowy. Wprawdzie brzmi to imponująco, ale tu warto postawić niewygodne pytanie: czy robotowi rzeczywiście potrzebne jest “oko 1 kHz”? Czasem tak – przy unikaniu kolizji z szybko nadlatującym obiektem lub przy stabilizacji lotu w ciasnej przestrzeni. Problem w tym, że sama szybkość sensoryczna to dopiero połowa historii. Druga połowa to przetwarzanie danych i decyzja, a to w mikrodronach pozbawionych opcji posiadania zaawansowanych układów obliczeniowych bywa wąskim gardłem.

Czytaj też: Zapomniany pomysł sprzed epoki Tesli. Naukowcy zrobili z niego akumulator ładujący się w sekundy

Autorzy zdają się to rozumieć, bo w demonstratorach stawiają na przetwarzanie sprzętowe. W opisie platformy omijającej przeszkody pojawia się FPGA (konkretnie rodzina Artix-7), a algorytmy są prototypowane w MATLAB-ie i przenoszone do Veriloga. Innymi słowy: zamiast liczyć na mocny komputer pokładowy, część logiki da się “wypalić” w układzie, co zmniejsza opóźnienia.

“Węch” w oku, czyli czujnik chemiczny bez elektroniki gazowej

Drugi komponent bio-CE jest jeszcze bardziej przewrotny. Zamiast typowego czujnika MOS albo elektrochemicznego, autorzy dodali tablicę wskaźników barwnych, nanoszoną drukiem atramentowym. Jest to klasyczna chemia analityczna w nowym opakowaniu, która działa w doskonale znany nam sposób, bo materiał zmienia kolor po kontakcie z lotnymi związkami, a kamera (lub po prostu odczyt optyczny) rejestruje “odcisk palca” reakcji.

W metodach wymieniono sześć składników takiej tablicy, które zapewniają różnorodne mechanizmy wiązania i reakcji, co pomaga odróżnić grupy związków po wzorze zmian barwy. W testach model osiąga 93% trafności klasyfikacji dla 10 kategorii toksycznych lotnych związków na zbiorze 300 próbek. Tutaj właśnie dochodzimy do najważniejszego ograniczenia, które łatwo przeoczyć, gdy patrzy się tylko na hasło “oko, które widzi i czuje gaz”. Reakcje barwne mają bezwładność. Autorzy piszą wprost, że wywołanie koloru zwykle zachodzi w czasie 30-120 sekund od ekspozycji na wyzwalacz. W scenariuszu mapowania gazu dron musi więc zawisnąć stabilnie przez 60 sekund w punkcie pomiarowym, żeby reakcja zdążyła zajść i była mierzalna. To nie jest “czujnik alarmowy w czasie rzeczywistym” w rozumieniu przemysłowym. To raczej narzędzie do lokalizacji i mapowania zagrożeń, gdzie liczy się rozkład w przestrzeni, a nie natychmiastowy sygnał w tej samej sekundzie.

Autorzy dorzucają zresztą, że choć detekcja w czasie rzeczywistym jest trudna przez opóźnienie reakcji barwnej i analizy, to w przyszłości sensowna może być hybryda, a więc barwna tablica plus szybkie czujniki elektrochemiczne lub MOS, jeśli wymagane jest natychmiastowe sprzężenie zwrotne.

Co pokazały demonstracje? Pojazd, dron i sterowanie bez “kręcenia głową”

Wersja “naziemna” to bezzałogowy pojazd omnidirectional z kołami Mecanum, który omija przeszkody na podstawie danych z bio-CE. Cała architektura jest dość inżynierska, bo obejmuje moduł sensora, płytkę-adapter, FPGA do akwizycji i przetwarzania oraz drukowaną w 3D ramę, więc jest to typowy demonstrator, który ma udowodnić, że sygnał da się przełożyć na sterowanie w czasie rzeczywistym.

Czytaj też: Darmowy prąd z grawitacji? Eksperyment z wahadłem robi furorę w sieci

W powietrzu bio-CE trafia zaś na pokład drona z otwartym sterowaniem lotu. Tam autorzy walidują m.in. śledzenie punktowego źródła światła i rekonstrukcję toru ruchu w 3D na podstawie parametrów kątowych. Dodatkowo dochodzi do tego warstwa fuzji wielozmysłowej, bo obraz ma prowadzić nawigację, a “węch” ma dopowiadać, czy w danym rejonie pojawia się zagrożenie chemiczne.

Brzmi to więc jak system, który ratownicy chcieliby mieć w ciasnych, zadymionych przestrzeniach, ale nadal trzeba pamiętać o jego kompromisach. Oko złożone nie jest od pięknych obrazków. Rozdzielczość będzie niższa, a geometria i krzywizna oznaczają, że rekonstrukcja sceny może wprowadzać zniekształcenia.

Co z tego wynika dla nas i czego jeszcze nie wiemy?

To dzieło naukowców stanowi sygnał, w jakim kierunku może iść sensoryka dla mikrodronów i małych robotów terenowych – mniej fotograficznie, ale bardziej zadaniowo. W praktyce takie rozwiązania mają sens w inspekcjach infrastruktury, przy poszukiwaniu wycieków, w rekonesansie w niebezpiecznych przestrzeniach i w robotach, które muszą działać blisko przeszkód bez ciężkich sensorów. Jest też w tym wszystkim druga strona. Proces wytwarzania, który obejmuje mikrodruk 3D soczewek laserem femtosekundowym, precyzyjne osiowanie, materiały typu PDMS, warstwy organiczne czy domieszki kropek kwantowych ewidentnie nie wygląda jak coś, co jutro trafi na linię masowej produkcji.

Dochodzi do tego jeszcze starzenie materiałów barwnych, odporność na brud i pył, dryft kalibracji, a nawet banalne pytanie o utrzymanie czystości optyki w realnym środowisku. Szczecinki przeciwmgielne to sprytny ruch, ale mgła to tylko jeden z wielu wrogów czujnika. Najuczciwiej jest więc traktować bio-CE jako prototyp, który otwiera dyskusję: jak zrobić czujnik dla robotów, który nie udaje ludzkiego oka, tylko daje maszynie to, czego potrzebuje do przetrwania – natychmiastowy sygnał o ruchu i szeroki kontekst, a do tego dodatkowy kanał ostrzegania o chemii. Dopiero kolejne iteracje pokażą, czy uda się ten pomysł uprościć, utwardzić i przyspieszyć w tej części, która dzisiaj jest najwolniejsza – w “węchu”.