Na drodze liczy się nie tylko to, czy system coś rozpozna, ale czy zdąży to rozpoznać zanim sytuacja przestanie być odwracalna. W świecie autonomii największym wrogiem nie bywa brak mocy obliczeniowej, tylko opóźnienie całego łańcucha – od kamery, przez analizę ruchu, po decyzję. Dlatego właśnie ten temat wraca jak bumerang, bo nawet najlepszy model, jeśli reaguje za późno, w praktyce przegrywa z prostym, biologicznym odruchem.

Jako ludzie nie jesteśmy wcale tacy źli w tej kwestii, bo przy prędkości 80 km/h nasze mózgi potrzebują około 0,15 sekundy na reakcję na nietypową sytuację podczas jazdy (np. przeszkodę na drodze). Tymczasem współczesne autonomiczne samochody radzą sobie z tym znacznie gorzej – ich czas reakcji to nawet pół sekundy. W tym ułamku czasu pojazd jadący z prędkością 80 km/h pokonuje dodatkowe 13 metrów, co często stanowi różnicę między stłuczką a bezpiecznym ominięciem zagrożenia.

Na szczęście ten stan rzeczy może się wkrótce zmienić. Międzynarodowy zespół badawczy opracował system wizyjny, który przynajmniej w laboratorium reaguje szybciej niż ludzki mózg. Jego czas reakcji ma wynosić zaledwie 100 mikrosekund, więc jeśli uda się go wdrożyć, może to znacząco wpłynąć na bezpieczeństwo nie tylko na drogach, ale też w robotyce.

Sprzętowy odruch szybszy od ludzkiego. Jak to możliwe?

Podczas gdy człowiek reaguje niemal natychmiast, maszyna musi najpierw przeanalizować obraz, co zajmuje cenny czas. Analiza przepływu optycznego dla obrazu Full HD może trwać ponad 0,6 sekundy nawet na wydajnej karcie graficznej, co jest czterokrotnie dłużej niż u ludzi. W sytuacjach krytycznych takie opóźnienia są nie do zaakceptowania. Mając to na uwadze, badacze z Chin, Wielkiej Brytanii, Hongkongu, Arabii Saudyjskiej i Stanów Zjednoczonych stworzyli system, który w testach przetwarza dane o ruchu cztery razy szybciej niż obecne algorytmy. W idealnych warunkach przekracza nawet wydajność reakcji ludzkiej.

Czytaj też: Nowe metamateriały z MIT mogą wchłaniać uderzenia jak kontrolowana poduszka powietrzna

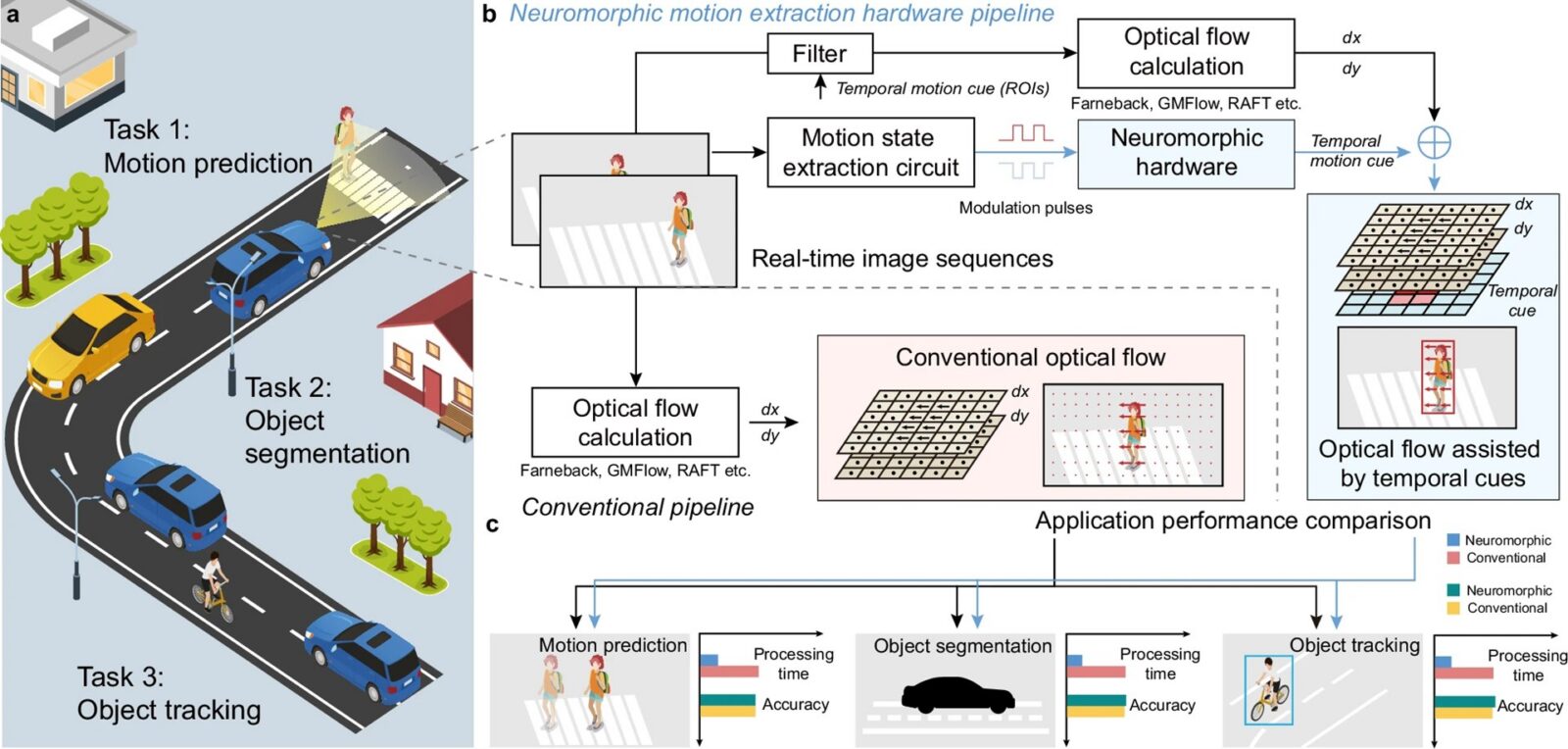

Nowy system działa inaczej. Zamiast przetwarzać każdą klatkę obrazu od zera, koncentruje się wyłącznie na zmianach. Takie podejście w stylu “filtruj-następnie-przetwarzaj” okazało się być ponad dziesięciokrotnie szybsze od konwencjonalnych metod. Gdzie więc faktycznie “ucieka” czas w klasycznym podejściu? Optyczny przepływ nie jest pojedynczą operacją, tylko kosztownym wyznaczaniem wektorów ruchu dla ogromnej liczby pikseli, a potem często kolejną warstwą zadań: śledzeniem, segmentacją, predykcją ruchu.

Autorzy pracy postawili więc na sprytny skrót: układ neuromorficzny nie zastępuje tych algorytmów, a dostarcza im priorytetu czasowego, zapewniając mapy regionów zainteresowania, wygenerowane na podstawie zmian jasności zakodowanych i “przetrzymanych” w stanach analogowych. Efekt? Algorytmy nie muszą szukać ruchu w całym kadrze, bo dostają podpowiedź, gdzie ruch już jest, a tło zostaje odfiltrowane.

Technologia inspirowana ludzkim wzrokiem

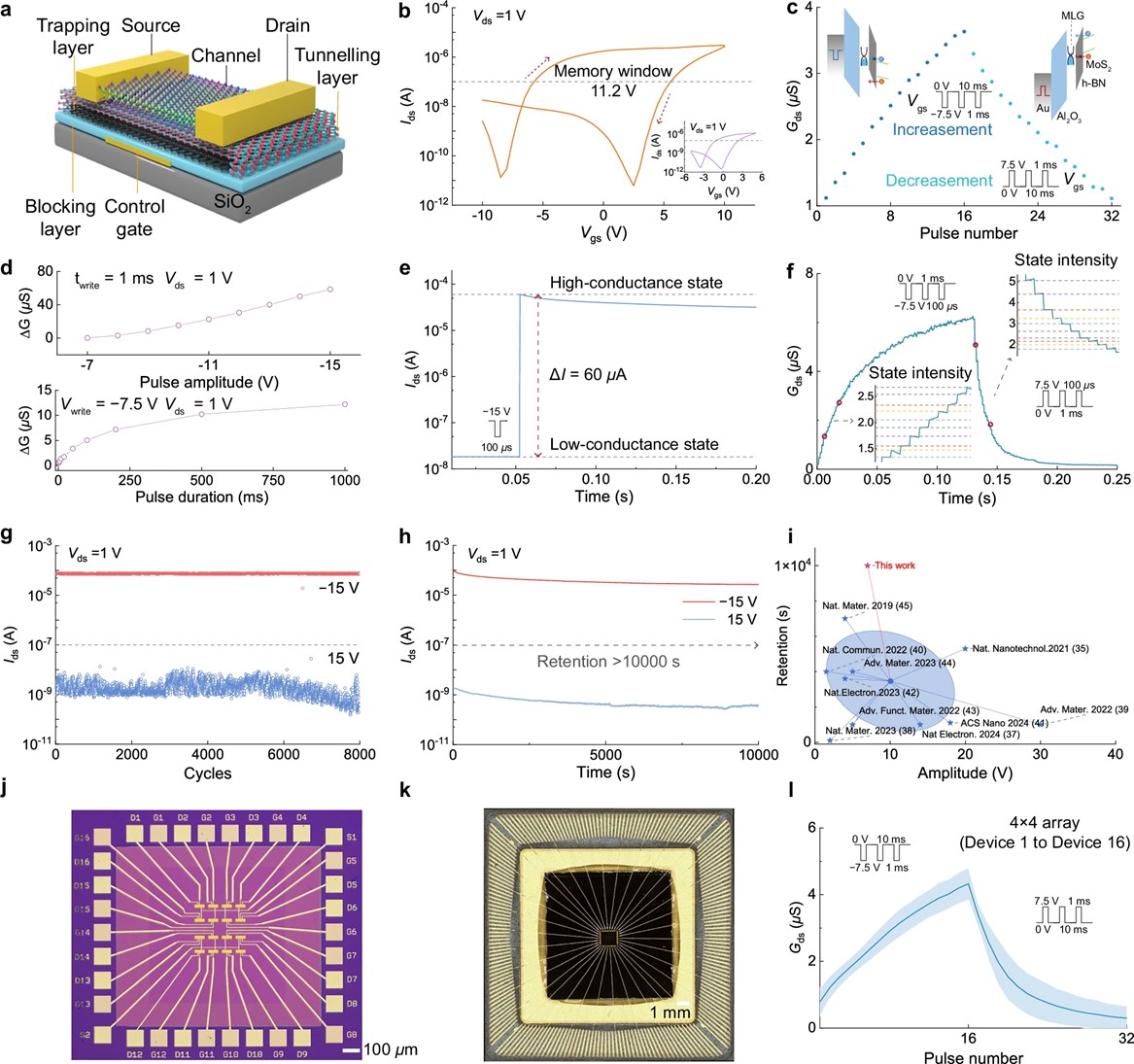

Sercem rozwiązania jest dwuwymiarowa macierz tranzystorów synaptycznych, czyli chip naśladujący sposób przetwarzania informacji wzrokowych przez ludzki mózg. Konkretnie symuluje interakcję między siatkówką a ciałem kolankowatym bocznym, strukturą odpowiedzialną za wstępne przetwarzanie sygnałów wzrokowych. Każdy tranzystor w macierzy koduje zmiany jasności w obrazie i akumuluje je w analogowych, nieulotnych stanach. Gdy zmiana przekroczy określony próg, system generuje zwarty region zainteresowania, czyli obszar wymagający dalszej analizy. Reszta obrazu jest ignorowana, co radykalnie przyspiesza przetwarzanie.

Parametry techniczne robią wrażenie. Tranzystory reagują w około 100 mikrosekund, zachowują stan przez ponad 10000 sekund i wytrzymują ponad 8000 cykli pracy. To oznacza, że system jest nie tylko szybki, ale też trwały i niezawodny. Co istotne, technologia nie wymaga gruntownego przeprojektowania istniejących kamer. Działa jako sprzętowa wtyczka, która po prostu przyspiesza działanie obecnych algorytmów widzenia komputerowego.

Spektakularne wyniki testów nowego podejścia

Liczby z testów są imponujące. System poprawił wykrywanie zagrożeń na drogach o 213,5 procent, a musimy wiedzieć, że poprawa czasu reakcji o około 0,2 sekundy przy prędkości 80 km/h może skrócić drogę hamowania o 4,4 metra. Na tym badacze jednak się nie zatrzymali. W robotyce przemysłowej zdolność chwytania obiektów przez ramiona robotyczne wzrosła zaś o 740,9 procent. System znalazł zastosowanie również w dronach, gdzie czas reakcji skrócono o co najmniej jedną trzecią, poprawiając manewrowość i wydajność lotu. W niektórych scenariuszach testowych, takich jak operacje małych bezzałogowych statków powietrznych, odnotowano poprawę dokładności o 157,4 procent.

Czytaj też: Sześć potężnych rozbłysków na Słońcu. Jeden z nich okazał się najsilniejszym od trzech dekad

Ich działo ma tym samym ogromny potencjał w obszarze interakcji człowiek-robot, bo ultraszybkie przetwarzanie wizualne mogłoby służyć jako kluczowe źródło informacji dla przyszłych robotów, zapewniając płynne i responsywne zaangażowanie. W praktyce oznaczałoby to roboty pracujące bezpieczniej w otoczeniu ludzi, reagujące na ich ruchy niemal natychmiast.

Średni współczynnik przyspieszenia we wszystkich 33 grupach zadań testowych wyniósł 26,1 procent, co odpowiada około czterokrotnemu przyspieszeniu w porównaniu do standardowych metod. Całkowity czas przetwarzania, obejmujący zarówno wykrywanie ruchu, jak i wykonanie zadań, osiągnął zaś około 150 milisekund, więc jest to poziom porównywalny z ludzką percepcją, a w niektórych przypadkach nawet go przewyższający.

Co dalej z tym systemem analizowania obrazu?

Nie wszystko jednak wygląda idealnie. Naukowcy przyznają, że w niektórych scenariuszach wydajność systemu spada. W sytuacjach z ruchem własnym pojazdu lub ruchem wykraczającym poza typowe wzorce przyspieszenie maleje z 400 procent do około 134-170 procent. Jest to wciąż dobry wynik, ale pokazuje, że technologia ma jeszcze pole do rozwoju. Badacze mają jednak ambitne plany.

Czytaj też: Miały pękać, a wytrzymują. Najbardziej bezczelny pomysł na elektronikę od lat

Nowy system wizyjny to krok w stronę autonomicznych maszyn, które nie tylko dorównują ludziom w szybkości reakcji, ale w niektórych aspektach je przewyższają. Dla branży pojazdów autonomicznych, która od lat zmaga się z problemem bezpieczeństwa, to może być istotny postęp. Pytanie brzmi, jak szybko technologia trafi z laboratoriów na drogi. Wyniki testów są obiecujące, ale rzeczywiste wdrożenie wiąże się z dodatkowymi wyzwaniami, takimi jak koszty, integracja z istniejącymi systemami i testy w różnych warunkach pogodowych. Jeśli te przeszkody uda się pokonać, możemy być świadkami prawdziwej zmiany w dziedzinie automatyzacji.