Asystent OpenClaw – do czego to się może przydać?

Firma opublikowała właśnie szczegółowy przewodnik dotyczący konfiguracji takiego rozwiązania na kartach graficznych RTX. Pomysł, by AI pracowało lokalnie, zyskuje na popularności, szczególnie wśród osób, które chcą zachować pełną kontrolę nad swoimi informacjami. OpenClaw działa nieprzerwanie w tle systemu operacyjnego. Jego największą zaletą jest bezpośredni dostęp do zasobów komputera: plików na dysku, skrzynki e-mail, kalendarza czy aplikacji komunikacyjnych. Łączy się z popularnymi komunikatorami, takimi jak WhatsApp, Telegram, Discord, Slack, Signal i iMessage, stanowiąc swego rodzaju centrum dowodzenia dla naszej cyfrowej komunikacji.

System ma trwałą pamięć i potrafi działać proaktywnie. Może samodzielnie wysyłać przypomnienia, uruchamiać zaplanowane zadania czy pracować bez ciągłego polecenia ze strony użytkownika. W praktyce może to oznaczać automatyczne układanie wiadomości, zarządzanie terminami w kalendarzu, śledzenie postępów w projektach lub generowanie raportów, które łączą informacje z sieci z danymi przechowywanymi lokalnie. Wszystko to odbywa się bez angażowania zewnętrznych serwerów.

Czytaj też: Chcę zacząć nagrywać filmy do Internetu. Jakim sprzętem to robić?

Dlaczego karty graficzne NVIDIA RTX są kluczowe dla wydajności lokalnych modeli AI

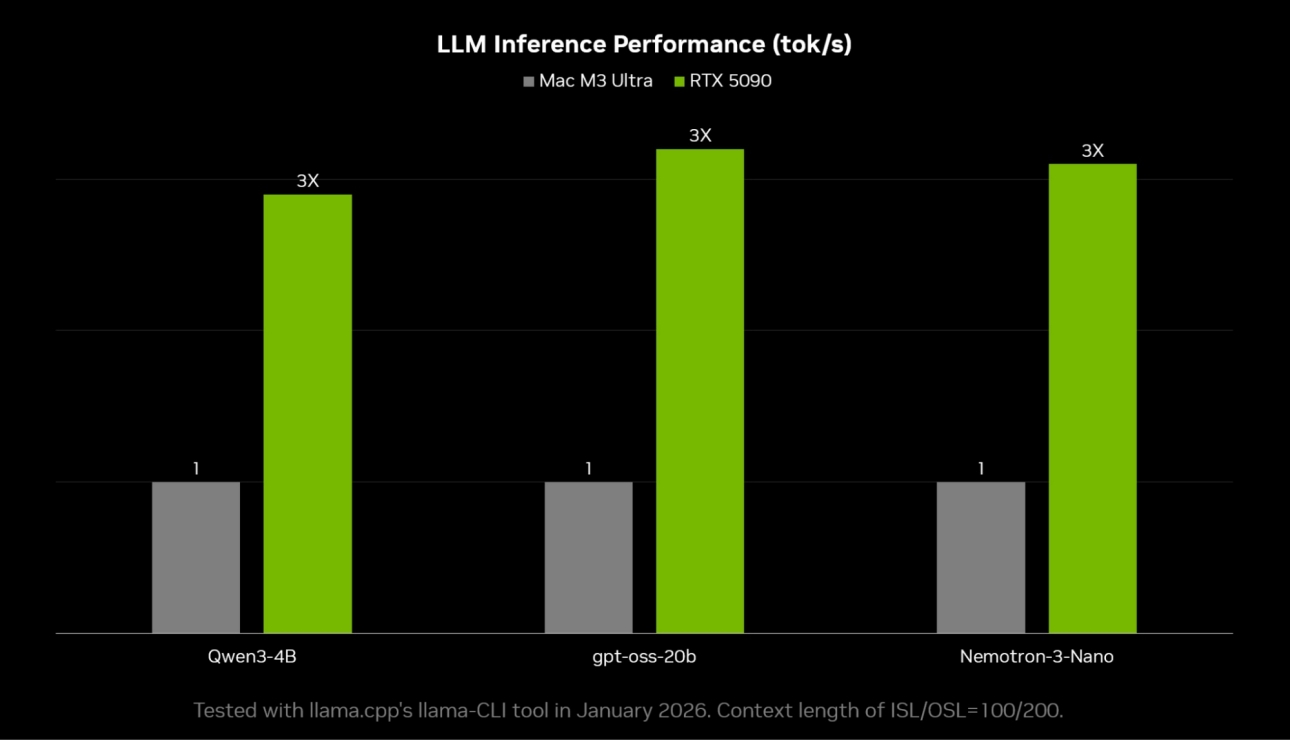

Uruchomienie zaawansowanego modelu językowego na domowym komputerze wymaga sporej mocy obliczeniowej i tutaj z pomocą przychodzą karty graficzne serii RTX od NVIDIA, które dzięki dedykowanym rdzeniom Tensor i optymalizacjom w ramach CUDA znacząco przyspieszają pracę dużych modeli. Narzędzia takie jak Llama.cpp czy Ollama potrafią w pełni wykorzystać ten potencjał, zapewniając płynność konieczną do nieprzerwanej pracy asystenta.

Przewodnik przygotowany przez NVIDIA koncentruje się na konfiguracji w środowisku Windows z wykorzystaniem WSL (Windows Subsystem for Linux) – choć teoretycznie możliwa jest natywna instalacja przez PowerShell, twórcy odradzają to ze względu na potencjalną niestabilność. Cały proces obejmuje zarówno instalację samego OpenClaw, jak i skonfigurowanie lokalnie działającego modelu językowego.

Do zarządzania modelami zaleca się głównie dwa narzędzia – LM Studio oferuje najwyższą wydajność, bazując na Llama.cpp, z kolei Ollama dostarcza dodatkowych funkcji ułatwiających wdrożenie dla developerów. Wybór zależy od indywidualnych potrzeb i tego, co jest dla użytkownika ważniejsze – czysta moc czy wygoda obsługi.

Dopasowanie modelu językowego do możliwości karty graficznej

Wybór konkretnego modelu determinowany jest głównie ilością pamięci wideo (VRAM) w karcie graficznej – NVIDIA sugeruje różne opcje w zależności od posiadanego sprzętu. Dla kart z 8-12 GB VRAM rekomendowany jest model qwen3-4B-Thinking-2507. Posiadacze układów z 16 GB mogą pokusić się o gpt-oss-20b, a ci dysponujący 24-48 GB VRAM – o Nemotron-3-Nano-30B-A3B.

Niezwykle istotnym parametrem jest rozmiar okna kontekstowego. Zaleca się ustawienie go na co najmniej 32 tysiące tokenów, a najlepiej więcej – daje to modelowi przestrzeń do analizowania długich rozmów i złożonych zadań, co przekłada się na lepsze zrozumienie kontekstu i bardziej trafne odpowiedzi.

Uruchamianie OpenClaw na PC z grafiką RTX to jedno, do najcięższych zadań NVIDIA poleca jednak platformę DGX Spark z aż 128 GB pamięci. To rozwiązanie zaprojektowane do ciągłej pracy, które umożliwia uruchomienie największych modeli, takich jak gpt-oss-120b, które oferują najwyższą dokładność i są przeznaczone raczej dla zaawansowanych użytkowników i małych firm, a nie przeciętnych konsumentów.

Czytaj też: Meta, w domu na pewno wszyscy zdrowi?

Rozszerzanie funkcjonalności przez system umiejętności NVIDIA ClawHub

Podstawowe możliwości NVIDIA OpenClaw można rozbudowywać za pomocą dodatkowych modułów, nazywanych umiejętnościami (skills). Publiczny rejestr ClawHub pozwala użytkownikom na dzielenie się, instalowanie i aktualizację takich rozszerzeń – wszystkie są otwarte i wersjonowane, a system rejestruje historię ich wykorzystania.

Aby ograniczyć ryzyko publikacji złośliwego kodu, dodawanie nowych umiejętności wymaga posiadania konta na GitHub, które istnieje co najmniej od tygodnia. To proste, ale skuteczne zabezpieczenie ma odstraszyć potencjalnych niedoszłych hakerów. Użytkownicy instalują nowe funkcje albo przez interfejs webowy, albo przeglądając katalog dostępny w ClawHub.

Ten system sprawia, że OpenClaw jest wyjątkowo elastyczny – co ciekawe, agent może nawet samodzielnie decydować o rozszerzeniu swoich możliwości, instalując nowe narzędzia w odpowiedzi na zdiagnozowaną potrzebę. To daleko idąca autonomia, która odróżnia to rozwiązanie od sztywnych, chmurowych usług typu SaaS.

Lokalni agenci NVIDIA AI i problem prompt injection

Agent AI działający w kontekście systemu operacyjnego ma duże możliwości, ale dostęp do osobistych plików wiąże się także z oczywistym ryzykiem. Dwa główne niebezpieczeństwa to potencjalny wyciek wrażliwych danych oraz narażenie komputera na złośliwe oprogramowanie czy cyberataki. Kluczowym wyzwaniem pozostaje tzw. prompt injection, czyli technika manipulacji modelem poprzez odpowiednio spreparowane polecenia tekstowe.

Skalę problemu widać na przykładzie innych projektów – podatności na tego typu ataki były zgłaszane w przypadku asystenta Grok od xAI, jednak firma bagatelizowała zgłoszenia, uznając je jedynie za „informacyjne”. Unikalna słabość Groka wynikała z faktu, że jego prompt systemowy zaczynał się od danych użytkownika, co ułatwiało spersonalizowane ataki.

W OpenClaw prompt systemowy stanowi jedynie ogólną wytyczną. Prawdziwe zabezpieczenia mają wynikać z polityki narzędzi, mechanizmów zatwierdzania akcji oraz opcjonalnego umieszczenia modelu w piaskownicy (sandboxing). Należy pamiętać, że nadanie agentowi kontroli nad przeglądarką internetową jest równoznaczne z daniem mu dostępu do wszystkich kont zalogowanych w jej profilu – to poważna decyzja, której nie powinno się podejmować bez zastanowienia.

Daj swojemu agentowi AI tyle uprawnień ile to niezbędne i ani trochę ponad to

Transkrypcje wszystkich sesji z OpenClaw są domyślnie zapisywane na dysku w folderze ~/.openclaw/transcripts w formie zwykłego tekstu. Konieczne jest więc odpowiednie zarządzanie uprawnieniami do tego katalogu, ponieważ jego przejęcie przez nieuprawnioną osobę oznacza dostęp do całej historii rozmów.

Twórcy zalecają kilka środków ostrożności. Najbezpieczniej jest uruchamiać asystenta na wydzielonym komputerze, który nie zawiera ważnych danych osobistych, lub w odizolowanej maszynie wirtualnej. Warto też tworzyć dedykowane konta użytkownika, zamiast przyznawać agentowi uprawnienia do głównego profilu. Kluczowa jest również ostrożność przy instalowaniu umiejętności – lepiej ograniczyć się do tych szeroko sprawdzonych i używanych przez społeczność.

Wszystkie kanały komunikacji z asystentem, jak interfejs webowy czy integracja z komunikatorami, powinny być zabezpieczone przed dostępem z sieci lokalnej czy internetu – jeśli nie jest to absolutnie konieczne, warto rozważyć całkowite odcięcie agenta od dostępu do sieci, ruch radykalny, jednak skutecznie minimalizuje pole do potencjalnego ataku.