Procesor NVIDIA H100 czerpie użytek z tego, jak ważne są transformery dla przyszłości SI. W skrócie? Transformery zwracają “uwagę” na wiele zdań, co pozwala im uchwycić kontekst i poprzedników

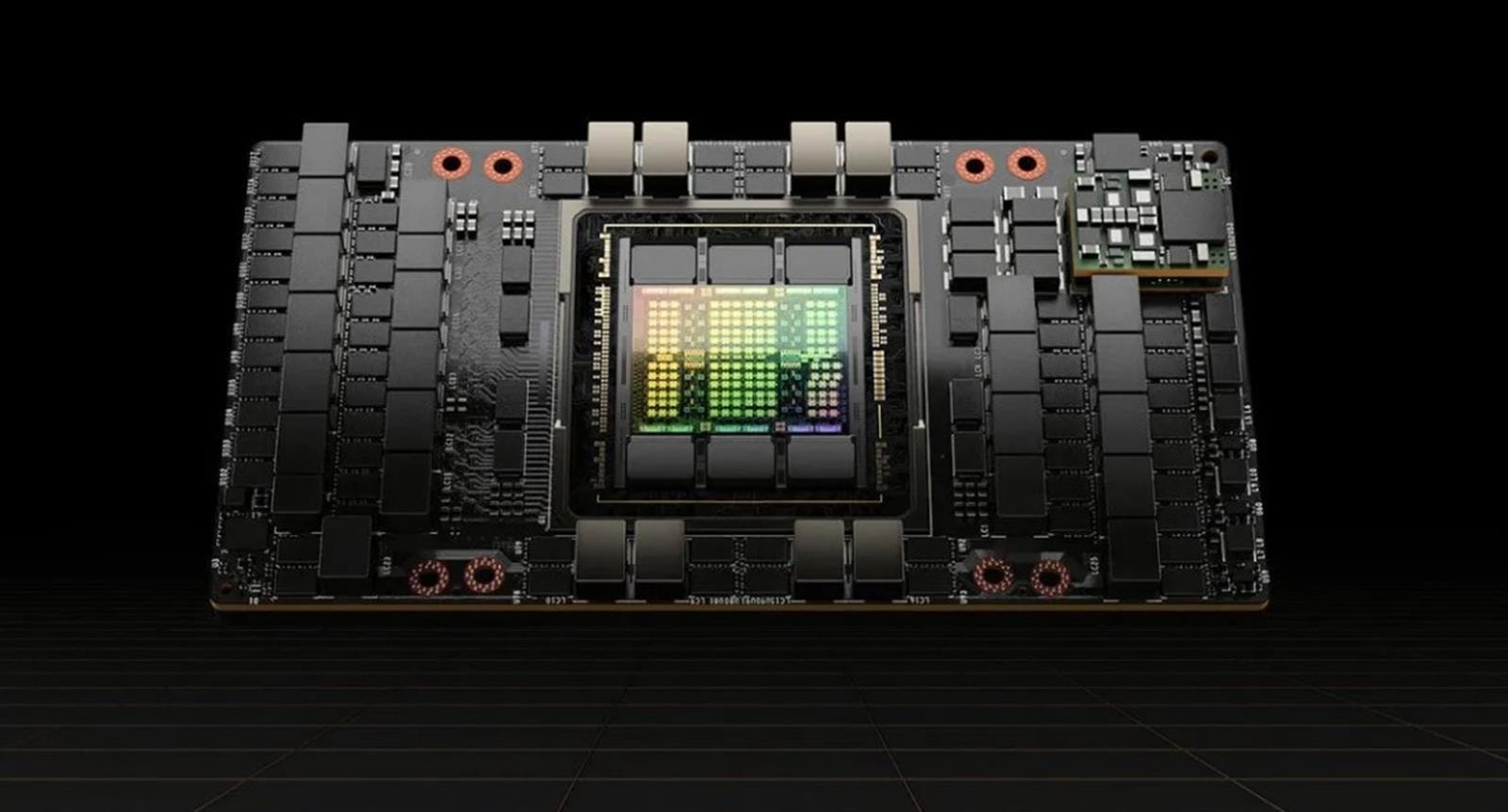

Procesor graficzny H100 różni się na wielu płaszczyznach względem poprzednika, czyli A100. Wśród wielu zmian w architekturze znalazł się specjalny silnik ukryty w jednostkach obliczeniowych, dzięki któremu te mogą zmienić swoją charakterystykę i tym samym przyspieszyć trening transformerowych sieci neuronowych. Obecnie trend na rynku SI kieruje się w stronę sieci neuronowych o jednostkach o możliwie najmniejszej precyzji (to poprawia wydajność), ale jednocześnie dokładnych wynikach (gwarantuje to precyzyjne obliczenia).

Czytaj też: Undervolting RTX 3090 Ti ma ogromny sens. Sprawdźcie wydajność flagowca ograniczonego do 300 watów

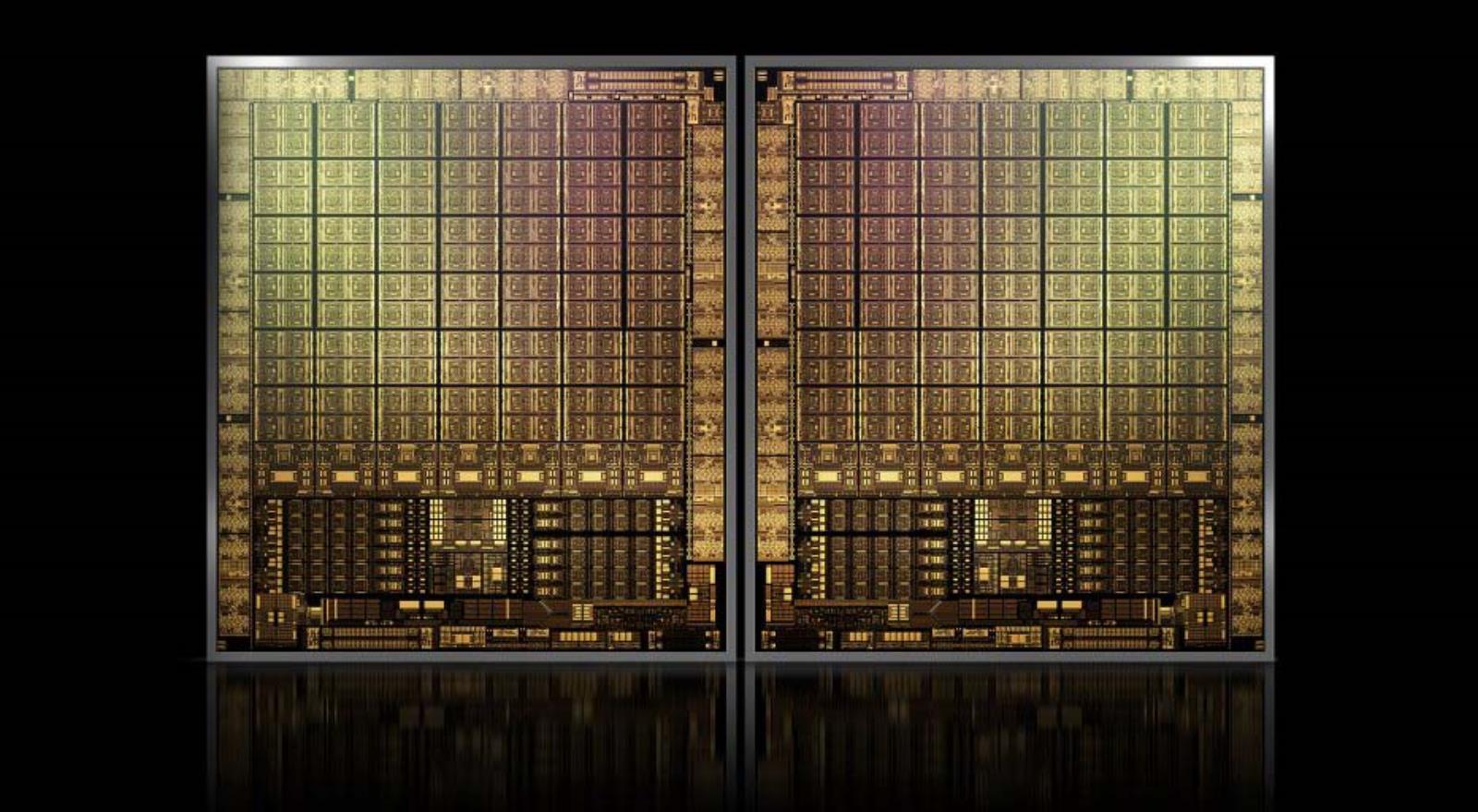

W praktyce, wspomniany silnik w H100 to tak naprawdę oprogramowanie połączone z nowymi możliwościami sprzętowymi wyspecjalizowanych w liczeniu macierzy rdzeni Tensor w architekturze Hopper. Te są zdolne do wykonywania obliczeń na liczbach zmiennoprzecinkowych o różnej precyzji od 64-bitowej do 8-bitowej, a nie minimalnie 16-bitowej, jak w przypadku architektury Ampere i GPU A100. Wynik? Podwojenie przepustowości.

Czytaj też: Flagowe karty graficzne nowej generacji. Co zdradzają świeże plotki?

Problem w tym, że zwykle obniżenie precyzji o połowę nie kończy się dobrze dla owoców obliczeń, ale to w przypadku sztucznej inteligencji i kierowania się w stronę transformerów nie jest aż takim problemem. Zwłaszcza że H100 pozwala obliczać jedne obliczenia w myśl 8-bitowej precyzji, a inne z 16- i 32-bitowej, a na dodatek wykonywać te obliczenia z wykorzystaniem jednej z dwóch postaci liczb 8-bitowych.

Czytaj też: Alder Lake-X w bazie danych. Czy Intel wróci do segmentu HEDT w obecnej generacji?

W praktyce 8-bitowe jednostki obliczeniowe Hopper mogą pracować z 5 bitami wykładnika i dwoma mantysy (E5M2), gdy ważny jest zasięg lub z 4 bitami wykładnika i trzema mantysy (E4M3), gdy kluczowa jest precyzja. Silnik przekształcający na bieżąco organizuje to, co jest potrzebne, aby przyspieszyć trening.