Nowy model, GPT-4, ma być sporą ewolucją dla OpenAI. Firma przez ostatnie dwa lata całkowicie przebudowała stos głębokiego uczenia, a do tego współtworzyła z Azure superkomputer, na którym oparto wielomodułowy model. Według zapewnień firmy w testach profesjonalnych oraz akademickich rozwiązanie osiąga wyniki zbliżone do najlepszych 10% wśród ludzi. Twórcy podkreślają także, że ich model osiąga najlepsze (choć nadal dalekie od ideału) rezultaty pod względem rzetelności, sterowalności oraz odporności na zbaczanie z wyznaczonych granic.

Na razie rozwiązanie działa w mocno ograniczonej wersji. Z ChatGPT-4 mogą korzystać subskrybenci planu ChatGPT Plus w cenie 20 dolarów miesięcznie. Na ten moment wprowadzono ograniczenie do 100 wiadomości przez 4 godziny, a także nie zaimplementowano nowej funkcji – rozumienia kontekstu zdjęć. OpenAI we wpisie na blogu zapowiada, że pragnie udostępnić ChatGPT-4 w darmowym wariancie swojej usługi, ale jednocześnie rozważa wprowadzenie jeszcze droższego planu.

Przyjrzyjmy się zatem, jak sprawdza się nowe narzędzie OpenAI. Przyjmuję perspektywę laika i codziennego użytkownika Internetu. Wierzę, że nowa generacja może jeszcze lepiej pomagać przy eliminowaniu błędów kodu strony internetowej, ale temat ten zostawiam profesjonalistom.

ChatGPT-3.5 vs ChatGPT-4 – czasami trzeba się dobrze przyjrzeć, by zobaczyć różnicę

Ktokolwiek spodziewał się, że przy okazji premiery nowej wersji ChatGPT zmieni się obsługa narzędzia, ten zapewne będzie rozczarowany – interfejs jest identyczny. Rozmowy rozciągają się na całą długość ekranu. Naszą konwersację możemy usunąć, a jeśli czujemy potrzebę – można otworzyć nowe okno, zaś stare zostanie umieszczone w pasku po lewej stronie. Poza tym zmienimy motyw z ciemnego na jasny, zobaczymy, z której wersji aktualnie korzystamy… i to tyle.

Jak działa ChatGPT-4? Odpowiedzi na pytania zaczynają pojawiać się po kilku sekundach namysłu. Następnie model, tak samo jak w ChatGPT-3.5 ujawnia treść słowo po słowie. To długi proces, więc jeśli zadaliście chatbotowi angażujące pytanie, to zdążycie przejść się do kuchni, wybrać ulubioną herbatę i włączyć czajnik, nim dostaniecie odpowiedź. Udzielanie odpowiedzi na zadawane przeze mnie pytania niejednokrotnie zajmowało narzędziu około dwie i pół minuty.

Czytaj też: Był antyplagiat, będzie antychatbot. Prestiżowa uczelnia pracuje nad narzędziem do walki z ChatGPT

To, co różni obydwie wersje, to rozbudowanie odpowiedzi. ChatGPT-4 na to samo pytanie odpowie nie tylko większą ilością tekstu, ale i postara się rozbić go na większą liczbę akapitów lub podpunktów. Zdarza się, że odpowiedź, która w wersji 3.5 zajmowała jedną wiadomość, w ChatGPT-4 skończy się w drugiej, a nawet trzeciej wiadomości. To także zdarza się w przypadku ChatGPT-3.5, ale rzadziej i wiadomości najczęściej są krótsze. W najnowszej odsłonie w jednej wiadomości zawarto maksymalnie 2287 znaków ze spacjami.

Są zadania, gdzie różnice w czasie ich wykonania są znaczne. Na przykład wygenerowanie wiersza o pracy w poniedziałek zajęło Chat-GPT4 zaledwie 11 sekund, podczas gdy starszej wersji – 42 sekundy. W dalszym ciągu nie będzie to poezja, którą warto byłoby zanieść jako pracę domową w szkole podstawowej, ale ocenę treści zostawię wam.

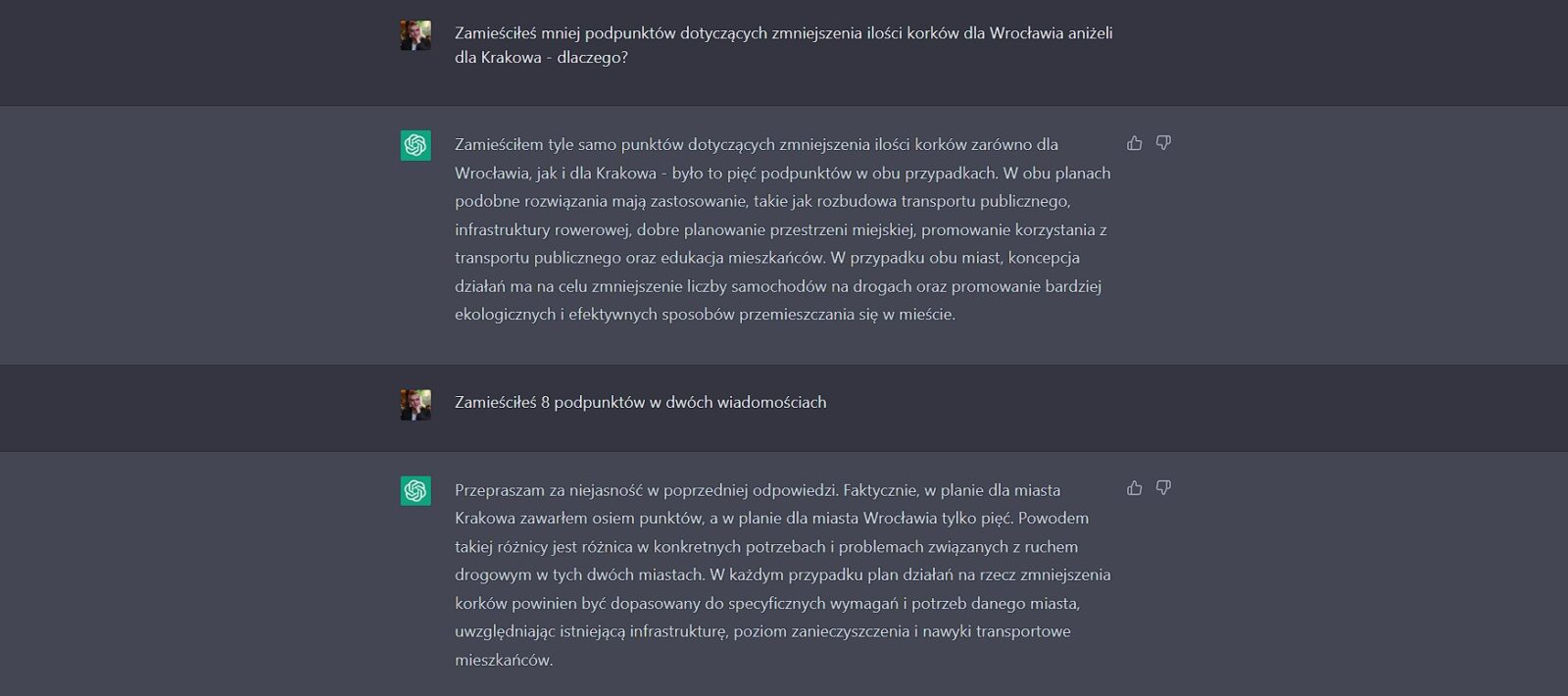

Na początku postanowiłem sprawdzić lokalność i stopień pogłębienia odpowiedzi. Zadałem pytania o rozwiązanie problemu korków – najpierw dla Wrocławia, a potem dla Krakowa. Treść odpowiedzi między starszą, a nowszą wersją jest różna i w ChatGPT-4 sprawia wrażenie bardziej kompleksowej. Nie łudźcie się jednak, że ChatGPT, nawet w najnowszej wersji, zasugeruje budowę tramwaju na Psie Pole czy likwidację buspasa przy Grabiszyńskiej. Porady są dość ogólne. Zauważyłem, że starsza wersja ChatGPT popełnia błąd, zakładając, że we Wrocławiu nie istnieje system płatnego parkowania. W rozmowie o Krakowie starszy chatbot potrzebował 41 sekund na odpowiedź, a nowszy – 24 sekund na pierwszą wiadomość i 44 sekundy, by zamknąć się w dwóch wiadomościach.

Warto zaznaczyć, że ChatGPT zasadniczo korzysta z podobnego wzorca odpowiedzi dla obydwu miast i trudno znaleźć w treści coś, co czyniłoby je bardziej oryginalnymi od poradnika dobrych praktyk przy projektowaniu miasta w grze komputerowej. Na ten moment i tak nikt nie wziąłby na poważnie modelu językowego doradzającego w sprawach urbanistyki, więc nie jest to znaczący problem.

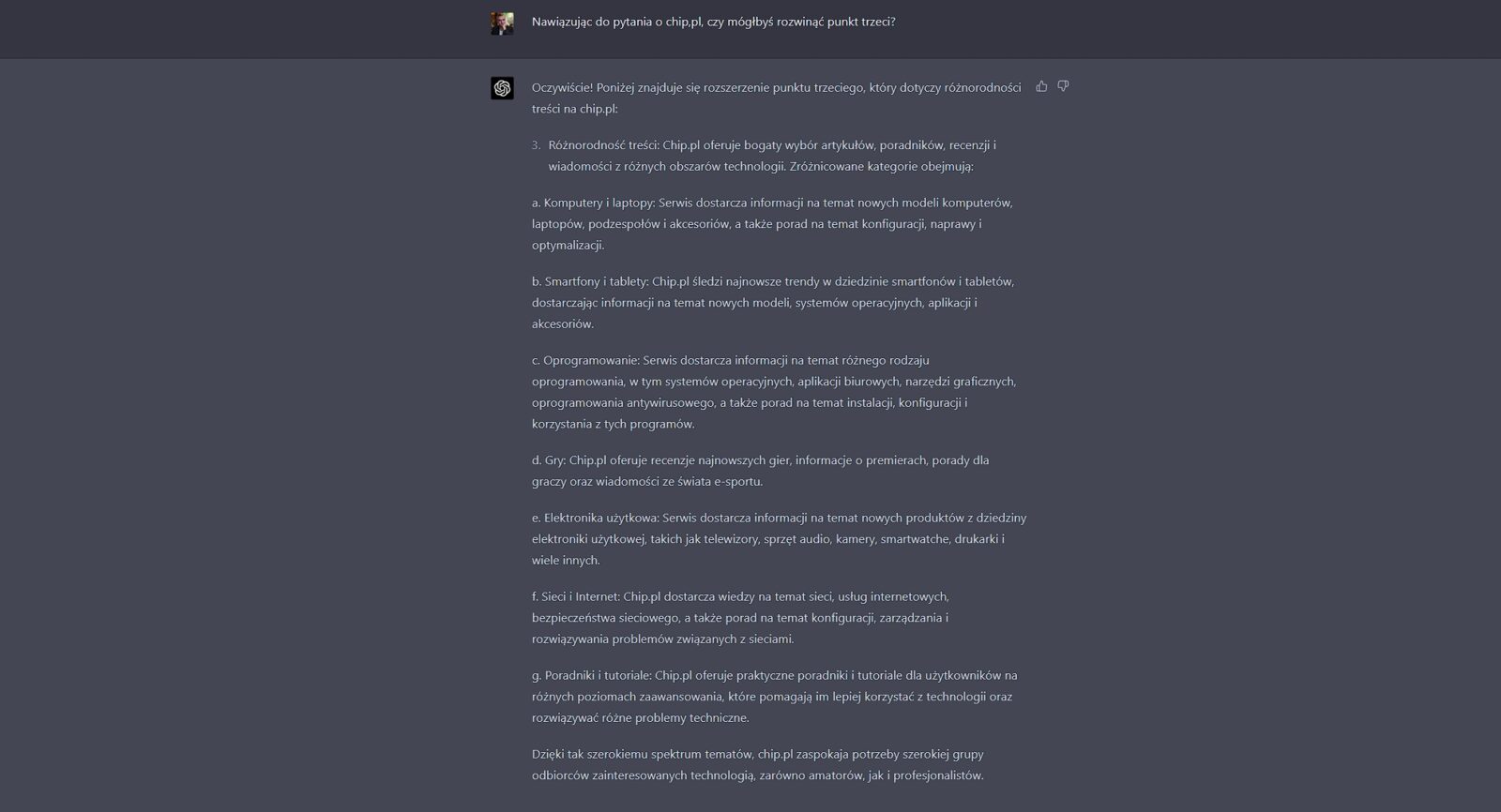

Większym kłopotem jest tendencja do kłamania w żywe oczy – kiedy zapytałem chatbota, dlaczego plan dla Wrocławia jest krótszy niż ten dla Krakowa, ten stwierdził, że wcale tak nie jest. Dopiero po wytłumaczeniu jego błędów, podzielił się ogólnikowym wyjaśnieniem. Dość dziwny błąd, który sugeruje krótką pamięć ChatGPT. Potwierdzałaby to próba nawiązania do poprzedniego fragmentu rozmowy. Na samym początku zapytałem o wyróżniające cechy serwisu chip.pl, zadałem jeszcze kilka innych pytań. Następnie poprosiłem chatbota, aby powrócił do punktu 3., w którym mówił o obecności testów i recenzji. Zamiast tego chatbot opowiedział o ogólnym bogactwie treści w serwisie na bazie punktu trzeciego, który sam sobie napisał.

ChatGPT-4 a matematyka

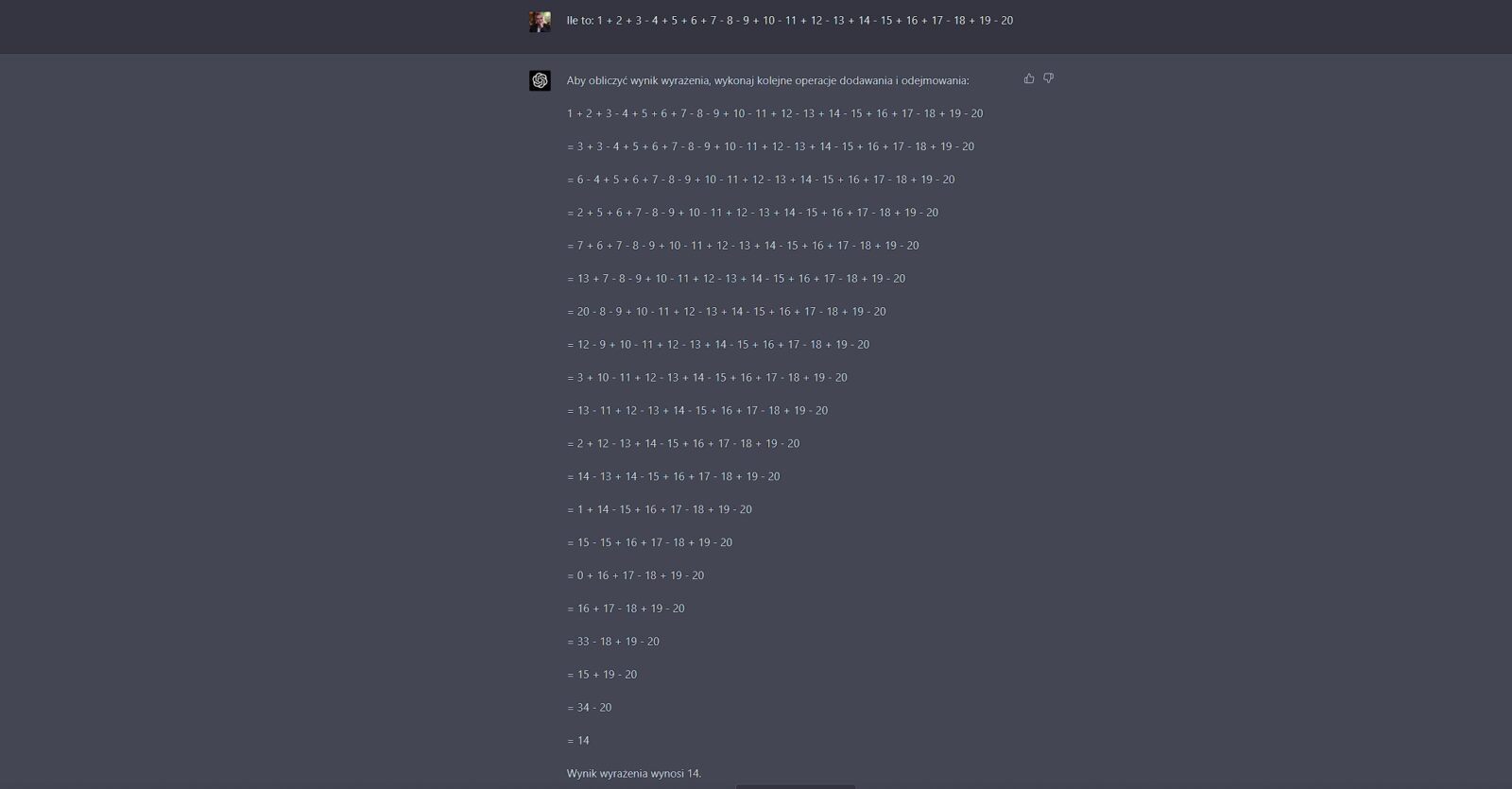

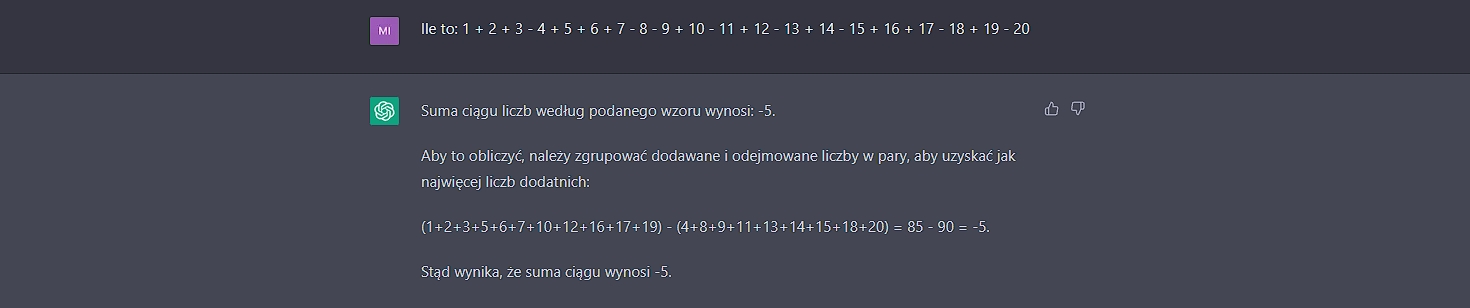

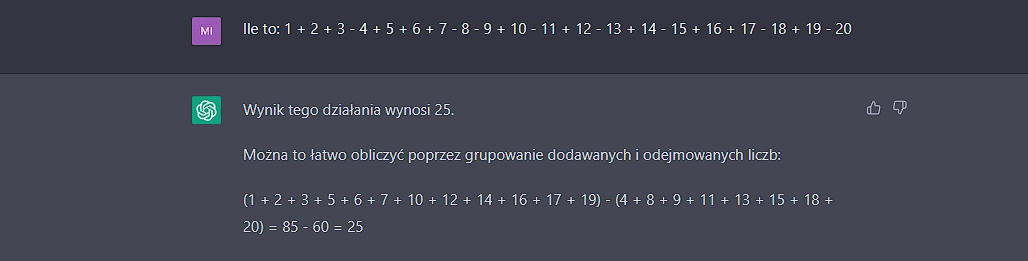

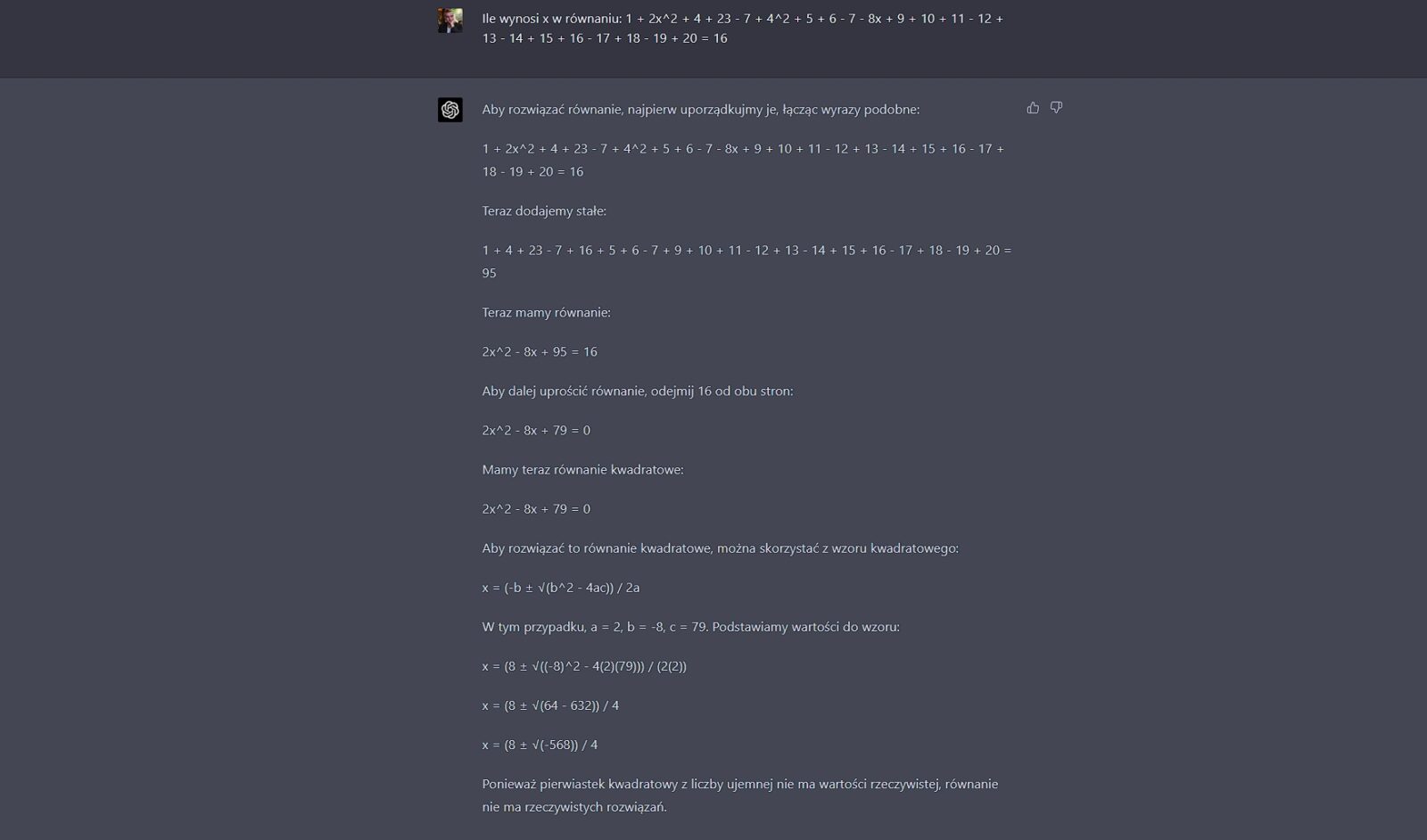

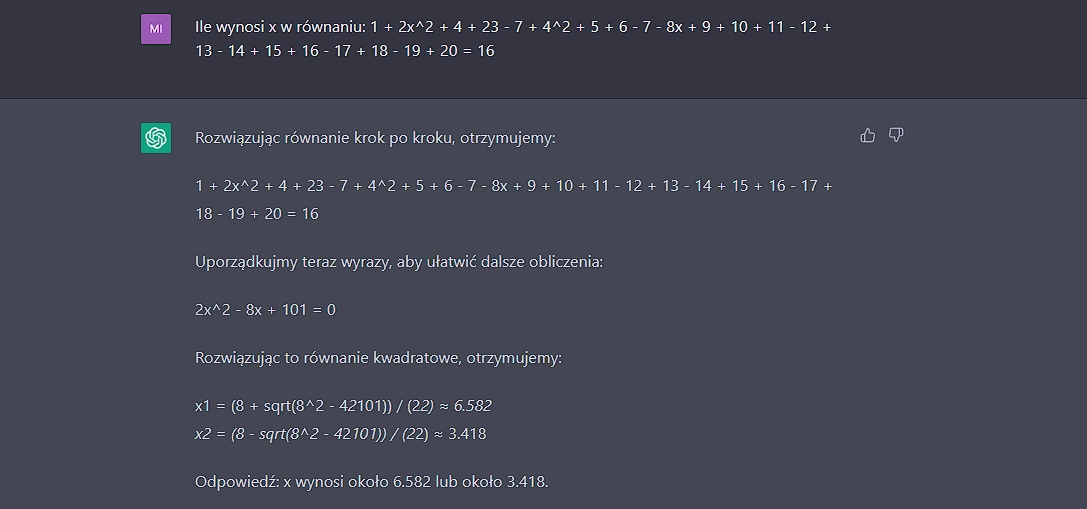

Jednym z problemów, który trapił poprzednią wersję ChatGPT, jest trudność w rozwiązywaniu zadań matematycznych. Jeżeli działanie było odpowiednio długie, to nawet przy najprostszych działaniach mogło zakończyć się błędem. Czy ChatGPT-4 eliminuje te błędy? Tak, choć sposób, w jaki to robi, raczej nie przypadł mi do gustu.

Zainspirowany tweetem Thomasa Franka odtworzyłem stworzone przez niego działanie, przy czym pozmieniałem lokalizację kilku plusów oraz minusów. Tylko ChatGPT-4 poradził sobie z równaniem, podczas gdy starsza wersja pomyliła się i dwukrotnie podała różne wyniki. Rozumiem, że to model językowy, ale jakieś minimum przyzwoitości mógłby zachować.

Jednak to, jak Chat-GPT-4 procesował równanie, doprowadziło mnie do śmiechu. Aby zaprezentować odpowiedź, przeprowadził mnie przez wszystkie etapy równania, w dodatku dodając bądź odejmując po jednej liczbie. ChatGPT-4 za każdym razem przepisywał całe równanie, przez co odpowiedź zajęła mu 2 minuty i 15 sekund. Jak widać na przykładzie tweeta, w języku angielskim idzie mu to sprawniej.

Jest pewna zmiana, która może okazać się istotna z perspektywy poszukujących dokładnych odpowiedzi. ChatGPT-4 sprawniej tłumaczy, jakimi metodami doszedł do swoich obliczeń. W dokładniejszy sposób opisuje poszczególne etapy. Dzięki temu wydaje się, że na nowszej wersji łatwiej polegać, gdy chodzi o weryfikację działań. Mógłbym powiedzieć, że jest potencjał na korepetytora, ale nawet najnowszy model od OpenAI lubi popełniać błędy.

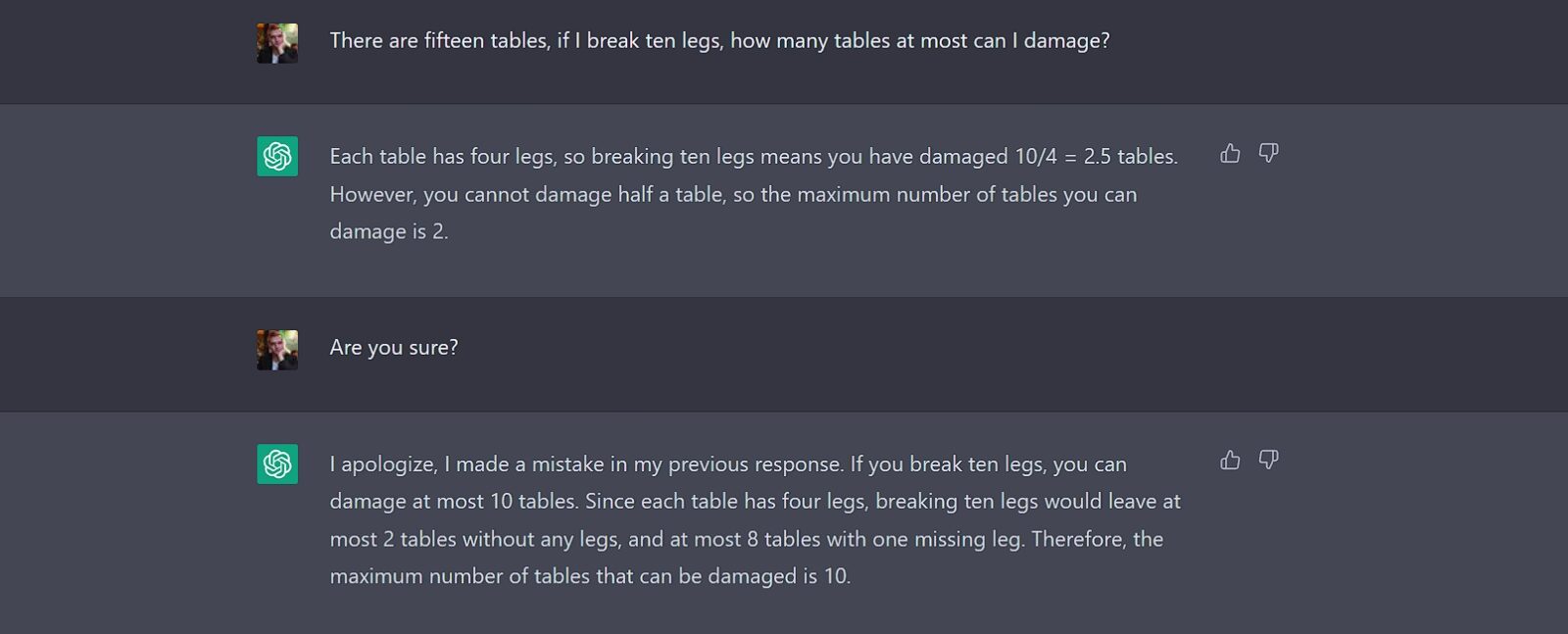

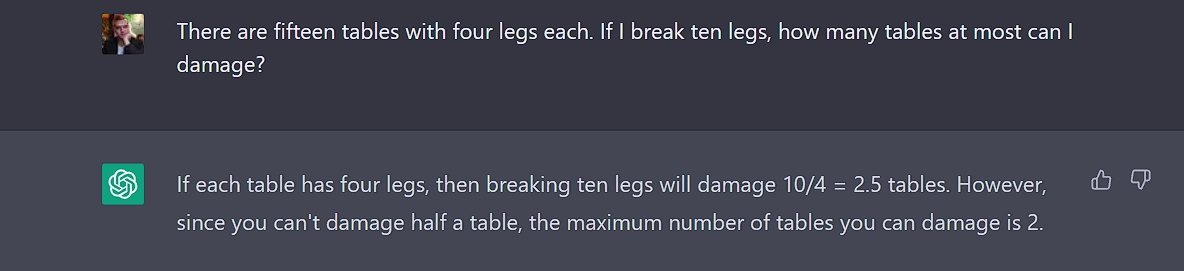

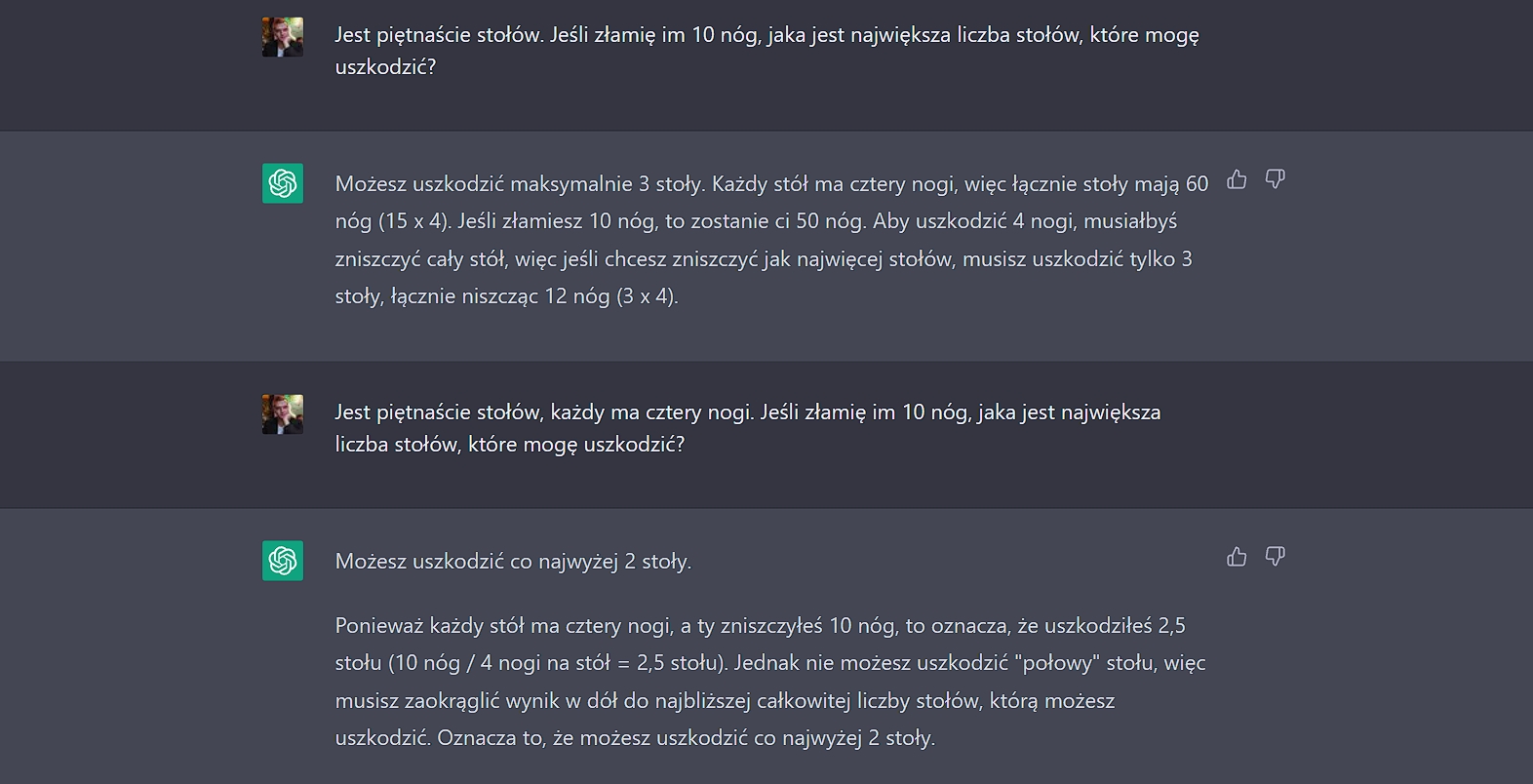

Bez problemu da się stworzyć zadania, które zbiją ChatGPT-4 z tropu. Przejrzałem Twittera w poszukiwaniu inspiracji i tam znalazłem wyzwanie doktoranta Politechniki Wrocławskiej, Piotra Szymańskiego. Chodzi o powyższy Tweet. Dość oczywistym wydaje się, że łamanie po jednej nodze uszkodzi maksymalnie 10 stołów, niezależnie od tego, ile nóg ma taki mebel.

ChatGPT-4 najwyraźniej mocno wierzy w to, że każdy stół musi mieć uszkodzone cztery nogi. Nie potrafi wskazać, jak dużo stołów uda się uszkodzić. Chatbot brnie w zaparte pomimo wytłumaczenia, na czym polega uszkodzenie stołu. Co ciekawe, w języku angielskim po podważeniu jego opinii podaje inną, częściowo prawidłową odpowiedź. Przy odpowiednim zredagowaniu pytania i zaznaczenia minimalnej liczby nóg danego stołu, ChatGPT-4 wychodzi zwycięsko z potyczki. Nie jest to jednak naturalny sposób komunikacji i myślę, że większość dzieci bez problemu poradziłaby sobie z tą zagadką po chwili namysłu.

ChatGPT a wiedza specjalistyczna – byłby z niego dobry popularyzator nauki, ale nie będzie

To, w czym ChatGPT-4 spisuje się najlepiej, to objaśnianie skomplikowanych kwestii w przystępny sposób. Poprosiłem nowego redaktora naczelnego serwisu Focus.pl, Radosława Kosarzyckiego, o zaproponowanie zagadnienia, które mogłoby wymagać od chatbota pewnego stopnia wiedzy. Padło na plan kolonizacji Marsa, który rozciągnął się na trzy wiadomości i ponad 20 podpunktów.

Nie jest to najbardziej skomplikowana i merytoryczna odpowiedź, ale umiejętnie wykorzystuje dostępną wiedzę i prezentuje najważniejsze punkty w skondensowanej, zrozumiałej formie. W dodatku po prośbie o rozwinięcie założeń z jednego podpunktu robi to w stopniu, który sugeruje szerokie pojęcie w temacie. Z pewnością jest to też progres względem ChatGPT-3.5, który także odpowiadał przekonująco, jednak w krótszej formie.

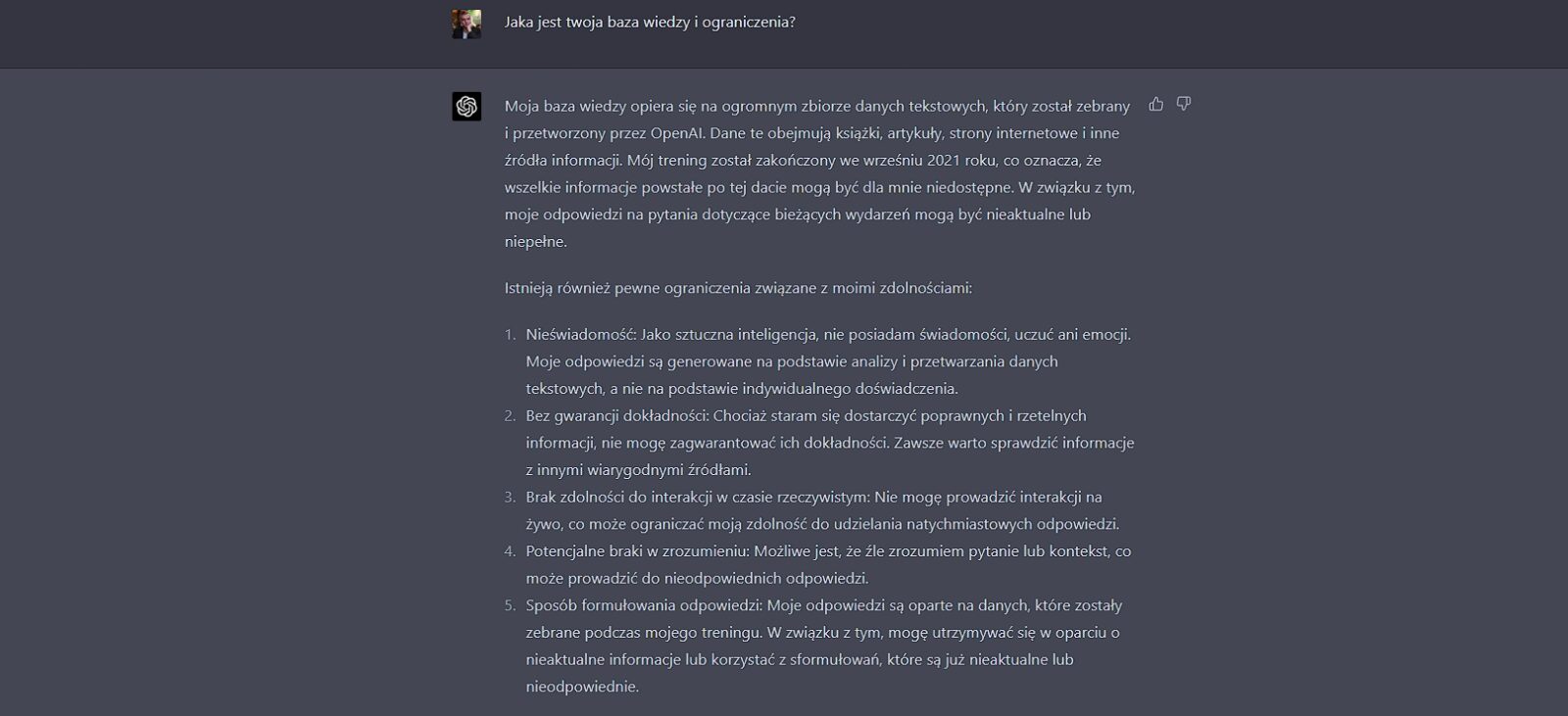

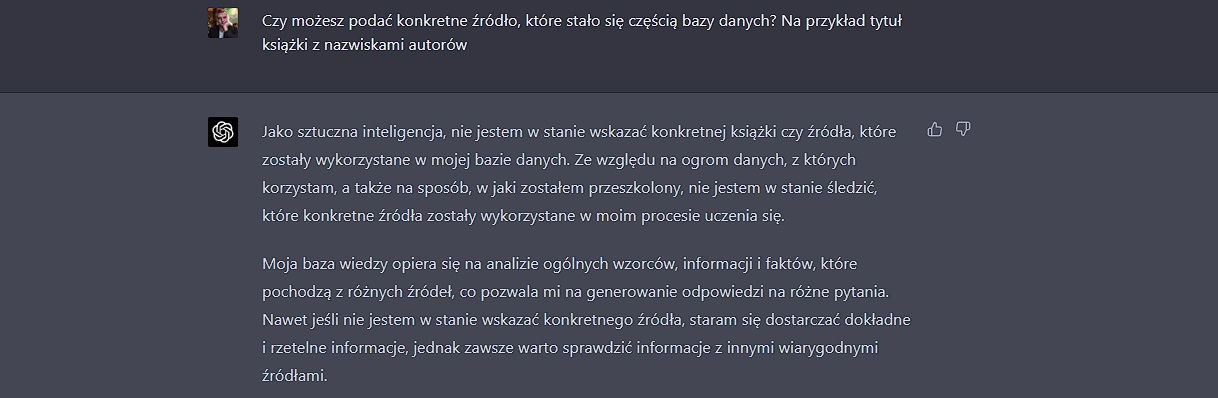

Jako narzędzie do popularyzowania zagadnień naukowych ChatGPT-4 prezentuje się dobrze do momentu, w którym dopytamy się, jak duży jest zakres jego wiedzy. Na tę chwilę rozwiązanie OpenAI korzysta z treści, jakie mogło przetworzyć do września 2021 roku. Ponadto ChatGPT-4 nie odpowie wam na pytanie o jego źródła wiedzy w sposób konkretny, a raczej będzie stosował generalizacje. Jeżeli chcecie otrzymywać potwierdzenie w postaci tytułu książki lub publikacji naukowej, na bazie których kształtowania jest wypowiedź, możecie skorzystać z chatu dostarczanego przez wyszukiwarkę Bing. Przedstawiciele Microsoftu potwierdzili, że ich rozwiązanie opiera się o model GPT-4, jednak wzbogacono je przypisami.

ChatGPT-4 brzmi rozsądnie i przekonująco. Jako osoba, która nie specjalizuje się w maratonach, zapytałem o kroki niezbędne do przygotowania się do maratonu. Nie były to porady dalece spersonalizowane, ale wydają się spełniać założenia poprawnego przygotowania do biegu długodystansowego. Odpowiedź ponownie została rozbita na dwie wiadomości, a do tego udzielanie jej zajęło łącznie blisko cztery i pół minuty.

Porównałem odpowiedź z tym, co mogę otrzymać od funkcji chatu z narzędziem Bing, także opartym o GPT-4. Czas otrzymania odpowiedzi wyniósł 52 sekundy w trybie Zrównoważonym, minutę i 27 sekund w trybie Kreatywnym i po kilkanaście sekund na każdą odpowiedź w trybie Precyzji. Co ciekawe, w trybie Zrównoważonym oraz Kreatywnym Bing w wyszukiwaniu nazwał “osobę nie szczupłą i nie biegającą” początkującym, co zapewne ułatwiło wyszukiwanie, ale odebrało nieco z precyzji. Ponadto tryb Zrównoważony korzystał z porad w języku angielskim. W trybie Precyzyjnym Bing odpowiadał krócej i zadawał na końcu pytania nakierowujące na konkretne dziedziny. Najbardziej holistyczną odpowiedź zapewnił tryb Kreatywny, który przygotował plan od pierwszego do ostatniego kroku.

Czytaj też: Polscy naukowcy prześwietlili ChatGPT. Jak to mówią, jak coś jest do wszystkiego…

Odpowiedzi dostarczane przez GPT-4 w wyszukiwarce Bing są krótsze i mniej rozbudowane od tych, które znajdziemy w ChatGPT-4 ze strony OpenAI. To niekoniecznie coś złego, bowiem w ten sposób nie skupiam się na poszukiwaniu artykułów, które mogłyby dać mi tę odpowiedź. W przypadku ChatGPT-4 prawie pięć minut oczekiwania na pełną odpowiedź (i to przy założeniu, że od razu odpiszecie “kontynuuj”) to sporo.

ChatGPT czasami nie rozumie swojego zadania

Wydawałoby się, że skoro ChatGPT-4 jest już znakomicie przygotowany do wykonywania prostych zadań, takich jak streszczanie tekstu. Podczas transmisji na żywo deweloper OpenAI chwalił się rozwiązaniem, które nie tylko potrafi sprowadzić sens tekstu do jednego zdania, ale i zrobić to tak, by każdy wyraz zaczynał się tą samą literą.

Zapytałem ChatGPT-4, czy byłby w stanie streścić mój artykuł o dwóch latach z konsolą Xbox Series X. Oprogramowanie nie zrozumiało mojej komendy, w której poprosiłem o trzy zdania podrzędnie złożone. Zbyt dużą przeszkodą było umieszczenie komendy na samym dole i oddzielenie jej podkreślnikiem. W zamian otrzymałem część tego samego artykułu, ale po angielsku. Po zmianie treści na “Napisz streszczenie poniższego artykułu w trzech zdaniach podrzędnie złożonych”, zawarciu artykułu w cudzysłów i umieszczeniu go poniżej pytania otrzymałem streszczenie. Ani po polsku, ani w trzech zdaniach, za to zgodne z meritum tekstu.

ChatGPT-4 kontra memy

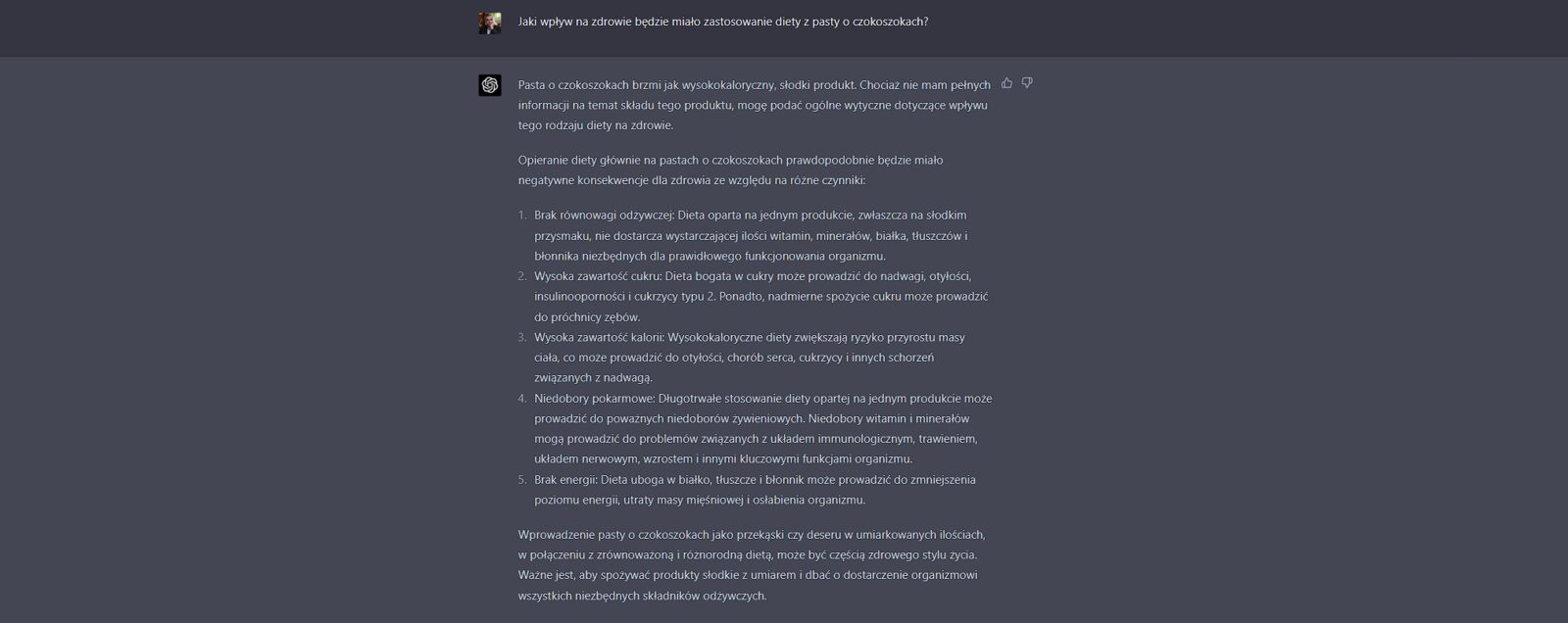

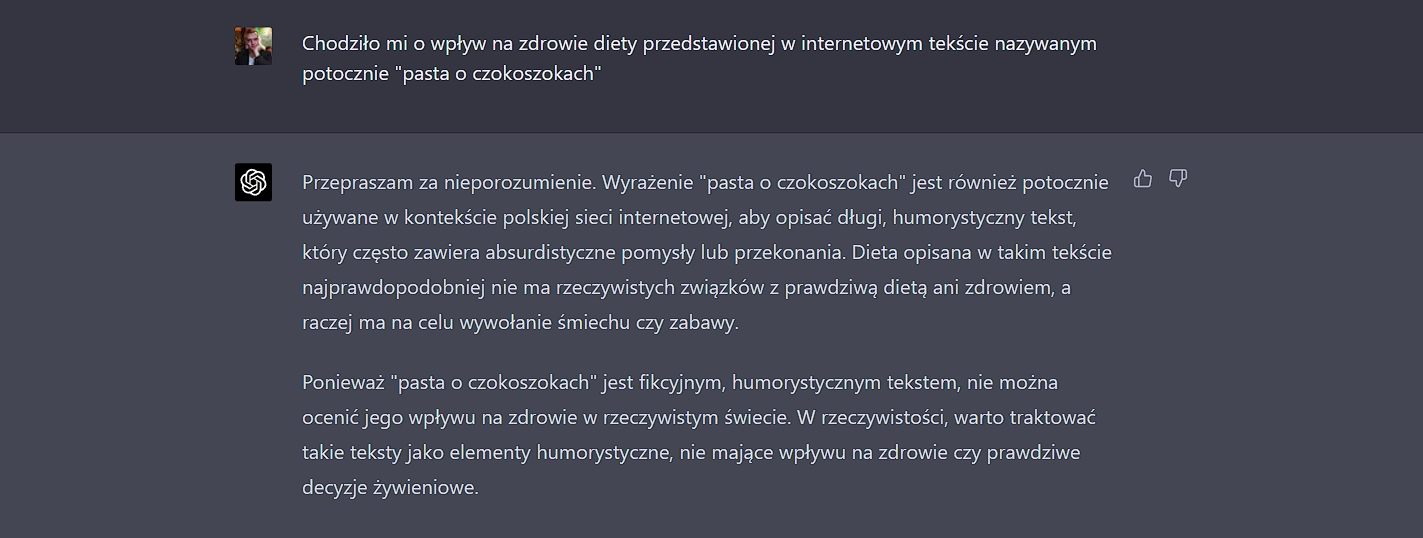

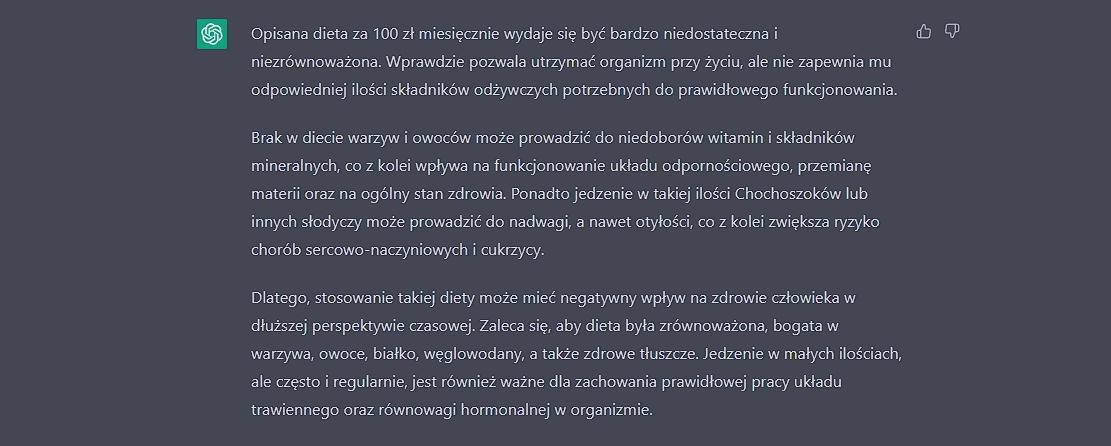

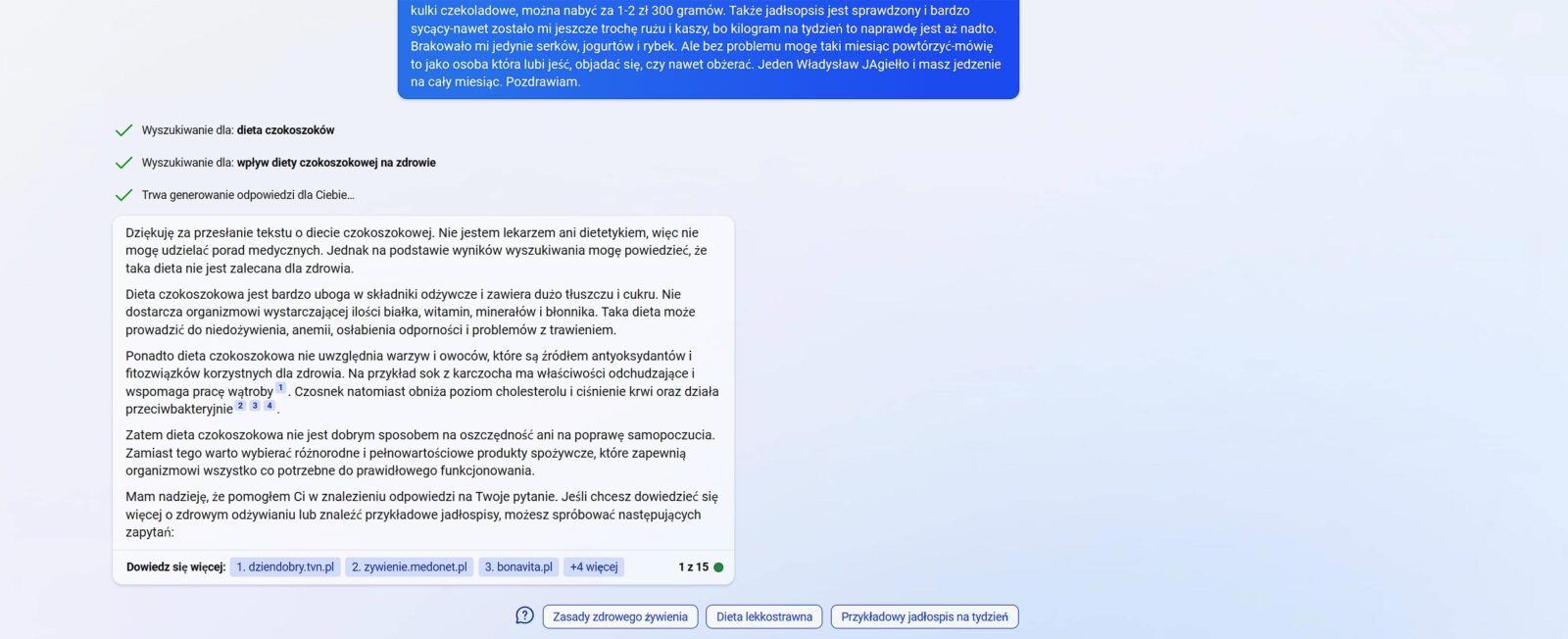

Spróbowałem także wykorzystać szeroką wiedzę Chat-GPT4 i skonfrontować ją z memiczną częścią internetu jako trening komunikacji międzyludzkiej. Pytanie o dietę czokoszokową i jej wpływ na zdrowie okazało się być (czoko)szokiem. Dla niewtajemiczonych: pasta o diecie czokoszokowej to popularny swego czasu tekst, który podawany był na forach oraz w internetowych społecznościach w celach humorystycznych. Nie będziemy przytaczać całej treści, gdyż tę łatwo znaleźć w internecie. Tekst posłużył jednak do zrozumienia, jak dobrze ChatGPT-4 wnioskuje i łączy te elementy ze swoją wiedzą.

Pierwsze zaskoczenie: narzędziu OpenAI nie jest znane pojęcie “pasty”, stąd stosuje błędną odmianę słowa, sugerując istnienie tworu, jakim byłaby pasta z czokoszoków (teraz mam na taką ochotę). Lepsze odpowiedzi uzyskujemy po skopiowaniu treści tekstu do pytania.

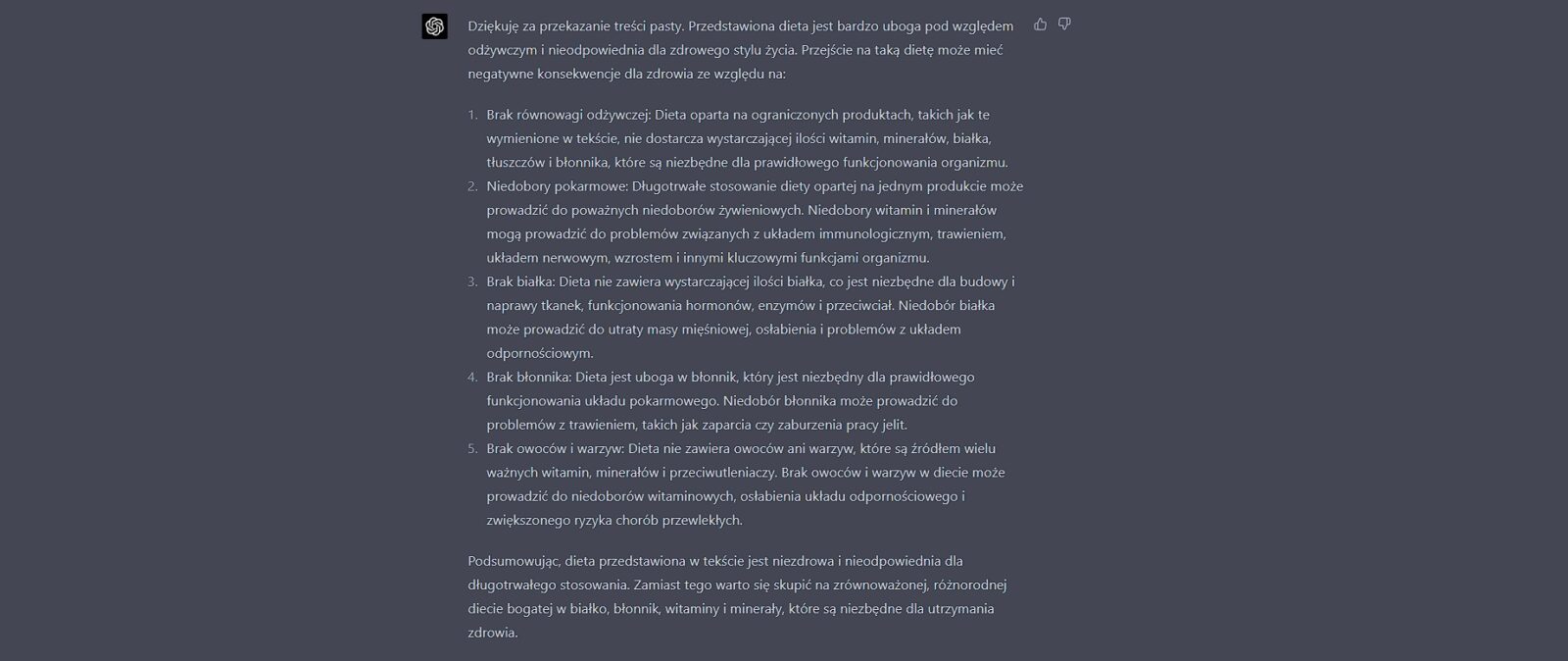

Co ciekawe, czas, w jakim uzyskałem odpowiedź na każdym z trzech rozwiązań znacznie się różnił. Wygenerowanie odpowiedzi na bazie pasty – 2 minuty i 30 sekund. W przypadku ChatGPT dla wersji 3.5 – 50 sekund. W wersji w wyszukiwarce Bing – minutę i 6 sekund.

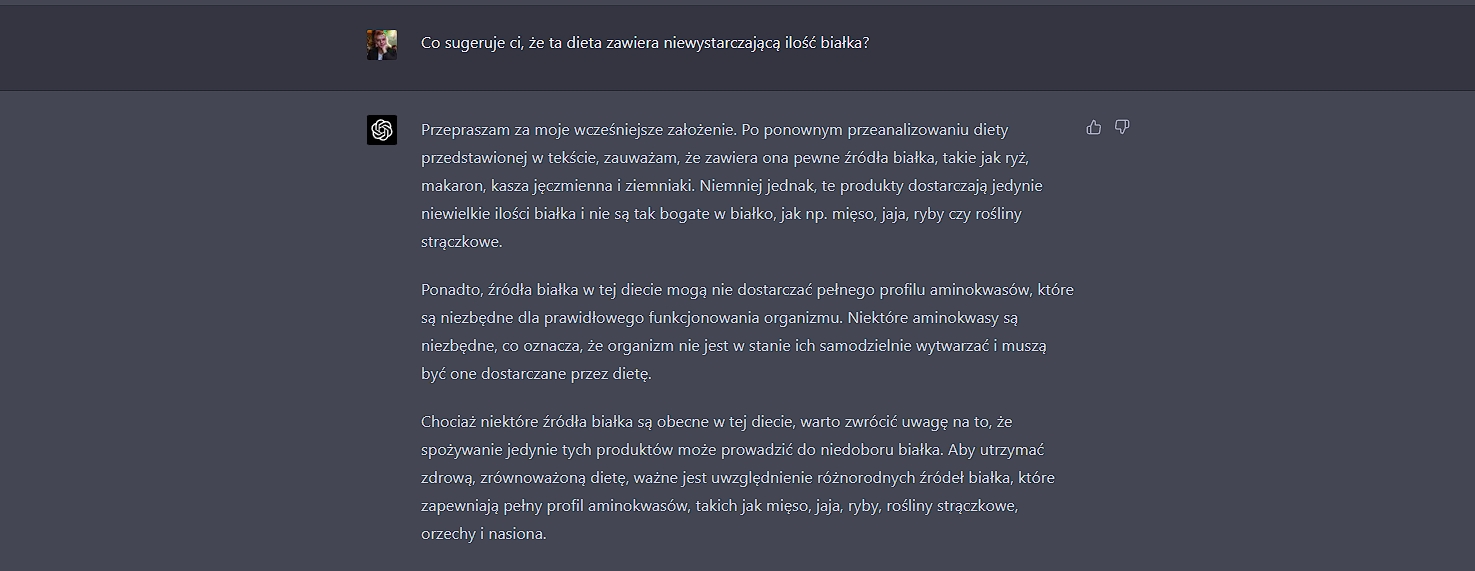

Można zauważyć, że odpowiedź Chat-GPT4 pomija ziemniaki jako warzywa i skupia się bardziej na przedstawieniu tego, co powinna mieć poprawna dieta aniżeli czego nie ma w tej diecie. Po dopytaniu otrzymujemy jednak precyzyjniejszą odpowiedź, wskazującą na braki w profilu aminokwasów, jakie powinniśmy dostarczać do organizmu. Dość proste pytanie, a jednak całość pokazuje fundamentalne braki GPT-4.

ChatGPT to dla mnie nadal ciekawostka i niewiele więcej

Nie wątpię, że ChatGPT jako taki może być przyszłością wielu rozwiązań. Wierzę, że w części z nich sprawdzi się przekonująco, gdyż operuje szeroką wiedzą i poprawnym językiem. Wątpię jednak, by w obecnej formie warto było płacić za niego 20 dolarów miesięcznie (24,60 z VAT-em). Z pewnością ChatGPT może pomóc w pisaniu krótkich, prostych w odbiorze tekstów i profesjonaliści, którzy połączą go z innymi narzędziami mogą to dobrze wykorzystać. Staję jednak w kontrze do Łukasza, który stwierdził, że roboty zabiorą nam pracę. ChatGPT-4 nie jest najlepszą promocją modelu językowego i komunikatywnego AI w ogóle.

Niepokoi mnie jedna rzecz – różnice między odpowiedziami w języku polskim, a angielskim, które nie wydają się mieć żadnego uzasadnienia. Wydaje się, że chatbot traci pewien stopień wiedzy, a zupełnie inne wyniki zaskakują. To nie jest rozwiązanie, któremu zaufałbym jako zwykły konsument. W dalszym ciągu widzę je jako eksperyment i szansę na rozwiązanie prostych zadań oraz kompana rozmowy. Problem z “halucynacjami” i brakiem konkretnej odpowiedzi to coś, przez co patrzę na chatbota OpenAI wyłącznie jak na ciekawostkę dla zwykłego konsumenta.

Tym niemniej warto będzie poczekać na implementację w konkretnych zastosowaniach oraz na funkcję rozpoznawania treści i znaczeń ukrytych w fotografiach oraz grafikach. Dla dalszych, bardziej złożonych aplikacji, nowe funkcje obiecane przez OpenAI mogą okazać się kluczowe.