Możemy mieć 360 Hz, świetną matrycę i mocną kartę, a mimo to w dynamicznej grze FPS obraz nadal będzie mniej czytelny w ruchu, niż byśmy tego chcieli. W tym miejscu zaczyna się prawdziwa walka o jakość percepcyjną. Nie chodzi już o to, czy monitor “ma VRR” i ile razy odświeża się na sekundę, tylko o to czy w dynamicznej grze potrafisz utrzymać ostrość celownika i śledzić ruch przeciwnika bez wrażenia, że wszystko się rozmazuje. NVIDIA próbuje wejść dokładnie w tę szczelinę między płynnością a ostrością i tak właśnie dochodzimy do G-SYNC Pulsar, czyli pomysłu na połączenie dwóch światów, które do tej pory zwykle się wykluczały.

Dlaczego G-SYNC był w ogóle potrzebny?

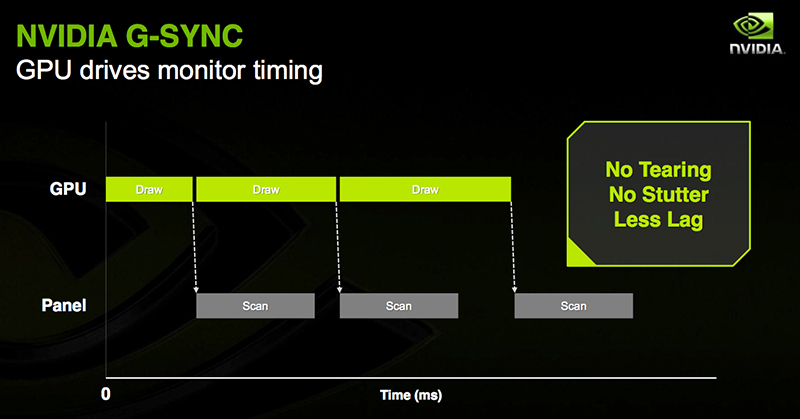

Żeby zrozumieć, skąd bierze się sens G-SYNC Pulsar, trzeba cofnąć się do czasów, gdy największym problemem nie był motion blur, a sama synchronizacja. Klasyczny monitor LCD odświeża obraz w stałym rytmie, a GPU renderuje poszczególne klatki w rytmie zmiennym. Gdy te dwa zegary się rozmijają, dostajemy tearing, czyli rwanie obrazu, które przejawia się tym, że fragmenty dwóch różnych klatek pojawiają się w jednym cyklu odświeżenia. Jeśli włączasz starodawny wręcz V-Sync, ten tearing znika, ale pojawia się inna kara: wzrost opóźnień i szarpnięcia w momentach, gdy GPU nie wyrabia z utrzymywaniem płynności. W praktyce więc gracze latami wybierali między złą a gorszą wersją tego samego problemu.

Czytaj też: Komputer lub laptop zamula na starcie? Pozbądź się problemu w kilka kliknięć

G-SYNC pojawił się jako odpowiedź stricte inżynierska: skoro GPU nie potrafi renderować idealnie równo, to monitor powinien przestać być w tej układance nadrzędny. Cała idea G-SYNC i wszelkich pochodnych technik VRR (Variable Refresh Rate) polega na tym, że wyświetlacz nie odświeża się “co X milisekund”, tylko czeka na gotową klatkę i dopiero wtedy wykonuje kolejne odświeżenie. To proste w koncepcji, ale w praktyce długo było trudne w realizacji w sposób powtarzalny. NVIDIA poszła w rozwiązanie sprzętowe, bo dedykowany moduł w monitorze miał gwarantować kontrolę nad zachowaniem matrycy, stabilne działanie VRR i przewidywalną jakość w szerokim zakresie klatek. To podnosiło koszt sprzętu, ale dawało efekt, który wtedy był wielką zmianą, bo gwarantował mniej tearingu, mniej stutteru i sensowniejszą responsywność przy niestabilnym poziomie klatek na sekundę.

Jak narodził się “G-SYNC Compatible” i po co był w ogóle ten kompromis?

Z czasem rynek zrobił coś, co zwykle robi, czyli poszedł w standaryzację. Adaptive-Sync (VRR) zaczął funkcjonować jako element ekosystemu DisplayPort, a AMD pod marką FreeSync wypchnęło VRR do masowych monitorów, często tańszych i bez specjalnych modułów. To z marszu zmieniło układ sił, bo VRR przestał być “premium dodatkiem”, a stał się funkcją, którą dostajemy dziś nawet w średniej półce monitorów. Dla NVIDII problem ten był podwójny. Z jednej strony użytkownicy kart GeForce chcieli korzystać z VRR na monitorach z Adaptive-Sync, a z drugiej jakość wdrożeń VRR w tanich monitorach była nierówna. Pojawiały się typowe artefakty: migotanie, pulsowanie jasności, chwilowe czernienie obrazu czy nawet dziwne zachowanie overdrive (to funkcja skracająca czas włączania piksela w celu zmniejszenia czasu reakcji panelu) przy zmianach odświeżania.

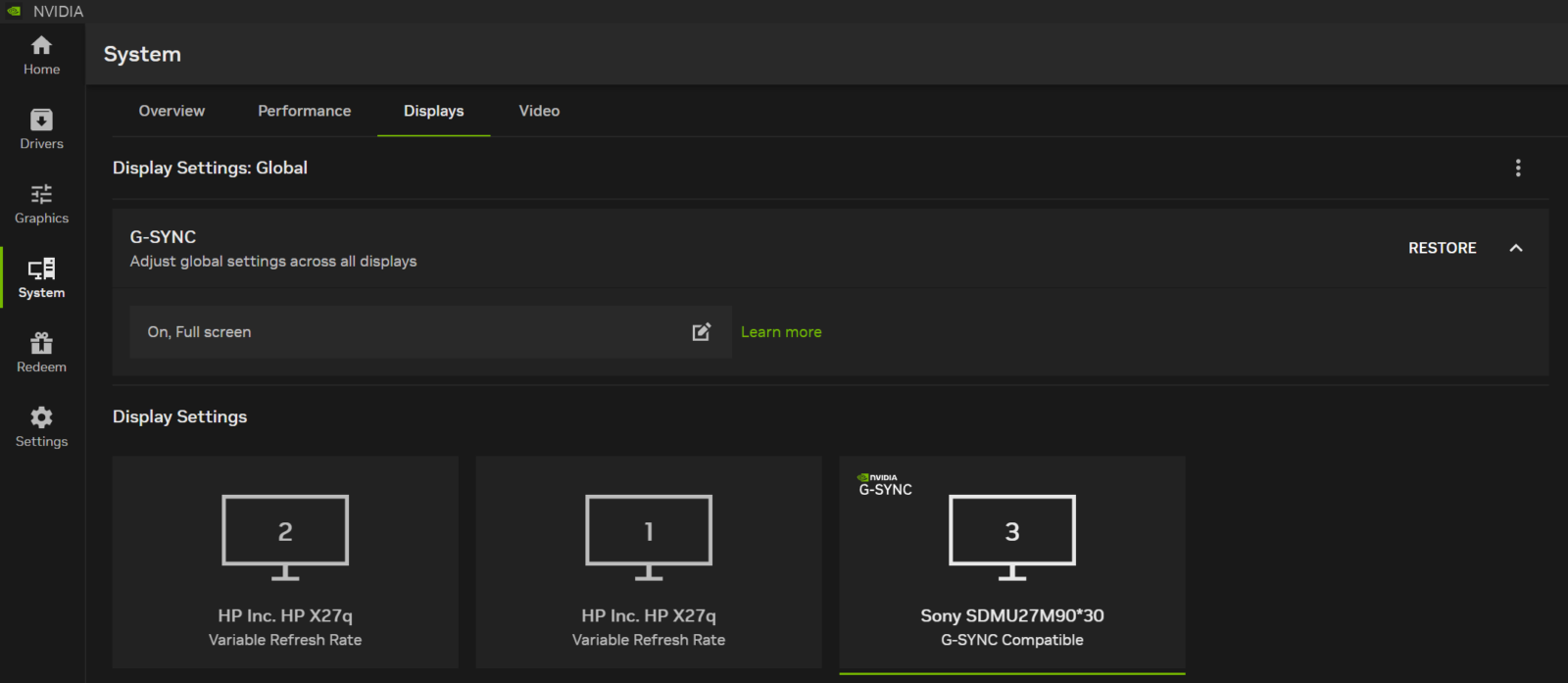

Tutaj właśnie pojawił się “G-SYNC Compatible” jako pragmatyczna odpowiedź: wsparcie dla VRR na monitorach Adaptive-Sync, ale z jednoczesną walidacją wybranych modeli, które spełniają bazowe kryteria jakości. NVIDIA oficjalnie ogłosiła program i listę pierwszych zweryfikowanych monitorów przy okazji CES 2019, zaznaczając, że przetestowała setki konstrukcji, a na start tylko część spełniła wymagania. To był moment, w którym “G-SYNC” przestał oznaczać wyłącznie “monitor z modułem”.

Czytaj też: Czy OLED to najlepszy wybór? Dlaczego panel OLED wciąż nie rządzi w VR i handheldach?

Wszystko to doprowadziło do powstania “hierarchii” na rynku. Na samym dole występują monitory odznaczające się ot kompatybilnością z Adaptive-Sync (z naciskiem na brak podstawowych problemów), wyżej uplasował się pełniejszy pakiet funkcji w monitorach projektowanych stricte pod ekosystem NVIDII, a do segmentu premium zawitały dodatkowe wymagania dotyczące np. HDR czy opóźnień. Dla graczy na całym świecie miało to prosty skutek: VRR przestał być binarnym wyborem “drogi G-SYNC albo nic”, a stał się cechą dostępniejszą cenowo, ale nadal warto było patrzeć, czy dany model jest sprawdzony, bo “VRR działa” nie zawsze znaczy “VRR działa dobrze”.

Rynek monitorów gamingowych w 2026

Dziś rynek jest jednocześnie dojrzały i rozedrgany. Dojrzały, bo VRR stał się standardem w praktycznie każdej sensownej półce cenowej, a wysokie odświeżanie nie jest już egzotyką. Rozedrgany, bo segmenty zaczęły się specjalizować. Inaczej wybiera monitor ktoś, kto gra głównie w FPS-y i liczy milisekundy, inaczej ktoś, kto chce HDR i kontrast, a jeszcze inaczej ktoś, kto pracuje i dopiero wieczorem odpala grę.

Największa zmiana ostatnich lat to wejście OLED-ów do mainstreamu gamingowego przez znaczny spadek ich ceny. Szybki czas reakcji pikseli i perfekcyjna czerń sprawiły, że dla wielu osób OLED stał się oczywistym kierunkiem, nawet jeśli trzeba zaakceptować kompromisy typu ostrożność przy statycznych elementach wyświetlanych w codziennej pracy. W Polsce da się już kupić 32-calowe OLED-y 4K z 240 Hz w cenach około 3799 zł, co jeszcze niedawno brzmiało jak poziom nieosiągalny. Jednocześnie w porównywarkach cen widać, że 240-hercowe OLED-y zaczynają się poniżej 2000 zł, a kończą w okolicach 6000-7000 zł, czyli realnie rozwarstwiają się bardziej funkcjami i rozmiarem niż samą technologią.

Równolegle rośnie segment “e-sportowych IPS-ów”, a więc połączenia 27 cali, 1440p i 360 Hz, często z bardzo agresywną optymalizacją pod eliminację efektu smużenia. Jest to wprawdzie wciąż stara dobra technologia LCD, ale dopracowana pod kątem reakcji i minimalizacji efektów ubocznych przy bardzo wysokim odświeżaniu. Pierwsze modele z rozwiązaniami pokroju Pulsara zaczynają już teraz pojawiać się w regularnej sprzedaży w Polsce, a ceny (przynajmniej na starcie) potrafią kręcić się wokół 2999 zł w dużych sklepach.

Na horyzoncie widać też wyścig na ekstremalne liczby, bo 500 Hz w OLED, tryby dual-mode, a nawet prezentacje konstrukcji reklamowanych jako ponad 1000 Hz w niskiej rozdzielczości. To jeszcze nie jest codzienność w koszyku polskiego klienta, ale pokazuje kierunek, że producenci szukają już nie tyle “więcej Hz”, co sposobu, by te herce przekuć w realnie ostrzejszy obraz w ruchu.

Dlaczego VRR i strobing do tej pory się gryzły?

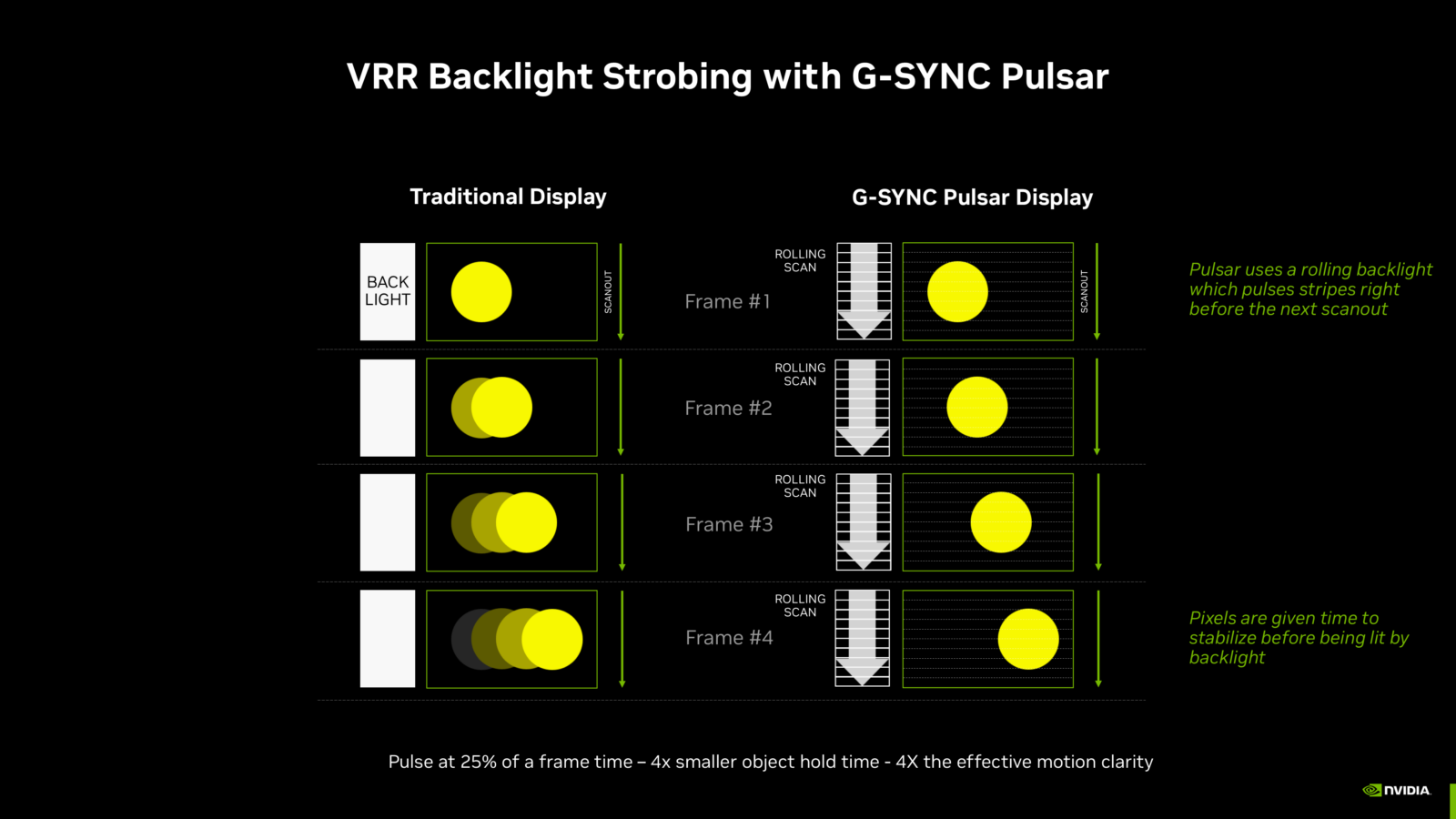

Nawet jeśli piksele reagują szybko (a w OLED-ach reagują bardzo szybko), to obraz jest “utrzymywany” przez czas trwania klatki, co podczas ruchu oka przekłada się na postrzegane rozmazanie. Najprostszym sposobem na poprawę ostrości jest tak zwany strobing podświetlenia albo wstawianie czarnych klatek, bo wtedy ekran świeci krócej, a mózg dostaje węższy “impuls” obrazu, który jest bardziej podobny do tego, co dawały starodawne dziś CRT.

Czytaj też: PC, konsola czy handheld w 2026 roku? Czy warto kupować nowy sprzęt do grania?

Problem w tym, że klasyczny strobing lubi stały rytm. Gdy odświeżanie zmienia się klatka po klatce, to trzeba za każdym razem na nowo dobrać moment i długość impulsu, zsynchronizować to z zakończeniem przejść pikseli, dopilnować, żeby nie powstawały inne artefakty, a na dodatek zadbać o to, żeby jasność nie pływała w sposób męczący dla wzroku. Dlatego większość monitorów do tej pory mówiła graczowi wprost: wybierz jedno – VRR albo redukcję rozmycia. Próby łączenia tych trybów istnieją, ale są na tyle zależne od konkretnego panelu i elektroniki, że trudno mówić o przewidywalnym standardzie.

Co zmieni G-SYNC Pulsar firmy NVIDIA?

G-SYNC Pulsar jest w założeniu próbą “zrobienia strobingu na poważnie” w środowisku VRR. NVIDIA opisuje to jako adaptacyjne dostrajanie impulsów podświetlenia do zmieniającego się czasu generowania klatek, a to wszystko tak, żeby VRR działał dalej, ale jednocześnie każda klatka była prezentowana krócej, co ma ograniczać motion blur bez klasycznych kosztów w postaci dodatkowego opóźnienia.

W materiałach NVIDII pojawia się chwytliwy przekaz o “ponad 1000 Hz postrzeganej ostrości ruchu” dzięki pulsowaniu podświetlenia oraz sugestia, że przy określonych FPS-ach efekt ma być wielokrotnie lepszy niż sama częstotliwość odświeżania. W praktyce najważniejsze jest jednak nie hasło, tylko mechanika, która za nim stoi G-SYNC Pulsar ma synchronizować nie tylko impuls podświetlenia, ale też zachowanie overdrive tak, by ograniczyć smugi i “przebitki” typowe dla źle zestrojonego strobingu. Partnerzy sprzętowi NVIDII opisują to właśnie jako sprzężenie strobingu z cyklem odświeżania i parametrami panelu, a nie prosty tryb “migania”.

Istotny jest też wątek komfortu i zakresu działania. Eksperci w temacie z serwisu Blur Busters zwracają uwagę, że G-SYNC Pulsar ma korzystać ze skanującego strobingu, co z definicji bywa mniej męczące niż globalne błyskanie całego ekranu naraz, a do tego zakres minimalnych częstotliwości ma zostać poszerzony i objąć nawet okolice 60 Hz.

Największa zmiana rynkowa może jednak nie wynikać z samego algorytmu, tylko z dostępności. NVIDIA już wcześniej była krytykowana za to, że pełny “pakiet” G-SYNC wiązał się z droższymi konstrukcjami i specjalnym modułem. W 2024 roku firma ogłosiła jednak współpracę z MediaTekiem, która ma pozwolić integrować funkcje klasy G-SYNC bez osobnego modułu w monitorach i właśnie w tym komunikacie Pulsar jest wymieniany jako jedna z technologii, które mają na tym skorzystać.

Czy to rewolucja w monitorach, czy kolejny tryb “dla wybrednych”?

Najuczciwiej jest patrzeć na Pulsar jako na ruch w stronę nowego priorytetu i co tu dużo mówić, kolejnego powodu, aby zachęcić graczy do wymiany sprzętu na nowy. Tearing jest dziś w dużej mierze rozwiązany przez VRR, opóźnienia są dopieszczane przez cały ekosystem (sterowniki, tryby niskiej latencji, Reflex), a różnice w responsywności zaczęły się spłaszczać. Dlatego teraz producenci szukają przewagi tam, gdzie gracz odczuwa ją natychmiast, czyli w czytelności ruchu.

G-SYNC Pulsar to ewidentnie nie jest technologia, która nagle podwoi liczbę FPS, ale może sprawić, że te wszystkie klatki będą wyglądały bardziej tak “jak powinny”, a to zwłaszcza w szybkich grach, gdzie oko wykonuje ciągłe mikroruchy. Pamiętajmy jednak, że strobing zawsze niesie koszty, bo spadek jasności, możliwe artefakty, a nawet potencjalne zmęczenie oczu u co wrażliwszych osób. Pulsar obiecuje ograniczyć kompromisy, ale dopiero realne testy w różnych panelach pokażą, czy to będzie nowy standard jakości, czy raczej funkcja dla tych, którzy świadomie wybierają monitor pod jeden scenariusz gry.