Kiedy w grę wchodzi sprzęt obliczeniowy inspirowanym mózgiem, czyli neuromorficzny, to jego największym ograniczeniem bardzo często nie bywa sama moc obliczeniowa, ale pamięć i sposób, w jaki przechowuje ona “siłę połączeń”, a więc odpowiednik wag synaptycznych. Klasyczne układy cyfrowe są genialne w precyzji i powtarzalności, ale z natury lubią binarność. Mózg jednak jej nie potrzebuje. Właśnie dlatego badacze od lat polują na elementy, które potrafią stabilnie trzymać wiele stanów pośrednich, a to najlepiej bez stałego zasilania.

Dlaczego neuromorfika tak bardzo potrzebuje pamięci wielostanowej?

W sieciach neuronowych waga połączenia nie jest w praktyce tradycyjnym dla aktualnej logiki komputerowej “tak” albo “nie”. Jest to liczba często zmieniana małymi krokami podczas uczenia. Gdy próbujemy przenieść ten proces do sprzętu, to od razu pojawia się klasyczny zgrzyt: albo trzymamy wagi w pamięci cyfrowej i płacimy energią za ciągłe przerzucanie danych, albo próbujemy robić to “w miejscu” (in-memory computing), gdzie sama pamięć staje się częścią obliczeń.

Czytaj też: Naukowcy zbudowali sztuczne oko inspirowane owadami. Drony dostaną zmysł, który trudno będzie zaskoczyć

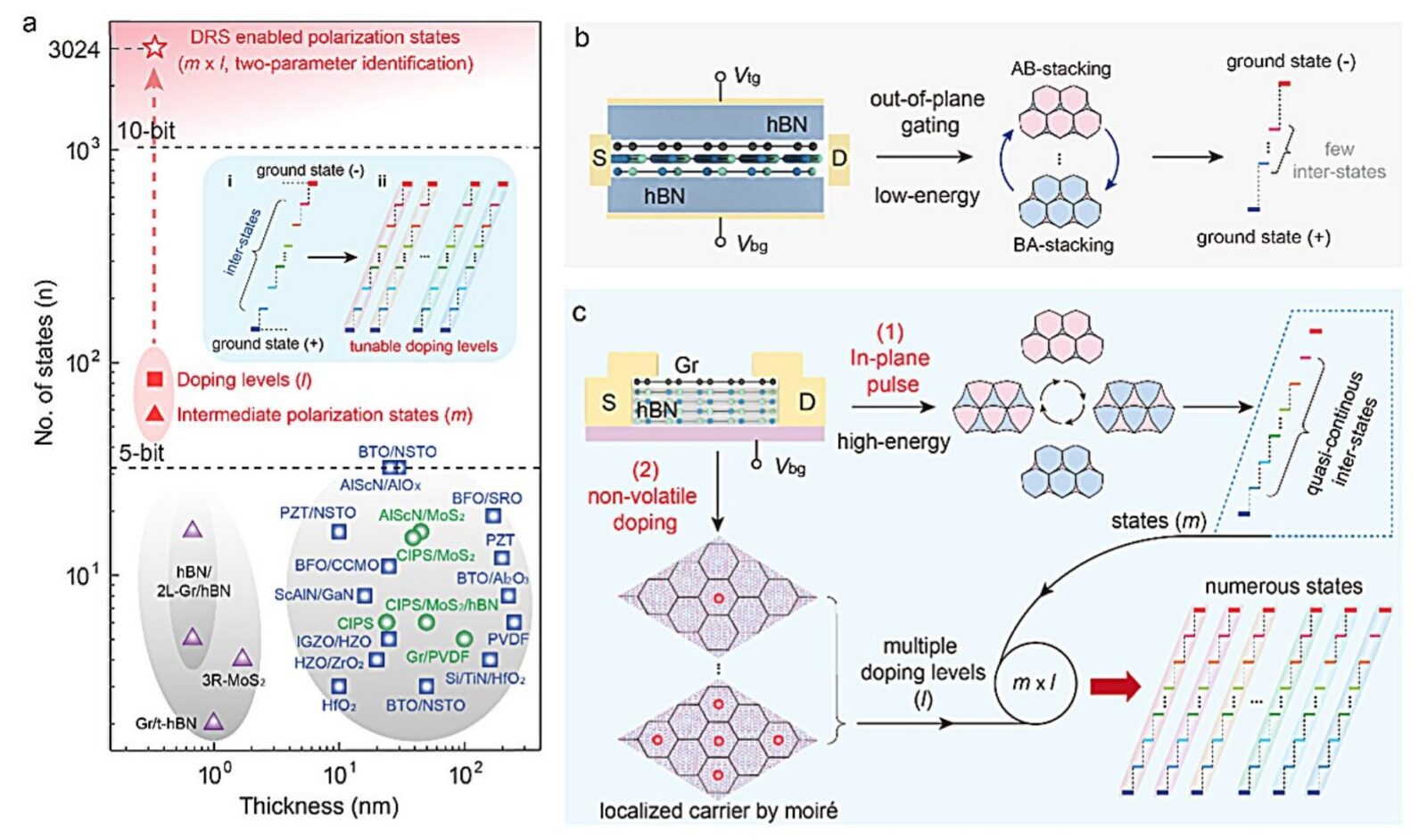

W tym drugim podejściu wielostanowość jest jak dodatkowa rozdzielczość, bo im więcej stabilnych poziomów chcemy uzyskać, tym mniej brutalna staje się kwantyzacja, a to potrafi przełożyć się na jakość i efektywność. Tutaj właśnie wchodzi ferroelektryczność, a więc zjawisko, w którym materiał ma spontaniczną polaryzację elektryczną i potrafi ją utrzymać nawet po odłączeniu zasilania. Jest to idealny kandydat na pamięć nieulotną, a przy okazji na elementy, które zachowują się trochę jak synapsy. Problem w tym, że “idealny” kandydat w laboratorium nie zawsze jest idealny w skali nanometrów, gdzie domeny, defekty i fluktuacje zaczynają dyktować warunki.

Trik z przesuwaniem warstw, czyli ferroelektryczność w 2D

W ostatnich latach mocno wybrzmiała inna ścieżka, bo to, że ferrolektryczność niekoniecznie musi pochodzić z klasycznego kryształu ferroelektrycznego. Można ją “zaprojektować” przez ułożenie i minimalne przesunięcia ultracienkich warstw van der Waalsa. Dla heksagonalnego azotku boru (hBN) już wykazano, że odpowiednie połączenie dwóch warstw potrafi wytworzyć polaryzację przełączalną napięciem i widoczną w pomiarach transportowych i to także w temperaturze pokojowej.

Czytaj też: Nowe metamateriały z MIT mogą wchłaniać uderzenia jak kontrolowana poduszka powietrzna

W kolejnych pracach badano nawet pamięci o bardzo wysokiej wytrzymałości i szybkim przełączaniu oparte na takim “ślizgowym” mechanizmie. Warto o tym pamiętać, bo sugeruje to coś nieoczywistego – fakt, że czasem kluczową “gałką” nie jest skład chemiczny, a tylko geometria i relacja między warstwami. Jeśli z kolei relację da się kontrolować elektrycznie, to nagle pojawia się perspektywa pamięci, która jest ultracienka i potencjalnie łatwiejsza do upakowania niż klasyczne struktury.

Tutaj właśnie wchodzi praca naukowa opublikowana w połowie stycznia 2026 roku w Nature Electronics. Stojący za nią zespół z Nanjing University of Aeronautics and Astronautics opisuje w pracy właśnie “ślizgowy” tranzystor ferrolektryczny zbudowany z monowarstwy grafenu na hBN. Kluczowy jest tu nie tylko sam zestaw materiałów, ale też fakt, że przy bardzo małym niedopasowaniu ułożenia powstaje wzór moiré, czyli periodyczna “mapa” potencjału, która potrafi lokalizować nośniki i zmieniać krajobraz energetyczny układu.

Skąd biorą się tysiące stanów w jednym tranzystorze?

Najbardziej konkretna część tej historii zaczyna się od pozornie prostego pomysłu, bo tego, że jeśli damy radę uzyskać wiele stanów polaryzacji w jednym trybie pracy, a potem powielimy to przez wiele poziomów domieszkowania (czyli różnych gęstości nośników sterowanych bramką), to liczba rozróżnialnych stanów rośnie wykładniczo. Autorzy zresztą raportują już ponad 36 quasi-ciągłych stanów polaryzacji, gdy układ jest sterowany wyłącznie impulsami źródło-dren przy jednym poziomie domieszkowania. Gdy dołożą napięcie bramki i przejdą przez 84 poziomy domieszkowania, dostają łącznie 3024 fizycznie różne stany (36 x 84) w temperaturze pokojowej. Twierdzą też, że typowe systemy wielostanowe były wcześniej ograniczane do około 32 stabilnych stanów w temperaturze pokojowej, więc skok jest rzędu dwóch rzędów wielkości, czyli około 100x.

Równie istotne jest pytanie o stabilność. Praca podaje, że stany utrzymują się ponad 105 sekund (około 27,8 godziny) oraz że potencjalnie mogłyby przetrwać nawet 10 lat, co brzmi jak ekstrapolacja, a nie deklaracja “zmierzyliśmy dekadę”. To rozróżnienie warto mieć z tyłu głowy, bo w pamięciach nieulotnych “jeden dzień” i “dekada” to przepaść, a droga między nimi bywa usłana efektami starzenia, dryftu i wrażliwości na warunki.

Czytaj też: Miały pękać, a wytrzymują. Najbardziej bezczelny pomysł na elektronikę od lat

W tle autorzy wskazują na dwa mechanizmy, które mogą tłumaczyć tak dużą liczbę stanów: ruch ścian domen polarnych oraz wpływ potencjału moiré, lokalizujący wstrzykiwane nośniki. To akurat jest ten moment, w którym materiałoznawstwo spotyka się z “inżynierią krajobrazu energetycznego”, w którym łatwo o wyniki świetne w jednym typie próbki, a trudniejsze do powtórzenia w innej.

93,53% skuteczności i pytanie, co to naprawdę znaczy?

W streszczeniu pracy pojawia się jeszcze jeden haczyk: symulacja kwantyzacji podczas uczenia głębokiej sieci resztkowej z użyciem 3024 stanów ma dawać skuteczność rozpoznawania “modowych obrazów” na poziomie około 93,53%, a więc porównywalną z obliczeniami zmiennoprzecinkowymi. Chociaż brzmi to jak argument “to nie tylko sztuka dla sztuki”, ale warto pamiętać, że mowa o symulacji, a nie o kompletnym układzie neuromorficznym, który faktycznie wykonuje trening i inferencję w krzemie, z całym bagażem szumów, rozrzutu parametrów i ograniczeń odczytu.

Tech Xplore zwraca uwagę, że warstwy grafenu i hBN pozyskiwano metodą mechanicznego złuszczania, a heterostrukturę składano transferem “na sucho”, po czym wykonano elektrody źródło-dren przez naparowywanie metalu wiązką elektronów. Jest to standardowy, bardzo precyzyjny zestaw technik laboratoryjnych, ale też zestaw, który z definicji nie mówi jeszcze nic o skali wafla i uzysku produkcyjnego. Zresztą sami autorzy wskazują jako kolejny krok przejście w stronę rozwiązań skalowalnych i poprawę szybkości reakcji, trwałości oraz liczby stanów. To akurat jest ważne, bo historia elektroniki jest pełna “rekordów” osiąganych w pojedynczych urządzeniach, które potem latami nie chciały wyjść poza warunki laboratoryjne.

W ferroelektryczności i urządzeniach wielostanowych dochodzi jeszcze jeden problem: im więcej poziomów, tym powstaje większa presja na rozdzielczość odczytu i odporność na dryft. Jeśli z kolei poziomy są quasi-ciągłe, to pojawia się pytanie, ile z nich jest użytecznych w praktyce bez agresywnej korekcji błędów? Jeśli w tym wszystkim znajduje się jakikolwiek “moment przełomu”, to nie polega on na tym, że jutro kupimy w sklepie komputer neuromorficzny. Polega bardziej na pokazaniu, że w ultracienkim układzie van der Waalsa da się realnie manipulować tysiącami stanów polaryzacji w temperaturze pokojowej, a nie w warunkach, które przypominają laboratorium kriogeniczne. Innymi słowy, stanowi to potwierdzenie, że ferrolektryczność w 2D i mechanika przesuwania warstw to nie tylko ciekawostka, ale narzędzie do projektowania pamięci.