Obecnie większość komputerowych systemów wizyjnych jest daleka od wszelkich norm i rozsądku. Zła orientacja przedmiotów, to zdecydowanie najmniejszy problem na tle lewitujących obiektów, czy czegoś “wchodzącego” w coś lub “nachodzące” na coś. Chcę przez to powiedzieć, że jeśli mamy coraz bardziej polegać na robotach i systemach automatycznych, a nawet autonomicznych, musimy (nie tyle my, ile specjaliści) postarać się o znaczące ulepszenie tego, jak związane z nimi systemy postrzegają świat.

Jak naukowcy z MIT ulepszyli postrzeganie świata przez komputery.?

Chcemy przecież jeździć w autonomicznych samochodach i latać w taksówkach bez pilotów, zlecać żmudne prace robotom i automatyzować wszystko, co tylko się da, więc zdecydowanie trzeba rozwijać systemy, bazujące na kamerach optycznych. Ostatnio dokonali tego naukowcy z Massachusetts Institute of Technology, prezentując światu swoje najnowsze dzieło – 3DP3, czyli 3D Scene Perception via Probabilistic Programming.

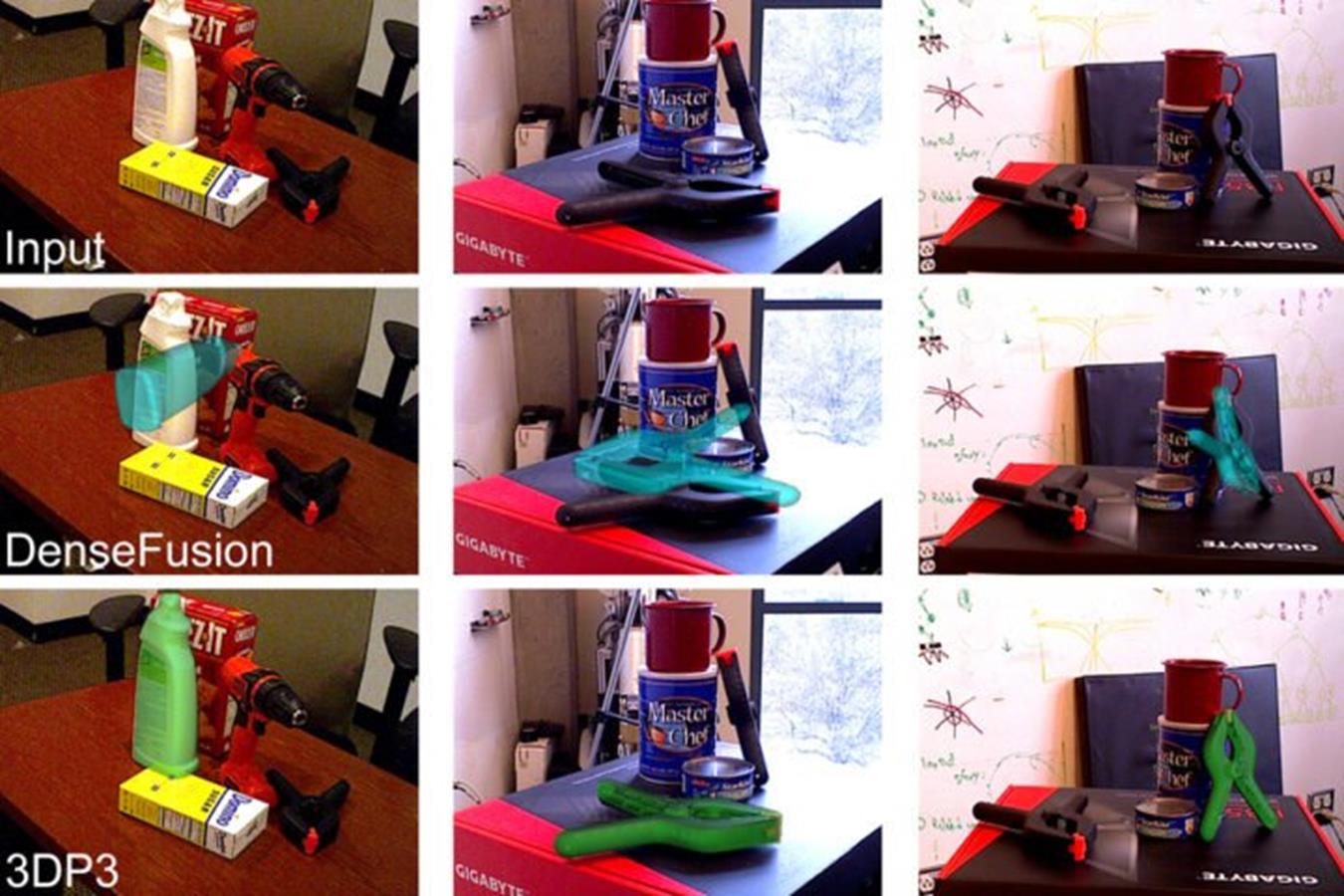

To nowy system sztucznej inteligencji, który próbuje osiągnąć ludzki poziom postrzegania świata i dokonuje tego zadziwiająco dobrze. Uczy się postrzegać obiekty świata rzeczywistego na podstawie zaledwie kilku obrazów i postrzega sceny w kategoriach właśnie tych wyuczonych wcześniej obiektów. Poniżej znajdziecie świetny tego przykład, który porównuje kolejno rzeczywiste zdjęcie z tym odczytanym przez tradycyjny system głębokiego uczenia i wreszcie 3DP3.

Czytaj też: Data premiery trzech nowych kart NVIDIA. Kiedy zadebiutuje RTX 3090 Ti, RTX 3070 Ti 16 GB i RTX 3050?

W obu przypadkach algorytmy miały skupić się na konkretnym przedmiocie i zapewnić badaczom wynik, jak dokładnie go widzą. W testach naukowcy wykazali, że 3DP3 nie ma sobie równych w tym zadaniu i ledwie 5 zdjęć bazowych wystarczyło mu, aby skutecznie działać. Dlatego też teraz odpowiadający za to naukowcy chcą ulepszyć go tak, aby był skuteczny nawet z jednym materiałem źródłowym i sprawdzić jego potencjał do trenowania innych sieci neuronowych.

Czytaj też: Wiązki Szeptów będą ładować roje wojskowych dronów bezprzewodowo

Jeśli idzie o samo opracowanie 3DP3, badacze zainspirowali się koncepcjom z samego początku badań nad sztuczną inteligencją. Zgodnie z nią komputerowe systemy wizyjne mogą być postrzegane jako “odwrotność” grafiki komputerowej, jak wskazuje Technology.org. Z myślą o tym naukowcy opracowali programowanie probabilistyczne, które umożliwia systemowi sprawdzanie wykrytych obiektów w odniesieniu do danych wejściowych, aby sprawdzić, czy obrazy zarejestrowane z kamery są prawdopodobnym dopasowaniem do dowolnej sceny. Co ważne, system jest w stanie rozpoznać ewentualne niedopasowania i je skorygować.